2023 年回顾:聚焦 ChatGPT 时代之后的发展及 2024 年展望 [译]

大语言模型 (LLM) 运营领域如何变革,以及为何尚未见到广泛应用的生成式 AI —— 但 2024 年或有所改变。

去年这个时候,许多人曾猜测 ChatGPT 是否会取代谷歌,但现实并非如此。尤其是谷歌两周前推出了 ChatGPT 的竞争对手 Gemini,这个问题似乎更加值得商榷了。

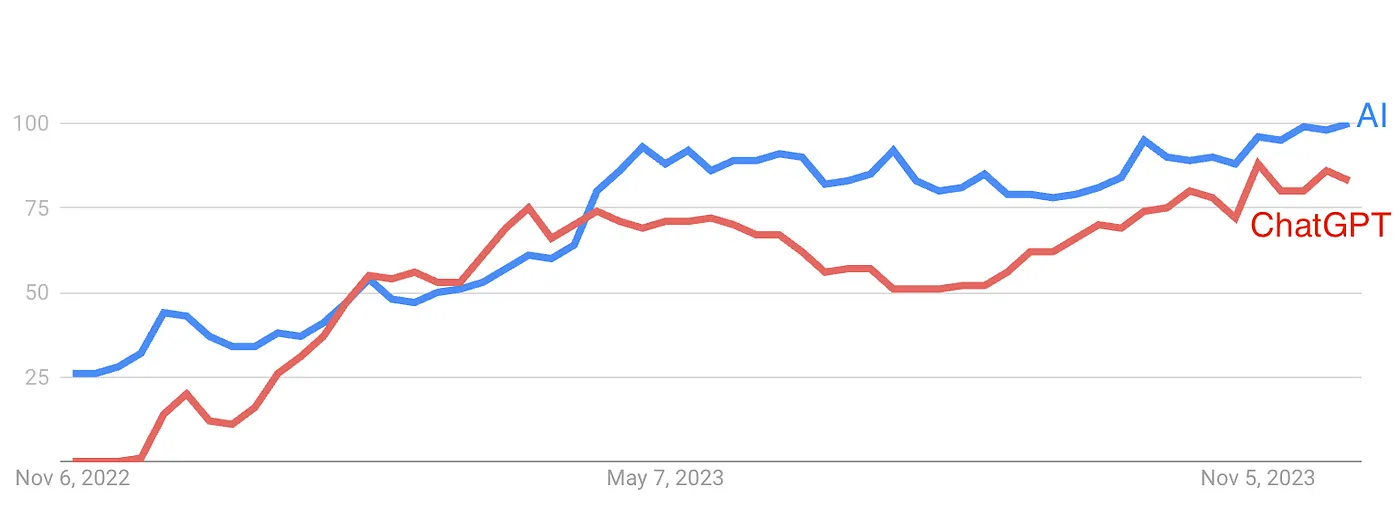

2022 年底 ChatGPT 的面世,极大地激发了 2023 年公众对人工智能 (AI) 尤其是生成式 AI 的兴趣。

你可能曾听闻“AI 冬天”一词,它指的是对 AI 兴趣和投资的减退期。然而,今年我们迎来了一个真正的“AI 夏天”,《经济学人》报道称,风险投资公司在生成式 AI 上的投资超过 360 亿美元。

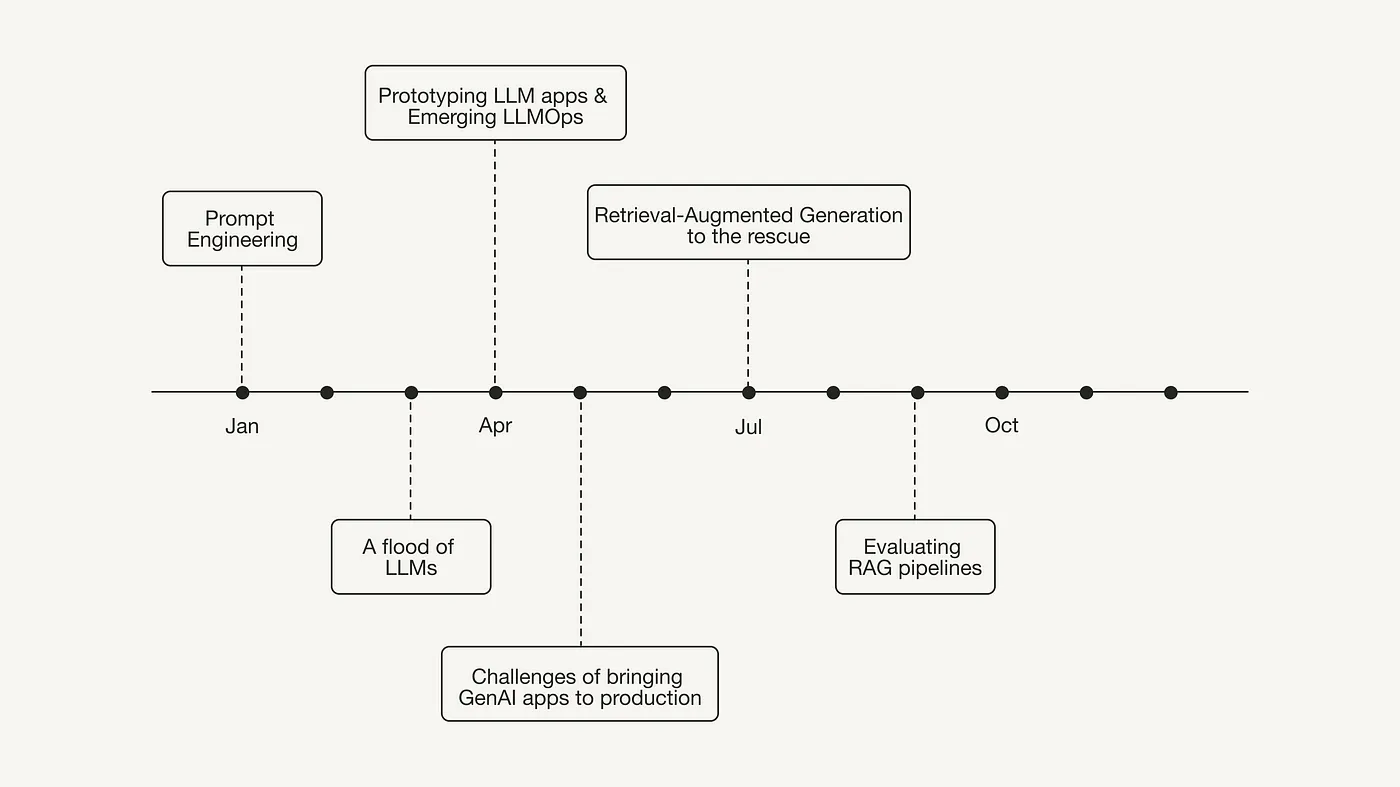

从 1 月开始,人们开始尝试使用 ChatGPT 并逐渐理解其潜力。他们很快发现,提问方式(“提示”)会影响到得到的回答(“回复”)。这种认识促进了对“提示工程”及其最佳实践的关注度上升。

然而,在公众还在对 ChatGPT 的惊人能力感到惊讶并尝试各种提示技巧时,研究界并没有停下探索的步伐。2023 年头几个月,许多人感受到 AI 研究的快速进展让他们难以跟上。2 月底,Meta 发布了 LLaMA,紧接着 AI21 Labs 推出了 Jurassic-2,OpenAI 发布了 GPT-4,Anthropic 带来了 Claude,Technology Innovation Institute 推出了 Falcon-40B,Google 推出了 Bard,Bloomberg L.P. 则发布了 BloombergGPT。

到了 2023 年春天,开发者们已经不满足于仅仅玩 ChatGPT 了。他们整理出了许多创意,比如用大语言模型 (LLM) 来构建求职信生成器、YouTube 视频摘要生成器、个性化问答回答聊天机器人等,准备投入到这些项目的实际开发中。

相较于传统的机器学习(ML)模型,大语言模型(大语言模型,LLMs)或称基础模型(基础模型,FMs)为开发者提供了一个全新的便捷方式:仅通过简单的 API 调用,即可利用这些模型的强大功能。这种新型的 FMs 及其易用性,彻底改变了开发者打造 AI 驱动应用的方法。

大语言模型改变了我们开发 AI 驱动应用的方式。

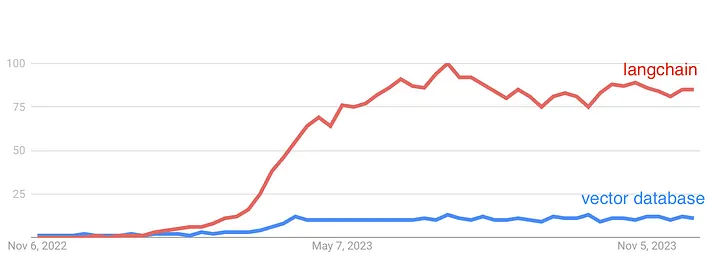

随着这种快速开发 AI 应用的新方法的出现,从 3 月和 4 月开始,围绕这些技术涌现了一系列新的开发者工具,甚至衍生出了一个新术语:LLMOps。

LLMOps 与 MLOps 相似,它协助开发者在大语言模型驱动的应用开发全过程中。但由于大语言模型在构建应用方面与传统 AI 应用有所不同,一系列新的开发工具随之涌现:

- 框架如 LangChain 和 LlamaIndex 受到极大关注。这些框架让开发者能够快速、模块化地利用大语言模型来构建应用。

- 向量数据库 虽已存在一段时间,主要用于语义搜索,但开发者发现它们同样可以强化大语言模型应用,与任何外部数据的融合。

早在今年四月,从业者便开始分享他们在将大语言模型应用投入生产过程中遇到的经验与挑战。在其广受欢迎的博文“构建适用于生产环境的大语言模型应用”中,Chip Huyen 探讨了成本、响应时间、幻觉问题以及向后和向前兼容性等挑战。

“利用大语言模型打造酷炫应用易如反掌,但要让它们真正适用于生产环境则颇具挑战。” — Chip Huyen 在“构建适用于生产环境的大语言模型应用”中提到。

2023 年 7 月,Eugene Yan 在其博客文章中详细介绍了七种构建基于大语言模型 (Large Language Model, LLM) 的系统与产品的策略。对我来说,三个最为显著的策略包括微调、检索增强生成以及评估方法:

微调是一种领先技术,用于教授神经网络新知识。从数据科学家的视角看,首次普及的方法是利用微调使通用大语言模型能够接触到专有或特定领域的数据。特别是在开源的大语言模型,例如 LLaMa-2 [3],以及大语言模型的高效微调技术,如 QLora [1] 推出后,微调大语言模型变得更加普及且易于实践。

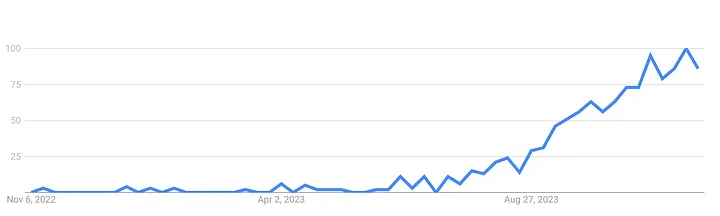

检索增强生成 (Retrieval-Augmented Generation, RAG) 在 2023 年 7 月成为了热点,尽管相关的原始论文早在 2020 年就发布了。

这一技术之所以受欢迎,是因为 RAG 允许开发者将知识从大语言模型的推理能力中分离,并存储在一个相比微调技术更易于更新的外部数据库中。

检索增强生成 (Retrieval-Augmented Generation, RAG): 从理论到 LangChain 实现

秋冬之际,我们注意到业内人士开始探讨 RAG (Retrieval-Augmented Generation) 技术管道的局限,并分享他们的解决方案和评估方法。

回顾 2023 年,一些人对大语言模型 (LLM) 驱动的应用数量之少感到意外,但实际上,我们可能低估了开发这些应用的复杂性。

尽管出现了一些生成式 AI (Generative AI) 应用,比如 亚马逊的产品摘要功能,但许多公司仍在对他们的方案进行试验和评估,以便更有信心地推出这些产品。

因此,2023 年可以被视为是探索和深入了解生成式 AI 的一年。

展望 2024 年

2024 年,我们可以预见的是,生成式 AI 解决方案的成功投入生产将成为一个重要焦点 — 这意味着我们将在各种实际应用中看到更多由大语言模型(LLM)驱动的创新功能。

评估和监控生产环境中的大语言模型驱动应用将成为热议话题,届时我们会见证各种框架、评估标准和方法的不断发展。随着我们逐渐掌握如何准确衡量 RAG、问答系统和聊天机器人的性能,我们也可能会发现新技术来进一步提升这些系统的表现。

随着这些生成式 AI 系统的性能日渐成熟,它们在提高工作效率和优化客户体验方面的应用也将越来越多。

在处理涉及敏感信息(如个人或专有数据)的生成式 AI 解决方案方面,随着我们积累的经验增多,我认为,关于如何减少数据泄露和保护敏感信息的讨论将变得前所未有地重要。

可以肯定的是,2024 年将会是一个充满变动和进步的一年。这个领域发展迅猛,即便是领域内的专家也是最近才开始探索这些新技术。因此,如果你对这个领域感兴趣,现在正是积累经验、为未来做准备的绝佳时机。

“[…我]如果你现在开始加入,你就能从头开始参与其中,成为这一领域的专家。即便是现在的专家也是最近才开始探索这一领域,因此进入的门槛相对较低。通过开始使用大语言模型来构建应用,当这个行业成熟时,你将拥有明显的优势。” — Darek Kleczek 在其文章 “构建大语言模型驱动的应用” 中如是说

这是对 2023 年技术领域的回顾。如果你想了解更多关于 2023 年生成式 AI 领域的经济角度分析,我强烈推荐阅读这篇文章:

本文主要关注生成式 AI (Generative AI) 领域,这只是整个 AI 领域的一小部分。其他领域,如 AI 伦理和 AI 法规,以及绿色 AI(使 AI 模型更小、更高效,从而可持续)也有许多活跃的讨论和令人兴奋的进展。

我很好奇听到你对 2024 年 AI 领域的预测!

参考资料

文献

[1] Dettmers, T., Pagnoni, A., Holtzman, A., & Zettlemoyer, L. (2023). Qlora: Efficient finetuning of quantized llms. arXiv preprint arXiv:2305.14314.

[2] Lewis, P., et al. (2020). Retrieval-augmented generation for knowledge-intensive NLP tasks. Advances in Neural Information Processing Systems, 33, 9459–9474.

[3] Touvron, H., Martin, L., Stone, K., Albert, P., Almahairi, A., Babaei, Y., … & Scialom, T. (2023). Llama 2: Open foundation and fine-tuned chat models. arXiv preprint arXiv:2307.09288.