半人马与赛博格:在未来工作的前沿 [译]

Ethan Mollick

关于 AI 是否将重塑工作的问题,似乎我们找到了答案....

很多人都在好奇,AI 究竟能否真正影响未来的工作模式。最新的一篇研究论文给出了一个强有力的肯定回答。

在过去的几个月中,我和一群社会科学家一起,在波士顿咨询集团进行了一项大型研究,我们把他们的办公室变成了一个用于探索 AI 时代下专业工作未来的先锋实验场。我们的首份论文今天发布了。虽然论文中包含了许多重要且实用的细节,但先让我揭晓最引人注目的发现:在 18 项被选中的、反映精英咨询公司日常工作的任务中,使用了 ChatGPT-4 的顾问在各个方面都明显胜过那些未使用 AI 的顾问。

这是所有任务的成果质量分布图。蓝色代表未使用 AI 的组,绿色和红色代表使用了 AI 的组,其中红色组还接受了如何使用 AI 的额外培训。

使用 AI 的顾问在任务完成率上平均增加了 12.2%,完成任务的速度提高了 25.1%,而且他们的工作成果质量比未使用 AI 的顾问高出40%。这些数据揭示了 AI 带来的巨大影响。现在,让我们深入探讨其中的细节。

首先,需要强调的是,这项工作是跨学科的,包括了多种实验和数百次访谈,由一个杰出团队负责,其中包括哈佛大学的社会科学家 Fabrizio Dell’Acqua、EdwardMcFowland III 和 Karim Lakhani,以及来自沃里克商学院的 Hila Lifshitz-Assaf 和麻省理工学院的 Katherine Kellogg(还有我本人)。Saran Rajendran、Lisa Krayer 和 François Candelon 在波士顿咨询集团(BCG)领导了这项实验,动用了该公司 7% 的咨询人力(共 758 名顾问)。他们的工作非常细致,远不止这篇文章所能涵盖。因此,如果你想了解更多细节,特别是关于数据或方法方面的问题,请查阅完整论文。我在这里只能简要概述 58 页的研究成果,任何误差都是我的责任,而非我的合作者。此外,虽然这些实验已经预先注册,但这仍是一篇新的工作论文,可能存在一些错误或疏漏,目前还未经过同行评审。知晓这些,我们现在可以详细探讨这些内容……

探索不均匀的 AI 边界

AI 的世界充满奇异。就连最先进的大语言模型(如 GPT-4)的全部潜能,也无人能够完全了解。我们还不清楚如何最佳地利用它们,或它们在什么情况下会出错。没有现成的使用指南。在某些任务上,AI 表现出惊人的能力,而在其他任务上,它可能完全失败,或出现微妙的错误。除非你经常运用 AI,否则很难辨别它的长短。

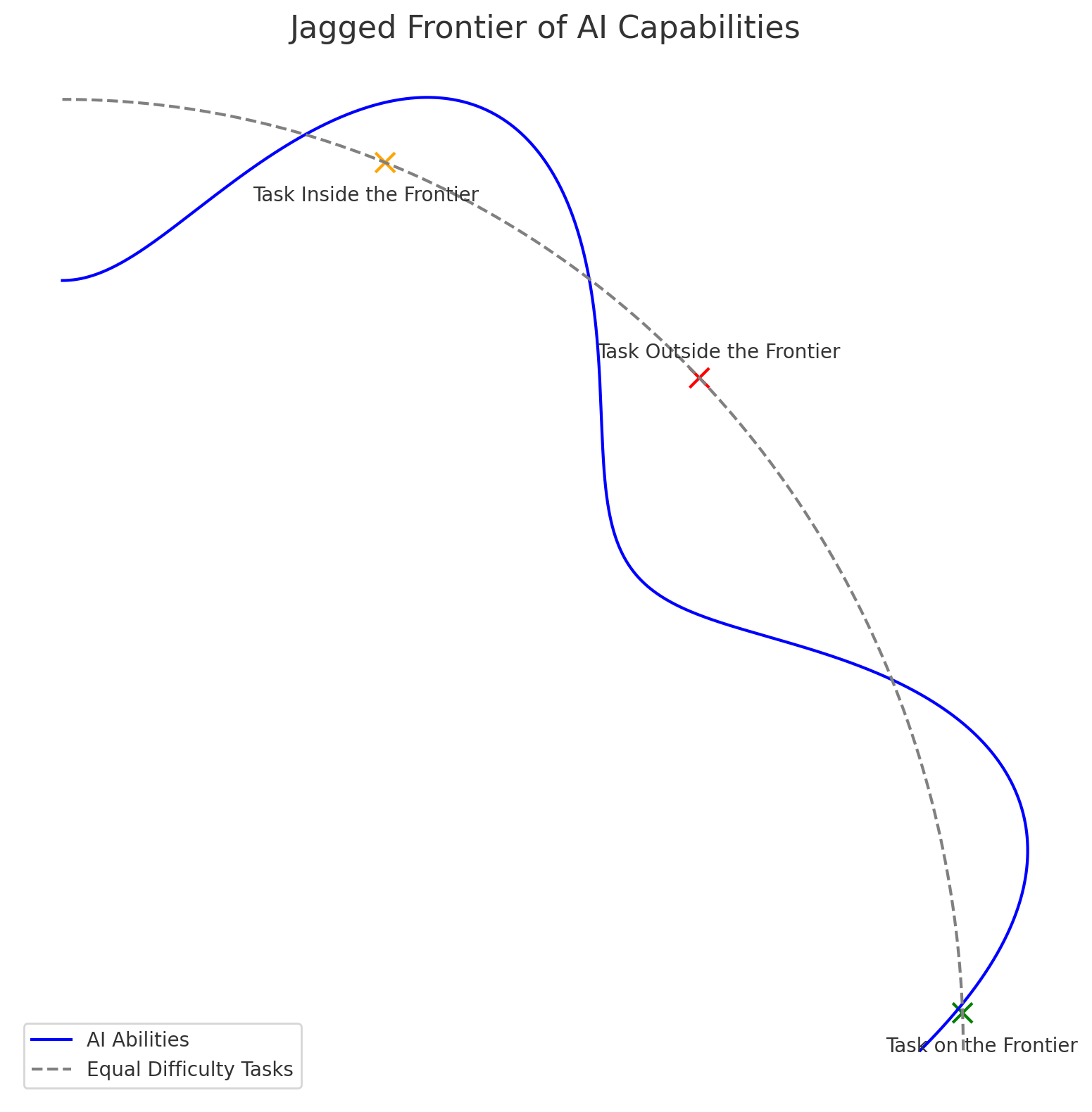

这就是我们所说的 AI 的“锯齿边界”。想象一下一座城堡的防御墙,有些部分高耸,突出于乡村之外,而有些部分则低垂,回缩向城堡中心。这堵墙代表了 AI 的能力范围,距离中心越远,任务难度越大。墙内的任务都能被 AI 完成,而墙外的则难以为继。难题在于这堵墙是无形的,因此一些看似与中心等距离的任务——例如写一首十四行诗与一首恰好 50 个词的诗——实际上难度却大不相同。AI 在写十四行诗方面游刃有余,但因为它是基于 token 而非词汇来理解世界,它在写出刚好 50 个词的诗方面却常常失败。同样,一些看似难以预料的任务(如创意生成)对 AI 来说却轻而易举,而一些看起来应该简单的任务(如基础数学)对于大语言模型却是一大挑战。

我曾请带有代码解释功能的 ChatGPT 帮助我们形象化这个概念:

为了深入探索 AI 对知识型工作的影响,我们选择了数百名咨询师进行实验,随机分配他们是否可以使用 AI。我们允许使用 AI 的人获得了对 GPT-4 的访问权限,这是全球 169 个国家的任何人都可以通过 Bing 免费使用或通过支付每月 20 美元给 OpenAI 使用的同一模型。他们使用的是未经特别微调或定制提示的纯净 GPT-4,仅通过 API 进行访问。

我们首先进行了大量的预测试和调研以建立初始基准,随后请顾问为一个虚构的鞋品公司完成了 BCG 团队精心挑选的各种任务,这些任务准确地反映了顾问的工作内容。这包括创意性任务(“为一个服务不足的市场或运动领域设计至少 10 种新型运动鞋。”),分析性任务(“按用户对鞋类市场进行分类。”),写作与营销任务(“为你的产品撰写一份新闻稿。”),以及说服力任务(“写一份鼓舞员工的备忘录,说明你的产品如何胜过竞争对手。”)。我们甚至还咨询了鞋类公司的高管,以确保这些任务的现实性 - 他们确认了这一点。而且,考虑到 AI 的发展,这些任务可能正是我们预期在技术前沿的工作。

根据我们的理论,正如我们之前讨论的,我们发现有 AI 辅助的顾问表现更佳,无论他们之前是否简要了解过 AI(在图表中为“概览”组)或未曾接触。无论是完成任务的时间、完成的总任务数量(我们设定了总体时间限制),还是工作成果的质量,表现都更好。我们用人工和 AI 评估者对成果质量进行了评估,双方评价一致,这本身就是个有趣的发现。

我们还发现了一个越来越明显的 AI 相关现象:它能够均衡技能水平。在实验开始时表现最差的顾问,在使用 AI 后表现提升了 43%,这是最显著的进步。即使是顶尖顾问也有所提升,尽管幅度较小。从这些结果来看,我认为目前还没有足够多的人意识到,当一项技术能够将所有工人的表现提升到顶尖水平时,这意味着什么。这有点像过去人们关心矿工挖掘岩石的能力好坏……直到蒸汽铲的出现,挖掘能力的差异就不再重要。虽然 AI 还没有达到那种颠覆性的变革水平,但它在技能均衡方面的影响是巨大的。

超越创新的边界

故事背后还有更深层的含义。BCG 设计了一个特别的任务,旨在确保 AI 无法给出正确的答案。这个任务的设计颇具挑战。正如我们在论文中提到的:“鉴于 AI 显示出惊人的能力,设计一个在 AI 能力范围之外、且人类凭借高水平的专业知识能够持续胜过 AI 的任务并不容易。”但我们最终找到了这样一个任务,它利用了 AI 的局限性,确保 AI 对人类能够解决的问题给出错误但看似合理的答案。实际上,没有 AI 协助的人类顾问解决问题的正确率高达 84%,但当他们依赖 AI 时,表现反而下降,正确率仅为 60-70%。这是怎么回事呢?

在我们合作的另一篇论文中,Fabrizio Dell’Acqua 指出过度依赖 AI 可能带来的弊端。他在一项实验中发现,使用高品质 AI 的招聘人员变得懒散、不够细心,并在判断上失去锐度。他们错过了许多优秀的候选人,做出的决策甚至不如那些使用低质量 AI 或不使用 AI 的招聘人员。当 AI 表现出色时,人们往往不再努力思考和关注细节,而是任由 AI 主导,忽略了将其作为辅助工具的初衷。他将这种现象形容为“驾驶时打瞌睡”,这可能会对人类的学习、技能提升和工作效率造成负面影响。

在我们的实验中,我们也观察到了类似的现象。那些使用 AI 的顾问给出的答案准确度实际上低于那些未被允许使用 AI 的顾问(尽管他们在撰写结果方面的表现仍优于未使用 AI 的顾问)。如果对 AI 的边界认识不清,AI 的权威性可能会误导人们。

半人马与半机械人的合作模式

尽管如此,许多顾问成功地处理了 AI 技术的内部和边缘任务,既利用了 AI 的优势,又避免了其不足。他们通常采用两种策略之一:化身为半人马或者成为半机械人。幸运的是,这里说的“化身”并不涉及在身体上植入任何电子设备,或者变成希腊神话中那种半人半马的生物。这其实指的是两种在 AI 锯齿般边界上高效协作的方式,巧妙地结合人类和机器的工作。

在半人马模式下,人和机器之间的分工非常明确,就像神话中的半人马那样,人的躯干和马的身体界限分明。半人马模式下,根据各自的长处和能力来分配责任,灵活地在 AI 和人的任务之间切换。比如,当我借助 AI 进行数据分析时,我会以半人马的方式来操作:我决定使用哪些统计技术,然后让 AI 负责绘制图表。在我们 BCG 的研究中,半人马们会亲自完成自己最擅长的工作,然后把位于 AI 锯齿边界的任务交给 AI 来处理。

而半机械人模式则是将人与机器紧密结合,深度融合两者。在这种模式下,人不仅仅是分配任务,而是与 AI 密切合作,灵活穿梭于 AI 的锯齿边界。他们会将任务的一部分交给 AI 来处理,例如,他们可能会启动一个句子,然后让 AI 来完成,从而实现与 AI 的并行工作。这就是我推荐用 AI 进行写作的方法,例如。这也是我在论文中制作两幅插图的方式(包括“锯齿边界”图像和“54 线图表”),这两幅图都是我在 ChatGPT 的初步指导和引导下完成的。

在充满挑战的前沿起舞

我们的论文,加上其他学者的一系列杰出研究,均指出,无论人们如何围绕 AI 的本质和未来展开哲学和技术辩论,AI 已成为我们实际工作方式的一大变革力量。这不是一项需要五年才能改变世界的被过度宣传的新技术,也不需巨额投资和大公司的资源支持 - 它已经出现在我们眼前。那些顶尖顾问所使用的工具,其实和我们每个人现在能用的工具没有两样。而且,顾问们目前使用的工具很快就会变得比大家现有的还要落后,因为技术前沿不仅多变,还在不断扩展。我非常自信,在未来一年内,至少会有两家公司推出比 GPT-4 更为强大的模型。这个充满挑战的前沿正在快速发展,我们必须做好准备迎接。

除了这种说法可能引起的不安之外,AI 的其他不足之处也值得注意。人们使用 AI 时容易进入“自动驾驶”模式,对 AI 的错误视而不见。另外,正如其他研究所发现的,AI 的输出虽然在质量上超过人类,但在总体上看却显得过于雷同和单一。这就是“赛博格”和“人马合体”变得重要的原因 - 它们让人类能够与 AI 合作,创造出比单独由人类或 AI 完成的工作更多样、更准确、更出色的成果。而成为这样的存在并不困难,只需在工作中频繁使用 AI,你就会逐渐领略到这个复杂前沿的轮廓,明白 AI 在哪些方面表现出色,以及在哪些方面还有所不足。

在我看来,关键的问题已经不再是 AI 是否会重塑我们的工作方式,而是我们希望通过 AI 重塑工作带来什么样的意义。我们可以选择如何利用 AI 来使工作更高效、更有趣、更有意义。但我们必须尽快做出这些选择,以便我们能开始以道德和有价值的方式积极利用 AI,像“赛博格”和“人马合体”那样,而不只是被动地应对技术变革。与此同时,那个充满挑战的前沿仍在不断前进。