大语言模型与大脑的相似之处与不同之处 [译]

在许多关于大语言模型是否构成“人工智能”或“通用人工智能”(AGI)的讨论背后,潜藏着一些关于这些系统与人类大脑相似或不相似程度的假设。支持者倾向于认为,从计算规模和复杂性上来看,这些模型与大脑作为信息处理系统的关键特性相匹配。而怀疑者则常将大语言模型(LLM)视为“高级自动纠错工具”,并否认这些系统在类似大脑方面(或能展现出“智能”,不论定义如何)有任何实质意义。实际的答案可能介于两者之间。

如果我们观察当前的神经科学理解,将大语言模型的功能与我们大脑的某些部分相比较是有道理的。确实存在一些相似之处。但这些模型的不同之处恰恰揭示了它们所缺乏的要素。大脑中人类认知的缺失部分,很大程度上解释了这些模型行为中的许多令人困惑之处。从我们目前所处的位置到开发出真正能够像人类一样产生语言的大语言模型,是一条长且充满未知和挑战的道路。通过观察大脑的运作方式,以及大语言模型所缺乏的大脑系统部分,这一点变得非常明显。

大脑中与大语言模型最为相似的部分是被称为“联合皮层”(association cortices)的区域。这些是大型皮层区域,拥有数十亿神经元,能够编码关于世界上事物间关系的海量信息。在人类大脑中最为显著的——远超其他任何动物——是位于前额叶皮层和顶叶皮层。从神经结构的视角来看,它们是人类与其他动物大脑差异的核心。它们对于我们所认为的人类特有的认知任务至关重要,比如复杂的心理理论推理、反思性自我意识和结构丰富的语言。

我们能够了解这些大脑区域对于人类特有认知任务的重要性,是因为在人类和猿类分道扬镳之后的演化过程中,这些区域显著增大。它们属于大脑中相对较晚出现的部分。与此相比,我们大脑的其他部位,比如海马体或杏仁核,变化不大,在人类和其他动物中的差异也较小。这些区域在人类祖先中快速形成,限定了它们可能的演化路径。我在读博期间,曾从神经科学家 Randy Buckner 那里了解到这些知识。在演化过程中迅速发生的变化往往是那些在遗传上容易实现的变化。例如,演化出一种全新类型的大脑区域,比如一个新的功能区,这在演化上代价极高。但增加大量神经元在演化上相对来说“便宜”得多:控制大脑发育的遗传代码本质上是在指导一种重复加倍的过程,要让特定大脑区域的神经元数量翻倍,只需略微改变这些代码,使得加倍过程比原计划多进行一次。这样的基因变异相对简单,更有可能在相对较短的时间内随机发生。人类的前额叶皮层经过数千年的不断加倍,最终使得这两个区域在人类中比任何其他猿类都要大得多。

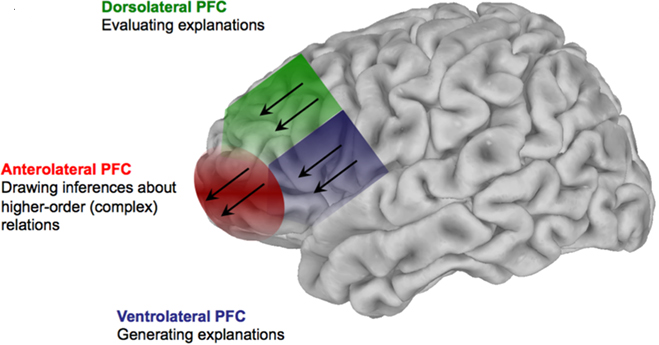

我们知道,由于这些大脑区域的发育较晚且仅见于人类,它们对于人类大脑独有的功能必定至关重要。同时,这些区域由于发育时间较短,不可能高度专业化,它们更可能是原有区域的扩大版本。那么这些区域具体负责什么呢?简而言之,它们负责编码关系。大致上,前额叶皮层用于编码事物定义(即事物的本质和原因)之间的关系,而顶叶皮层则用于编码事物的位置和数量(即事物的位置和数量)之间的关系。这些区域在我们思考和处理事物间关系时起到动态辅助作用。

详细来说,背外侧前额叶皮层是前额叶的一个子区域。fMRI 研究显示,它在多种任务中都会被激活,包括心智理论推理、执行功能、语言监控等。在此,我将重点介绍语言监控——即大脑跟踪我们所说话内容的过程。这是一种确保我们语言连贯性的监督功能。

联合皮层的特长在于追踪词语间的连接和共现。在语言表达中,你需要确保词语逻辑地连续。每个词不仅要与前文相符,还要确保整体语言表达的连贯性。从开始到结束,你的话语应该在某种程度上相互吻合。联合皮层通过编码大量信息来实现这一点,这些信息涵盖了哪些词语——包括概念、想法、图像、印象——通常会组合在一起,以及它们如何构成从一种可能的语言开端到另一种可能的结束的有效路径。

首先,这正是大多数大语言模型 (LLM) 主要做的事情。LLM 中的 “Transformer”网络 本质上就像一个巨大的、在海量数据上训练的大脑关联区。它高度精准地编码了人类语言(或艺术)领域中,哪些词语(或图像的部分)通常会组合在一起,以及哪些词语的组合能够构成一条从思想起始到终结的有效路径,还有这些路径是如何分叉和转变的。虽然这些网络的学习机制与人类大脑关联区编码世界信息的方式并不完全相同,但总体功能足够类似,使得进行这样的比较是有意义的。

语言产生的第二个方面是确保你所表达的连贯整体能够达成其预定目的。说话是一种社交行为,我们说话时总是希望以某种方式影响听者。我们的目标是改变他们与世界互动的方式。

现代大语言模型相较于以往的文本自动完成系统的一大进步,在于它们能够很好地模仿这种语言(或图像)产生的第二要素。与早期的自动完成系统不同,大语言模型能头维持思路连贯,产生的文本不仅在词语或句子层面上合理,而且还围绕一个特定的沟通目标构建。

在大语言模型中,实现目标的监控来自一个执行“强化学习 (reinforcement learning)”的算法模块。这个模块的作用是预测每个额外的词语如何促进最终目标的实现。每次系统选择下一个“Token”(基本上是一个词语)加入到其输出时,大语言模型都在众多可能的选项中做出选择。这些选项根据大语言模型的训练进行了可能性加权。强化学习模块的职能是调整这些权重,使得下一个 Token 的选择既基于其在训练集中出现的概率,又基于它对实现语言产生行为整体目标的贡献。

大脑中的某些过程与此类似。在计算神经科学的历史上,一些极具影响力的研究显示,诸如纹状体和黑质等区域编码了一套奖励预测系统,用以指导认知。当大脑的联合皮层被激活时,它们的活动会受到这些进化上更为古老的大脑区域设定的目标的影响和调节。

大语言模型 (LLMs) 与大脑的主要不同之处在于它们对加强学习所指向的目标的复杂性和基础上。LLMs 设定的目标远不如人脑中的内在目标状态复杂。

这种差异部分原因是技术层面的:强化学习 (reinforcement learning) 算法需要大量数据来进行训练。随着它们追求的目标(也就是“状态向量” (state vector))变得更加复杂,所需的数据量就急剧增加。如果你能将强化学习的状态向量限制在较少的几个维度,甚至更好地是一个维度——好与坏、赢与输、可接受或不可接受、有价值或无价值——那么成功训练出一个模型就会变得更容易。

这一技术限制与另一个挑战相互关联:相较于训练大语言模型 (LLM) 中用于预测下一个有希望的 Token 的部分,训练其强化学习组件所需的数据类型更为复杂和难以收集。这些复杂的训练过程依赖于大量已存在的数据集。而对于强化学习模块,它的训练数据中的状态向量需要被精确测量或专门创建。Google 旗下的 DeepMind 在深度强化学习的基础研究中,主要探索了游戏领域——如围棋、视频游戏——因为这些可以在训练系统内部模拟出来,每一次模拟都能产生含有两种关联(即一步接一步)和适用于强化学习系统训练的状态向量(如玩家一胜或负)的训练样本。然而,当强化学习系统要处理的问题领域变得像人类交流这样无规则且开放时,给训练样本标注状态向量的任务变得极其困难,这需要从与系统互动的用户那里收集数据。OpenAI 进行的各种公开测试的主要目的,很可能是为了积累用户反馈,判断某个输出是好还是坏,这样的信息将作为他们强化学习系统训练的状态向量。

相较之下,在大脑中,联合皮层的目标是引导我们的言语,使之指向从整个大脑和神经系统这个极为复杂的神经网络中提取的目标。当背外侧前额叶皮层 (DLPFC) 监控并限制我们的言语,确保其合乎逻辑且相关联时,言语背后的人际和社会目标源自一种大脑化学物质的复杂混合——包括血清素、去甲肾上腺素、多巴胺这样的调节性神经递质和无意识的神经活动。这些因素共同构成了你对那个人的感觉、你对互动的态度、你的整体心态、你的行为目标、以及你对对方行为目标的直觉等。粗略来看,这个目标——用强化学习的术语来说,就是状态向量——是从你与世界(手指、脚趾、眼睛、耳朵)和你自身身体(你的肠神经系统,它反馈你的消化系统状态,本身含有数亿神经元)的连接中传来的全部信息路径的输出。这只是感知和行动这个宏大循环的一半。

至于机器学习是否能进化成“AI”——无论你怎样定义它——并不完全取决于这些系统是否精确地模拟了人类神经系统的全部功能,即接收关于世界和我们身体的反馈,并将其凝聚成情感和欲望的状态向量。然而,与大语言模型 (LLM) 互动时,人们感受到的那种基本的空虚感,那种平庸而又过于迎合的态度,以及缺乏内在生活的印象,正是由于状态向量的简化而产生的。如果以神经科学为参考,从当前状态发展到一个反映丰富内在生活和有组织、有目的推理的智能系统,将会是一条至少与我们迄今为止攀登的陡峭之路一样艰难,甚至可能更加险峻的道路。

输入你的邮箱

新年伊始,我们迎来了新的平台,也期待着这份时事通讯能有新的提升。

在 buttondown 平台上的 Apperceptive 对你们这些读者而言,和之前在 Substack 上的体验应该没有太大区别。不过,我还是想承认这一变化,并讨论关于时事通讯的一些小调整。

我会继续聚焦于同样的话题 — 自动驾驶汽车、大语言模型(LLMs)及其与大脑的关系和实现难点、初创企业、交通系统以及社会的变迁 — 尽管如此,我打算尝试坚持更加规律的每周更新计划。因此,从这个角度看,我希望这份通讯的质量能有所提升。

同时,我不久后也会推出一个付费服务。与 Substack 不同,buttondown 对我而言并非免费。准确来说,使用 buttondown 我是用金钱支付,而不是其他更加抽象和不愉快的方式。我还在思考如何让这个付费服务变得更有价值。可能的方式是通过偶尔发布一些内幕深度或者关于 AI/自动驾驶行业内部的八卦文章,这些内容不适合公开发布,以及承诺提供我目前正在进行的大型项目最终可能出版的任何书籍的免费副本,但我还没有最终决定。这份通讯本身,我希望能够,而且实际上也会,对于免费订阅者继续提供,甚至提高质量。但如果人们愿意通过经济方式表达支持,我不会拒绝,并且我会努力提供更多额外价值。