利用语言模型模拟观众,让人际沟通更上一层楼 [译]

Ryan Liu1,Howard Yen1,Raja Marjieh2,Thomas L. Griffiths1,2,Ranjay Krishna3 1 普林斯顿大学计算机科学系 2 普林斯顿大学心理学系 3 华盛顿大学计算机科学系

摘要

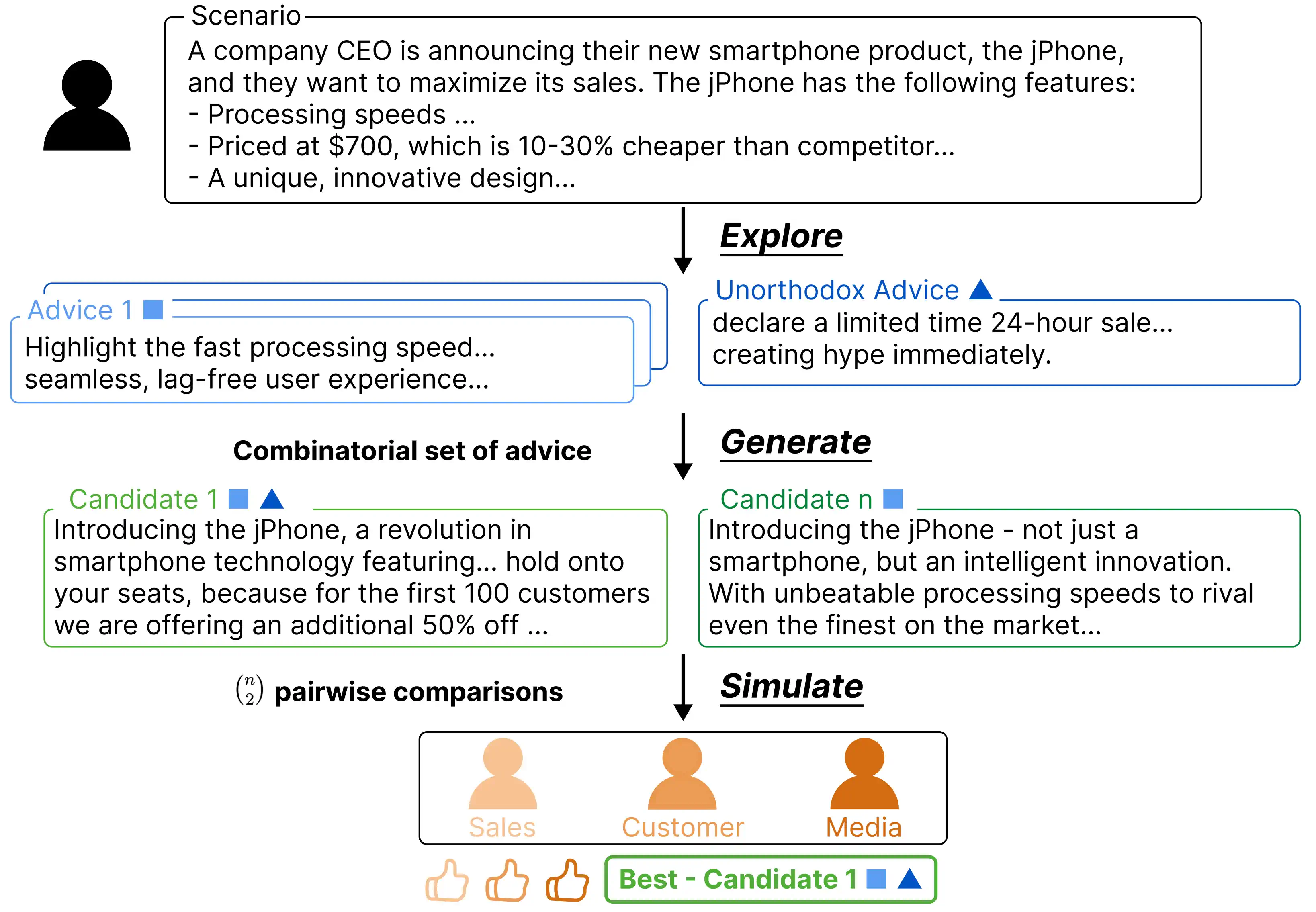

如何与他人有效沟通,达到我们想要的目标呢?我们通常会借鉴过往的经验,听取他人的建议,或者尝试预测对方可能的反应来构思我们的话语。但问题是,我们自己的经验并不全面,有时甚至带有偏见,而去思考所有可能的沟通结果不仅复杂而且费脑。在本文中,我们探讨了如何运用大语言模型(LLM)进行模拟,来提升我们的沟通技巧。我们提出了一种名为探索 - 生成 - 模拟(EGS)的框架,它适用于任何需要个体与观众沟通并实现特定目标的场景。这个框架的工作流程如下:(1)对可能的解决方案进行全面探索,并提供一系列切实可行的建议;(2)基于这些建议,生成多个可能的沟通方案;(3)模拟不同观众对这些方案的反应,从而挑选出最佳的沟通方案和建议。我们在八个不同的人际沟通场景中对这个框架进行了测试,这些场景涵盖了人际沟通的十个基本过程。通过与现有流行生成方法(如连锁思考)的对比,我们发现人们更倾向于选择我们框架生成的沟通方案。此外,在这八个场景中,有五个场景中我们的模拟结果与人类评价高度一致。最后,我们还将这个框架应用到了网上论坛中用户描述的真实世界场景,验证了它的广泛适用性。通过这些评估和实例演示,我们展示了 EGS 框架如何在各种情境中提升沟通的效果和成果,为利用大语言模型改进沟通和决策过程开辟了新的可能。

1. 开篇

我们与人交流,目的是为了达成我们的各种目标,比如结交朋友、完成任务、或者简单地表达自己的意图(Grice, 1975; Sperber and Wilson, 1986)。但有时候,找到合适的话语来达到目标并非易事。比如,在你试图通过讨价还价来争取商品折扣的情境中,你可以尝试各种策略,比如夸赞商品、提议购买多样商品以求折扣,或者说说自己的财务困境,希望卖家能够通融。面对这么多可能的选择,要决定采取哪种策略确实挺让人头大的。而且,这种选择的困难并不仅限于讨价还价的情况,日常生活中的种种沟通都需要我们做出类似的决策,无论是在交友、给人留下好印象,还是处理爱情纠葛时。

那么,在一个特定的沟通场景中,我们应该如何决定采用哪些策略呢?我们通常会依赖一些经验法则,比如基于自己过往的经验(Schacter et al., 2007)或者听取别人的建议(Yaniv, 2004)。当我们有充足的时间来仔细思考时,我们甚至会在心里反复推演不同的可能性,模拟一个假想听众的反应,然后根据这个假想的反应来指导我们的选择(Atance and O’Neill, 2001)。这种思考方式在“理性语言行为模型”(Rational Speech Act, RSA) 中得到了详细的阐述和应用(Goodman and Frank, 2016),该模型试图通过模拟发言者如何将听众视为对可能的言辞做出理性解读的过程来解释人们在沟通中的选择。然而,无论是基于经验还是他人建议的方法都可能因为我们接触到的信息有限而带有偏见,从而使得我们的判断和模拟并不完美,导致沟通效果不佳(Gilbert and Wilson, 2007)。此外,考虑他人可能的反应往往是一个既耗时又需要高度认知努力的过程(Gilbert et al., 1988)。

图 1:我们的框架通过模拟建议和利益相关者的反应,能够根据给定场景和目标生成最合适的信息。首先,它寻找可能有益的建议;然后,根据这些建议生成多个候选信息;最后,通过模拟不同观众的反应来评估这些候选信息。

情境

公司首席执行官正在宣布他们的新智能手机产品,jPhone,并且他们想要最大化其销售。jPhone 具有以下特点:

- 处理速度...

- 价格为$700,比竞争对手便宜 10-30%。

- 独特的、创新的设计...

探索

非正统建议:

限时 24 小时的销售...立即制造炒作。建议 1

强调快速的处理速度...无缝的、无延迟的用户体验...组合建议集

候选者 1

介绍 jPhone,这是一次在智能手机技术上的革命...请紧握您的座位,因为前 100 名客户我们将额外提供 50% 的折扣...生成

候选者 n

介绍 jPhone - 不仅仅是一部智能手机,而是一个智能创新。具有无与伦比的处理速度,可以与市场上最好的竞争...(n^2) 两两比较

模拟

销售 客户 媒体最佳 - 候选者 1

受到大语言模型(LLM)在模拟代理方面的巨大进展的启发(见 Park 等人 2023 年的研究),我们提出了一个名为 Explore-Generate-Simulate (EGS) 的框架。这个框架能帮助人们探索沟通策略,制定可能的信息,并在此过程中将模拟观众反应的复杂任务交由机器完成。更具体地说,面对任何沟通场景,EGS 首先利用 LLM 提出一系列相关的建议,包括常规和创新的;接下来,根据这些建议生成不同的沟通方案;最后,模拟不同观众的反应,从而找出最符合沟通目标的方案和建议。通过这样的流程,我们还可以检验 LLM 在不同情境和观众描述下模拟反应的效果。

我们为此框架设计了八个不同的场景,涵盖了人际沟通的十个基本流程,并包括了多种沟通方式、人际关系和环境设置(详见附录 A.1 和 A.2)。场景举例包括航空公司代表在飞机事故后的媒体应对、大学生在约会应用上写个人简介,以及咖啡师与顾客的日常互动等。我们通过收集人类对各种信息效果的评价,并将 EGS 的表现与其他非模拟方法进行比较,包括 GPT-4 的 zero-shot 方法和链式思考(Chain-of-Thought,简称 CoT)。我们还利用 Stanford Human Preferences 数据集中的真实场景,分析了人类与模拟观众评价之间的一致性。

在这两种评估方法中,EGS 都显著优于其他基线方法。我们还发现,在多个不同的分析中,EGS 模拟的观众反应与人类评价高度一致。通过进一步的实验,我们证明了模拟观众评价能够选出人类更为认可的信息,而且创新性的建议确实能提高信息的质量。我们还通过可视化的方式,展示了在整个过程中 LLM 是如何生成信息的,以及我们在设计上做出了哪些选择。总的来说,我们将 LLM 看作是一个包含了共享经验和观点的巨大库,利用这个库,我们的模拟方法能够融合文化和个人经验,最终帮助人们实现更有效的沟通。

2 相关研究背景

在这项研究中,我们借鉴了社会心理学关于人际关系的理论,并通过 LLM 代理模拟来模拟人类大脑的思考过程,同时我们也参考了人们的喜好来对这个模拟框架进行评估。

关于人际关系方面,社会心理学认为,无论在什么社交环境下,人际交流都是建立在十个基本过程之上的(可以参考附录 A.1 获取详细的总结)。Berger 和 Roloff 在 2019 年的一篇文章中对这些过程进行了深入的研究。Grice 则从日常交流中探讨了合作型说话者应该遵循的一些原则,例如真实性和相关性(Grice,分别在 1957,1975 和 1989 年的作品中进行了讨论)。在交流模型方面,传统观点认为合作交流是说话者和听者之间传递信息的过程,目的是让双方对事物的认识达到一致(相关理论分别由 de Saussure 在 1916 年,Lewis 在 1969 年,以及 Shannon 在 1948 年提出)。而 Rational Speech Act(RSA)框架则结合了以上观点,试图通过建模信息丰富的说话者如何减少听者对真实世界状态的不确定性,从而推断出听者是如何根据听到的话语做出合理推断的(Frank 和 Goodman 在 2012 年及 Goodman 和 Frank 在 2016 年的工作中进行了详细论述)。

在人类的思考过程中,有一种将自己置身于未来,提前体验某个事件的做法,我们在认知科学领域把这种行为称之为“情节性未来思维”(Atance 和 O’Neill, 2001)。从神经心理学的角度来看,我们发现当人们尝试想象未来可能发生的事情时,那些通常与记忆存储有关的大脑区域也会相应地被激活(Schacter et al., 2007)。Szpunar 在 2010 年的研究中提到了一系列证据,显示我们想象未来的能力与回忆个人过去经历的能力紧密相关(2010)。认知心理学家 Klein 等人也在他们 2010 年的研究中找到了证据,表明我们的长期记忆实际上是为了保存过去的信息,帮助我们为未来做计划(2010)。因此,如果我们把大语言模型(LLMs)看作是对人类社会大片群体个人经历的一种编码和聚合,那么它们就有可能具备模拟情节性未来思维的能力。而且,大语言模型在理论上能够根据一些经历来推断和描绘出经历这些事情的人的特点(Andreas, 2022),这就意味着它们有可能从一个具有特定属性的“平均人”的角度出发,模拟情节性未来思维,这也就开启了创建逼真的、由大语言模型模拟的受众群体的可能性。

代理模拟研究:如今,大语言模型(LLMs)在模拟社会互动方面展现出了巨大的潜力,被认为是计算社会科学领域的一大研究机会(Ziems 等人,2023)。传统上,研究人员常常运用基于规则的模拟方法来解读社会现象,但这种方法在表达复杂社会行为方面存在一定局限性(Schelling, 1971; Easley 和 Kleinberg, 2010)。与之相比,LLMs 能够更加灵活地模拟复杂的社交互动,并能够根据特定条件模拟不同个体的目标和行为(Jones 和 Steinhardt, 2022; Koralus 和 Wang-Maścianica, 2023; Liu 和 Shah, 2023)。近期研究更是运用 LLMs 成功模拟了社会计算系统,揭示了社群成员之间的互动方式,生成了公众舆论,并描述了个体化的主观体验(Park 等人,2022; Park 等人,2023; Chu 等人,2023; Argyle 等人,2023)。尽管如此,利用 LLMs 进行模拟研究仍然存在不确定性,特别是模型结果的不可预测性问题(Salganik 等人,2006)。需要注意的是,目前的 LLMs 在意见形成上往往比人类更加趋同,因此,将其与真实人类样本结合使用显得尤为重要,以避免形成局限视角的“单一文化”现象(Kleinberg 和 Raghavan, 2021; Bommasani 等人,2021)。

人类的喜好可谓千变万化。近来,大语言模型(LLMs)正通过使用带有人类反馈的强化学习(RLHF)来进行训练,目的是让机器更好地遵循人类的指令(参见 Ouyang et al., 2022 年的研究)。为了构建 RLHF 中的奖励模型,研究人员从一个专业的人类评注团队那里收集了丰富的人类喜好数据(具体研究可参见 Ouyang et al., 2022; Touvron and others, 2023; Bai and others, 2022)。过去,人们利用这些数据来训练奖励模型,从而使大语言模型能够进行强化学习。而在我们的研究中,我们使用这些数据来检验我们模型适应真实互联网用户遭遇各种情境的能力,以期达到更优的使用效果(详见 Ethayarajh et al., 2022 年的论文)。

3 探索 - 生成 - 模拟(EGS)框架

EGS 框架的设计初衷是处理这样一种情况:某个人想要在和观众交流的过程中,通过传达某个信息来实现特定的目标。EGS 框架的输出则包括一些建议和候选的信息,旨在帮助此人达成目标。

举个例子来说:

假设一家公司的 CEO 正在发布一款新的智能手机产品,名为 jPhone,他们的目标是尽可能地提升这款手机的销售额。现在,jPhone 即将在各大电视频道上进行一次为期 30 秒的快速宣传。

在这个例子中,CEO 希望通过宣传 jPhone 来提升其销量。面对这样的任务,EGS 框架会进行以下三个步骤的操作:

首先是“探索”环节,EGS 会请求一个 LLM(大语言模型)为这个特定情境生成一系列多样化的建议,比如建议突出 jPhone 流畅无延迟的使用体验和快速的处理速度。

接下来是“生成”环节,针对每一条建议,EGS 会再次请求 LLM 生成具体的宣传文案,比如可能会生成这样一段文案:“让我们一起来认识 jPhone,这款拥有市场上无与伦比处理速度的智能手机……”

最后是“模拟”环节,EGS 会要求 LLM 为这个情境模拟出几种不同的观众角色和他们的观点,比如媒体机构可能是其中一个角色,它们的任务是理解 CEO 关于 jPhone 的介绍,进而通过自家平台将这些信息传递给公众。

在这个阶段,EGS 会结合模拟出的观众视角,评估前面生成的每一条信息,看它们在多大程度上能够帮助达成目标。这个评估会涵盖所有模拟的观众角色,以确定最终的最佳方案。

那为什么不直接用现有的 LLM 提示方式呢?因为在处理此类问题时,现有的方法(如思维链技术)往往无法生成内容丰富、形式多样的信息,并且沟通者可能缺乏从多个角度评估信息的能力。此外,随着可供选择的方案越来越多,沟通者可能会感到选择困难。为了解决这些问题,我们设计了 EGS 框架,并确保它的每个环节都可以根据具体情况灵活应用。下面,我们将对 EGS 框架的每个环节进行简要总结。

3.1 探索环节

探索环节的核心任务,就是拓宽我们生成备选项的视野。在这个阶段,我们会列出一系列特定的建议,为下一步的备选生成提供依据。借鉴了社会心理学的研究成果,我们发现人们在做决策时,往往会回想起以往有益的建议(参考 Yaniv 的研究,2004)或者自己的经历(参考 Schacter 等人的研究,2007)。同理,我们的探索环节也旨在生成那些对下一个环节非常有帮助的相关建议。

此外,EGS 机制还鼓励 LLM 创造一些“非常规但可能对代理人完成任务和目标有帮助”的建议,目的是为了让备选方案更加多样化。比如在前文的示例中,GPT-4 就提出了一个非常规但很有创意的建议:

在你的 30 秒演讲中,可以宣布一个限时 24 小时的特惠活动,前 100 名购买手机的顾客可以额外享受 50% 的折扣,这样可以营造一种紧迫感,促使顾客立刻下单。

从质量上来看,这些建议不仅聪明,而且富有创意(详见第 4 节)。从数量上来看,这种方法在 8 个不同的场景中有 4 个场景显示出了积极的效果,提升了备选消息的质量(详见第 5 节)。我们认为,这种效果的背后,是因为 LLM 接触到了丰富的人类文本经验,让它能够发现那些只有在小型社群或者个别人中才会使用的成功策略。

3.2 生成环节

在"生成"这一环节,我们的目标是在"探索"环节给出的建议指导下,创造出合适的沟通候选方案。EGS 会组合之前步骤中得到的各种建议,形成多个子集,并利用这些子集为每个候选消息设定条件。为了考虑到 LLM 采样温度带来的随机性,我们针对每组建议都生成了三个候选方案。

根据 Park 等人在 2023 年的研究,我们使用沟通者的“内心独白”来引导生成的消息候选,使其符合相关建议,这样做更容易让 LLM 将这些叙述视作直接指令。具体来说,我们将建议集呈现为个体此刻记住的事情:

你回忆起了一些建议: 你决定在演讲中依据这些建议来进行。

将建议的组合方式多样化,进一步拓宽了我们探索解决方案的空间。特别是,这使得一个消息候选能够融入许多不同方向的建议,从而可能取得更好的效果。在我们的对比实验中发现,虽然多个建议并不总能提升所有候选方案的平均质量,但它们确实能够提升顶尖候选方案的表现,在 8 个场景中有 5 个场景的最高得分候选都是由此产生的(详见附录 A.6)。

EGS 的可扩展性是其能够应用组合建议的关键。通过使用 LLMs,我们可以在前所未有的规模上生成和比较候选方案,使我们能够进行更为复杂和深入的沟通选择探索。此外,我们还通过实际示例(见第 4 节)和量化分析(见第 5 节)来展示这些生成候选方案的高质量。

3.3 模拟步骤

模拟步骤分为两个阶段。首先,EGS 请求 LLM 生成一份关键受众名单,这些受众对个人是否能够达成目标有着重大影响,并为他们每个人编制一份详细的档案描述。接着,我们让 LLM 去模拟这些受众对每一条候选信息的反应,并将这些反应汇总起来,以判断哪一条信息最有可能帮助信息传递者实现他们的目标。

对于每一份受众档案,我们都会请 LLM 描述两个方面:1)从受众的角度出发,他们是如何理解和接受这条候选信息的;2)我们应该如何提问,以了解他们对这条信息的接受程度将如何直接影响到信息传递者想要达成的目标。以我们为例中的受众群体——媒体机构所生成的问题来说,这个问题就是:

在哪种情况下,你更有可能对 jPhone 进行更多的媒体报道和推广?

我们允许 LLM 根据具体情境,生成最多 个受众进行分析,其中 是由用户设定的一个参数。在生成受众名单的同时,我们还会请 LLM 为每个受众分配一个权重,以反映他们在特定情境下的重要性。然后,我们将根据这些权重,对受众的评价进行汇总,以求得最佳的候选信息和相应的建议。更多关于如何生成受众的详细信息,可以参见附录 A.3。此外,受到关于认知选择的研究(Gates 等人,2020)的启发,我们还在附录 A.10 中提供了一系列其他可能的受众汇总方法和对这些方法的简要分析。

由于我们比较的沟通方案往往质量相当接近,LLM 在对每个方案进行评分时往往无法提供足够的细节(参见 Qin 等人于 2023 年的研究)。因此,我们转而让 LLM 通过成对比较的方式来评价这些方案。具体来说,我们会向 LLM 提供两个不同的场景,分别代表两个待比较的方案,并让它来判断哪一个更好。有时候,LLM 会认为最终的选择取决于受众的个人喜好,这种情况下我们会把结果定为“打平”。如果 LLM 给出的回答格式不正确,我们还会请另一个 LLM 来对这个回答进行分类,以确定它到底属于“prefer scenario 1”,“prefer scenario 2”,还是“tie”中的哪一种。

在得到了每个受众对于每一对候选方案的比较结果后,我们会将这些结果汇总,从而确定最终的最佳方案 。

直观地来看,这个方法通过比较每个候选者与其他所有候选者的表现,从而选出在竞争中表现最出色的那个候选者。

4 示范

| 情境:约会中的善意的谎言 |

|---|

| 一个十几岁的男孩正在商场和一个女孩约会,他被这个女孩深深吸引,想尽一切可能让这次约会变得愉快。他们此刻正在一家服装店,女孩正在更衣室试衣服,而他在外面等待。当女孩满意地穿着一件黑色牛仔夹克走出更衣室,摆出一个 POSE,并询问:“你觉得怎么样!”时,他内心并不认为这件夹克适合她,但他还是决定要给予赞美。此刻,他在思考该如何表达。 |

| 探索 |

|---|

| 常规建议 1: 可以表达对她的关注,并夸赞她,比如:“这种风格真是难以驾驭,但你穿起来却异常迷人。” |

| 常规建议 2: 可以对夹克给予肯定的评价,例如:“哇!这真是大胆的尝试,看你尝试新风格真的很有趣。” |

| 常规建议 3: 可以夸赞与夹克相关的其他元素,比如说:“这件夹克真的让你的眼睛更加炯炯有神,”这样既没有直接评论夹克的样式,又给予了积极的评价。 |

| 非正统建议: 可以夸赞夹克给她带来的快乐,而不是夹克本身。 |

| 生成 |

|---|

| 常规建议 3 + 非正统建议 哇,这件夹克真是让你的眼睛闪闪发光,看得出来你穿上它很开心。这真是为你的整体造型添了不少分。 |

| 常规建议 1 + 常规建议 2 哇!你尝试这种大胆风格真是太棒了,展现出你的勇敢一面。其实这种风格挺难驾驭的,但看起来你什么都能穿得美美的。看你尝试新风格,我真是乐在其中。 |

| 模拟 |

|---|

| 我对哪种赞美和反馈的喜好很大程度上取决于我的性格和我在约会中期待对方给予何种回应。在第一个情景中,他直接赞美了夹克对我的外表,特别是我的眼睛以及它带来的幸福感的影响。他注意到了我的快乐,并体现了我的独特风格,这点我非常欣赏。这显示了他不仅在视觉上,还在情感上都在关注我。在第二个情景中,他描述了夹克如何增添了我的整体风格,并暗示我是一个勇敢和前卫的人。他赞赏我驾驭复杂风格的能力,表明他觉得我有很好的时尚感。但是,“你看起来什么都好看”的说法可能显得有些千篇一律。不过,他表现出对我尝试新风格的兴趣,意味着他也愿意一起享受购物的乐趣。总的来说,虽然两种情景都给予了积极的反馈,但我更倾向于第一个情景。 这段描述非常打动人心。他不仅仅是注意到了表面的东西,还关注到了这件事给我带来的快乐,这深刻地表明了他对我的感受的关心。 |

| 答案:场景 1 |

表 1:完整展示了“约会中说善意的谎言”的场景。在“模拟”环节,我们从约会对象的角度比较两个候选方案。在这个比较中,“生成”环节中的左侧是场景 1,右侧是场景 2。

在 表 1 中,我们完整地展示了在一个约会场景中 EGS 框架的运作,其中使用了 GPT-4 作为语言模型。这个场景描述了一个青少年在商场约会时遇到的两难困境。

探索

在“探索”阶段,我们根据场景提出了三条常规建议和一条非常规建议。通过演示,我们发现每条建议都考虑到了这位年轻人真实的感受,并试图弥合他的感受和约会对象期望之间的差距。一般来说,我们发现 GPT-4 倾向于避免使用或建议使用谎言,这是我们认为在改善人际沟通时非常重要的价值观。

非常规建议提出了一种独特的策略,建议这位年轻人关注夹克给她带来的快乐,以此来弥合他的感受和约会对象期望之间的差距。虽然这种方法可能比常规建议更为少见和出人意料,但它非常契合这个场景,而且容易实施。总体而言,我们发现提出的非常规建议既合理又富有创意,超出了我们的预期,展示了 EGS 在日常沟通问题中的潜在价值。

生成

在演示的“生成”阶段,我们展示了两个候选方案,每个方案都是根据两条建议生成的。在第一个候选方案中,我们看到了对常规建议的采纳:“那件夹克真的让你的眼睛更加熠熠生辉”,接着是对非常规建议的运用:“我能看出这让你非常开心”。一般来说,我们发现 GPT-4 常常会对建议进行调整或增加细节,比如把“颜色”换成“光彩”,可能是为了配合夹克的黑色,同时也让“光彩”与“这让你非常开心”相呼应。

在第二个候选方案中,我们看到了建议的交错运用:候选方案以建议 2 中的“这对你来说是个大胆的尝试”开始,然后转向建议 1 中的“这种风格可能有点难驾驭”,最后又回到了建议 2 中的“看你尝试新风格,我觉得非常开心”。总的来说,我们注意到“生成”环节在结构上对如何融入建议非常灵活,同时能够将这些建议与场景背景无缝衔接。我们还发现,虽然我们框架的提示结构保持不变,但生成的内容始终与场景、说话者和目标紧密相关,这一点在我们所有的实验中都得到了验证。

模拟环节

在演示的模拟环节中,我们从模拟约会的角度,展示了在生成环节中两位候选人之一的对比。模拟观众会先独立地思考每个场景,然后综合这些思考形成最终的判断。这个判断最终会和其他所有判断一起,帮助我们挑选出最合适的回应或建议。

对于第一个场景,模拟的反应从对候选人的总结开始:“他给出了一个直接的赞美,主要谈论了这件夹克让我的眼睛看起来有多迷人,以及它是如何提升我的幸福感。”接着,他谈到了这对约会的意义:“他注意到了我愉悦的情绪,并捕捉到了我的穿衣风格的个性化特点。”最后,他对整个情境作出了更高层次的思考:“这显示出他不仅仅是在外观上注意我,还在情感层面上给予关注。”总体来看,我们发现在这些分析中层次化的思考非常常见,这让模拟对比能够全面考虑沟通中的各个方面。

对于第二个场景,尽管模拟反应是逐句进行的,但在对最后一句话的反应中体现出了两个层次:首先突出了约会对象的兴奋之情,然后总结他是“有兴趣共享购物的乐趣”。模拟反应还指出了“there's nothing you can't make look good”这句话太过普通,这是一个相当中肯的解读,但可能并不是人人都会这么认为。在观众的反应难以预测、规格不明确的情况下,我们发现 LLM 表现得相当出色,通常能够采用一种代表大多数观众观点的反应。我们相信,这在很大程度上是模拟环节能够与人类评审和在线用户高度一致的原因,我们将在接下来的两个部分通过实验来验证这一点。

5 人类评价

我们针对所有候选项以及每种情境下的两种基准方法,进行了人类评价。目的是为了 1)检验我们框架所选建议及候选项与其他选项相比的表现如何,以及 2)人类评价者和 GPT-4 进行成对比较时的一致性有多高。

数据收集方面,我们设计了八个不同的场景,覆盖了人际交流的十个基本过程(详见附录 A.1 和 A.2)。对于每个场景,我们对 EGS 生成步骤中的所有候选项、两个基线方法(GPT-4 零次射击和连锁思考 CoT)以及通过改变 EGS 探索步骤中搜索范围生成的两组削减候选项进行了人类打分。

在 EGS 中,我们使用了三条常规建议和一条非常规建议,并对它们进行了组合。候选项是基于包含至多两条建议的建议集生成的,这个决定是根据我们预先进行的一项研究(参见第 5 节)。最终,我们得到了 10 个不同的建议集,并为每个集合生成了三个候选项,共计 30 个候选项。

在 GPT-4 零次射击的基线方法中,我们使用了建议生成的提示,但是将生成建议的请求直接替换为询问如果模型是场景中的代理,它会说什么。在 GPT-4 连锁思考(CoT)的基线方法中(由 Wei 等人在 2022 年提出),我们使用了相同的格式,但要求模型在给出它会说什么之前,先生成关于该场景的推理过程。我们也为每种基线方法生成了三个候选项。

对于 EGS 探索步骤中被改变的两个版本,我们分别提示模型生成鼓励性或无关紧要的建议,而非概念性建议。每个版本我们使用了三条建议,从而形成了 6 个建议集,或者每个版本 18 个候选项。

人类评分采用了 0-10 的 Likert 量表,其中(0)代表极其负面的影响,(5)代表相对中立的影响,而(10)代表极其积极的影响。以演示中的场景为例(见第 4 节):

(0)“我觉得他的评论会大大降低我对约会的兴趣。”

(5)“我认为他的评论对我享受约会没什么影响。”

(10)“我认为他的评论会让我更加享受约会。”

参与者信息。在我们这个行为研究中,我们从 652 名来自英国的参与者那里收集了共计 12,180 个人的判断数据。这些数据是通过一个名为 Prolific 的在线众包平台来获取的。所有的参与者在参与实验之前都已经明确知晓并同意了实验的相关事项,这一过程是遵循了一套正规的机构审查委员会(IRB)协议的。至于参与者的报酬,我们按照每小时 12 美元的标准来支付。在我们的实验中,我们为每个实验场景的每个被测试对象及基准条件收集了 20 个评判结果,而每位参与者最多提供了 20 个评判结果。通过这些数据,我们计算出了一个非常高的平均评价者间可靠性(IRR),其值为 0.82,这个结果是通过使用 Spearman-Brown 校正法进行二分法相关计算得到的(详情见 Brown, 1910)。如果你对数据收集的具体程序感兴趣,可以参考附录 A.4 查看更多细节。

5.1 结果:EGS 在对比中表现出色

| 场景 | GPT-4 零次学习 | 连锁思考 | EGS (我们的) |

|---|---|---|---|

| 飞机坠毁 | 6.83 | 5.98 | 7.95 |

| 产品发布 | 5.73 | 5.95 | 7.05 |

| 讨价还价 | 4.68 | 5.98 | 5.85 |

| 讨价还价(非常规建议) | 4.68 | 5.98 | 6.60 |

| 咖啡师 | 5.58 | 5.78 | 5.40 |

| 分享秘密 | 3.67 | 4.17 | 5.55 |

| 约会应用 | 5.42 | 6.48 | 5.05 |

| 约会时的白色谎言 | 6.12 | 6.02 | 6.70 |

| 婚姻争吵 | 6.78 | 6.70 | 7.80 |

| 平均分 | 5.50 | 5.89 | 6.44 |

表 2:从人类评分来看,EGS 选择的信息在所有设定的场景中都优于 GPT-4 零次学习,并在五个场景及其子场景中超过了 GPT-4 连锁思考。

我们对比了 EGS 选择的信息与 GPT-4 零次学习和 GPT-4 连锁思考的人类评分平均值。EGS 在所有场景中都优于 GPT-4 零次学习,并在五个场景中超过了连锁思考(见表 2)。平均来看,EGS 的表现比 GPT-4 零次学习高出 0.94 分(提升了 17.1%),比连锁思考高出 0.55 分(提升了 9.3%)。在这八个场景中,有四个场景中 EGS 的表现至少高出了两个基线 1 分。

我们还注意到,EGS 在所有情况下的输出都超过了 5 分的平均值,表明其在所有场景中都对交流者的目标产生了积极影响。而两个基线则没有达到这一点。这说明 EGS 不仅能扩大搜索范围,找到更有可能产生积极结果的选项,还能通过模拟受众反应,准确判断哪些选项会真正带来积极的效果。

在 Bargaining 场景下,我们观察到 Chain-of-Thought 比 EGS 表现得更好一些(分数分别是 5.98 和 5.85)。不过,当我们仔细看这个结果时,我们发现在一些非常规的建议上,人类和 GPT-4 的看法出现了明显的分歧(具体细节可以参考第 5.2 节)。当我们把这些受争议的建议从我们的候选方案中剔除,缩小了探索范围后,EGS 的表现就大幅度领先于 Chain-of-Thought(分数分别是 6.60 和 5.98)。总的来说,我们发现 EGS 的效果与 GPT-4 与人类评价在模拟步骤中的一致程度息息相关,这一点我们接下来将进行更深入的分析。

5.2 结果:人类评分与 GPT-4 的高度一致性

多层面的场景分析。我们运用多层面模型,对比了在八种不同情境下 GPT-4 和人类评价者对各种沟通选项的一致性。我们的目的是要确认,是不是那些受到多方利益相关者欢迎的选项,也能从人类评价者那里得到较高的评分。

在这个多层次的分析模型中,我们以利益相关者对各个选项好坏的加权平均判断作为自变量,其中,他们会对每一对选项评判三次,分别给出更好(1 分)、更差(0 分)、或打平(0.5 分)的评价,再取这些评价的平均值。而因变量则是人类评价者给出的分数,这个分数的范围是 0 到 10 分。数据呈现出三级结构:单个项目嵌套在成对比较中,而这些比较又嵌套在各个场景中。为了控制不同场景间固有的差异,我们将场景视作随机效应来处理。

模型结果显示,加权成对判断对人类评分有显著的固定效应(系数为 0.427,p 值为 0.041),这为 GPT-4 和人类评价在不同场景中的高度一致性提供了有力的证据。我们还发现这种效应在不同场景中的表现各异,这证明了多层次模型能够有效地考虑到数据的层次结构。

场景内 GPT-4 成对比较的胜负关系与人类评分的平均值。在每个场景内,我们对受欢迎和不太受欢迎的候选者进行配对样本 t 检验,发现在八个场景中有五个场景里,受欢迎的候选者的评分显著高于不受欢迎的候选者,显著性水平设为 0.001(详见表 3)。

我们特别注意到,在谈判场景中,有一个建议虽然同时出现在 EGS 的最佳建议集和最佳候选者中,却只获得了 5.56 的平均人类评分(没有包含这个建议的候选者平均评分为 6.20,t 检验的 p 值小于 0.001):

“考虑提议在你的社交媒体上推广工匠的作品,以此来换取花瓶的折扣。”

当我们去掉这一建议,重新运行分析框架后,受欢迎候选者在成对比较中的优势再次变得非常明显。在我们的实验中,这种情况被标记为“谈判(-去除非常规建议)”。

更广泛地看,对于那些包含非常规建议的候选者,我们不仅发现人类评价者之间以及人类评价者与 EGS 之间的分歧增大,而且在七个场景中的大部分场景里,人类评价者内部也存在较大分歧(详见附录 A.5)。这表明,在由非常规建议造成的特殊情境下,预测受众反应对于人类和大语言模型(LLM)来说都存在一定的不确定性。

尽管这个指标能够用来检验统计显著性,但它在很大程度上受到了那些分数差异较大、较易比较的情况的影响。因此,我们接下来采用百分比一致性分析,确保每一对选项在分析中的权重相等。

对单个场景进行百分比一致性分析。

| 场景 | 更受喜爱 | 相对较差 | 一致程度 |

|---|---|---|---|

| 飞机坠毁 | 6.19 ± 0.03*** | 5.86 ± 0.03 | 0.63 |

| 产品发布 | 6.20 ± 0.03*** | 5.87 ± 0.03 | 0.67 |

| 讨价还价 | 5.90 ± 0.03 | 5.99 ± 0.02* | 0.53 |

| 非常规讨价还价建议 | 6.35 ± 0.04*** | 6.06 ± 0.03 | 0.69 |

| 咖啡师工作 | 4.66 ± 0.08*** | 3.53 ± 0.09 | 0.64 |

| 透露秘密 | 5.72 ± 0.03*** | 4.99 ± 0.04 | 0.78 |

| 使用约会应用 | 5.24 ± 0.03 | 5.44 ± 0.03*** | 0.41 |

| 约会时撒的善意的小谎 | 6.70 ± 0.03 | 6.81 ± 0.03** | 0.43 |

| 夫妻争吵 | 6.34 ± 0.04*** | 6.01 ± 0.03 | 0.65 |

表 3: 在这两种标准下,我们发现在五个场景和另一个场景的一部分中,GPT-4 与人类众包工作者的评价高度一致。更受喜爱和相对较差的数值是基于所有 GPT 成对评估的平均得分,并提供了平均值的标准误。*、** 和 *** 分别代表 、 和 。一致程度表示在随机决定平局情况下的预期一致百分比。

关于一致性的计算,我们是这样进行的:首先,我们取了 个人类平均评分和 个成对比较的结果。对于每一对候选对象 和 ,我们计算了它们的人类平均评分 和 ,并在决定平局时倾向于评分较高的一方。对于每个模拟的观众群体,我们平均了 和 之间超过 3 次的比较结果,然后使用 LLM 分配的权重计算了跨观众群体的加权和。最终,我们得出了三个分类——大多数人更喜欢 ,大多数人更喜欢 ,意见平分——分别用 、 和 来表示。

这个衡量标准可以看作是在两组评分之间预期达成的一致性百分比,分别是 和 。其中 表示在打平的情况下随机决定结果。我们没有按照偶然达成一致的期望水平(比如 Cohen 的 指标)来调整这个衡量标准,因为我们成对评分的分类本质上是公正的,只与展示给评分者的候选者的顺序有关。特别地,我们并没有在 EGS 执行的成对比较中发现任何位置偏好的证据,即评分者不会因为内容以外的因素而偏好某个特定情景(参见 Wang 等人 2023 年的研究2023 和附录 A.7)。运用这个衡量标准,我们发现人类评分者和 GPT-4 在成对评价中的一致性相当高,其中有五个场景(飞机坠毁、产品发布、咖啡师、分享秘密和婚姻争吵)的一致性超过了 0.6(见表 3)。另外,当我们仅考虑那些人类评分差异较大的情景时,一致性更加显著,其中四个情景的一致性最终达到了 0.8,样本量适中(具体细节参见附录 A.8)。这些结果验证了我们之前的分析,证明了 GPT-4 在很大程度上能够模拟人类观众的判断。我们还发现,在“讨价还价”的场景中去除了非常规建议后,一致性提高到了 0.69,确认了在这种情况下 EGS 和人类评分的一致性。然而,在“约会应用”和“约会期间的善意谎言”这两个场景中,我们观察到的一致性不到 0.5,这说明 GPT-4 结合 EGS 在评估约会建议方面存在一些困难。

5.3 实验剖析及进一步分析

通过模拟观众的评估,我们成功地挑选出了高性能的候选方案。我们对 "模拟" 步骤的有效性进行了一次割除实验,通过比较 EGS 系统挑选出的最佳方案和建议,与从 "生成" 步骤中随机选取的方案进行对比。在五种不同的场景中,以及在一个没有采用非常规建议的讨价还价场景中,EGS 系统选出的方案和建议明显优于随机选择的结果(详见表 4)。

值得注意的是,在 "模拟" 步骤表现较差的三个场景中,人类与 GPT 的一致性也相对较低。这验证了我们的一个直觉,即方案选择的性能很大程度上取决于比较过程的准确性。

| 情景 | 平均得分的候选方案 | EGS 选择的候选方案 | 平均得分的建议集 | EGS 选择的建议集 |

|---|---|---|---|---|

| 飞机失事 | 6.03 0.66 | 7.95 | 6.03 0.40 | 6.37 |

| 产品发布 | 6.03 0.57 | 7.05 | 6.03 0.44 | 6.68 |

| 讨价还价 | 5.95 0.54 | 5.85 | 5.95 0.43 | 5.63 |

| 讨价还价(去掉非常规建议) | 6.20 0.45 | 6.60 | 6.20 0.31 | 6.57 |

| 咖啡师工作 | 4.08 1.84 | 5.40 | 4.08 1.86 | 5.55 |

| 分享秘密 | 5.36 0.84 | 5.55 | 5.36 0.78 | 5.95 |

| 使用约会应用 | 5.41 0.68 | 5.05 | 5.41 0.57 | 4.98 |

| 约会时说白色谎言 | 6.75 0.61 | 6.70 | 6.75 0.39 | 6.37 |

| 夫妻争吵 | 6.18 0.79 | 7.80 | 6.18 0.62 | 6.88 |

表 4:通过实验剖析 "模拟" 步骤,我们发现模拟观众评估并选择最优方案的方法,要优于随机选择方案或建议集的方法。这一结论在五种场景以及第六种场景的一个特定子集中都得到了验证。表中还列出了候选方案和建议集的标准差。

我们应该如何选择搜索空间,这个决定到底有多重要呢?我们尝试了在各种情境下,对比使用概念性建议、鼓励型建议和不相关建议三种方式进行搜索,并发现在其中八个情境中,有六个情境中概念性建议带来的候选项平均表现更出色(详见表 5)。在使用鼓励型建议和不相关建议的版本中,我们调整了探索步骤,让 GPT-4 分别生成鼓励交流者和与情境无关的建议,而非提供具有战略价值的建议。

从人类评分的平均分来看,概念搜索空间下的候选项在所有八个情境中都优于不相关搜索空间的候选项,其中七个情境的差异非常显著()。特别是在飞机坠毁这一情境中,不相关建议带来的候选项的评分比概念性建议的候选项整整低了 4 分多(满分 10 分),足以见得选择正确的搜索空间有多么关键。虽然在大多数情境下概念性建议都优于鼓励型建议,但在咖啡师这一情境下,概念性建议的表现却不如鼓励型建议,这说明最适合的建议方式可能还需要根据具体情况来确定。

| 情景 | 基于概念的搜索空间 | 无关的搜索空间 | 鼓励性的搜索空间 |

|---|---|---|---|

| 飞机失事 | 6.03 ± 0.07 | 1.92 ± 0.11*** | 3.91 ± 0.14*** |

| 产品发布会 | 6.03 ± 0.09 | 5.82 ± 0.10 | 4.26 ± 0.12*** |

| 讲价 | 5.95 ± 0.09 | 3.98 ± 0.14*** | 5.00 ± 0.12*** |

| 咖啡师工作 | 4.08 ± 0.11 | 2.85 ± 0.14*** | 5.84 ± 0.12*** |

| 交换秘密 | 5.36 ± 0.09 | 4.91 ± 0.11** | 4.89 ± 0.11** |

| 使用约会软件 | 5.41 ± 0.08 | 4.65 ± 0.11*** | 5.34 ± 0.11 |

| 约会时撒白色谎言 | 6.75 ± 0.08 | 3.62 ± 0.13*** | 5.57 ± 0.13*** |

| 夫妻争吵 | 5.41 ± 0.10 | 4.39 ± 0.14*** | 6.45 ± 0.13 |

表 5:通过对“探索”步骤的深入研究,我们发现在六种不同的场景中,通过搜索基于概念的空间来寻找建议并据此设置候选方案,比起搜索无关或者鼓励性质的建议,能够创造出更高质量的候选方案。错误值显示的是均值的标准误差。星号的数量分别代表 , , 和 。

非传统建议到底有多有效?我们通过将使用了非传统建议的候选方案和未使用的进行对比,发现在八种情景中有四种情景下,包含非传统建议的方案表现更出色,其中两种情景中的差异在统计学上是显著的()。此外,我们还观察到,在其中两种情景中,得到人类评分最高的候选方案是基于非传统建议制定的,这证明了非传统建议在创造更好的沟通选择方面的潜力。特别值得一提的是,由于每个候选方案最多只能包含两条建议,非传统建议在表现出色时会取代一条常规建议。

接受过多的建议可能会让性能大打折扣。大语言模型的一个优势是能够处理比人类更多的建议。我们就此进行了一项研究,在一个特定场景中,候选答案最多可以基于三条建议。但结果发现,当引入了三条不同的建议时,模型的表现大不如前。具体来说,我们发现 GPT-4 会试图把所有建议都融入到生成的文本中,这最终导致了内容杂乱无章、篇幅冗长的输出。

鉴于此,我们在后续的主实验中将生成步骤中的最大建议数量限制为两条。这也更符合模型的实际应用场景:在现实生活中,我们通常会发现,人类在处理建议时更擅长于集中精力处理少数几个重点建议(参见 Miller 的研究 1956)。不过值得注意的是,随着大语言模型能力的不断增强,它们处理大量建议的能力也可能会随之提升。

6 拓宽的互联网用户模拟研究

我们对 EGS 的核心功能——模拟受众,进行了更为广泛的测试。这次,我们利用斯坦福人类偏好(SHP; Ethayarajh 等人2022)的数据集 33https://huggingface.co/datasets/stanfordnlp/SHP,来检验在多种互动场景下的表现。这个数据集包含了 385K 条涵盖 18 个不同主题领域的人类偏好数据,这些数据是针对人们在在线论坛上对各种问题或指令做出的回应。从烹饪到法律咨询,这些领域覆盖广泛,为我们检验 GPT-4 在模拟不同受众类型上的能力提供了一个坚实的平台。每条数据包含一个论坛帖子、两条评论及其获得的点赞数。我们在附录中的表格15和16中举了两个例子。

我们通过三种方法来评估预测哪条评论会获得更多点赞的准确性。首先,我们用连锁思考作为基准,让模型先分析帖子,再判断哪条评论可能会获得更多的点赞。接下来,我们运用了两种 EGS 模拟方法,每种都基于我们事先定义的受众档案。第一种,我们称之为默认的 EGS Reddit 用户 模拟,它让模型先从一个论坛浏览者的视角来考虑问题,再决定更倾向于点赞哪条评论;第二种,我们称之为幽默的 EGS Reddit 用户 模拟,它在默认设置的基础上,增加了对幽默和娱乐性评论的偏好。具体使用的提示和模拟受众输出的例子,都可以在附录A.9中找到。

我们按照 SHP 作者的方法,先通过 3 的比率阈值筛选数据集,确保每一组评论中,受欢迎的那条评论确实更受欢迎。为了减少 API 调用的成本,我们选取了 5 个 subreddits,并从每个中随机抽取了 100 个测试实例,共进行了 500 次评估(详见附录A.9)。

| 领域 | 思维链 | EGS Reddit 用户 模拟(默认) | EGS Reddit 用户 模拟(有趣) |

|---|---|---|---|

| 法律咨询 | 71.0 | 70.0 | 76.0 |

| 烹饪问答 | 59.0 | 60.0 | 70.5 |

| 人力资源问答 | 72.0 | 76.0 | 72.5 |

| 向我解释 | 74.0 | 76.0 | 71.5 |

| 社会科学问答 | 77.8 | 79.4 | 61.9 |

表 6:在不同观众提示下,EGS 的模拟 Reddit 用户 表现出比 GPT-4 的思维链更符合 Reddit 用户 的偏好。在较为随和的论坛如法律咨询和烹饪问答中,将模拟观众调整为追求娱乐可以获得最佳性能。而在像社会科学问答这样严肃的论坛里,采用默认观众模拟则更为准确。

我们在表 6 中展示了 CoT 与两种模拟观众之间的对比。我们发现,不论是在哪种情况下,EGS 的模拟 Reddit 用户 都不输于 CoT 基线,这说明模型在被明确告知需要模拟真实用户(即 Reddit 用户)时,能够做出更贴近他们的决策。此外,当模型被引导去寻找有趣且富有娱乐性的评论时,它在如烹饪和法律咨询这样较为随和的论坛上表现尤为突出。

在像社会科学问答这样的领域,论坛规定评论必须引用相关社科来源并且必须认真回答问题。在这样对评论质量有严格要求的地方,我们预期默认的观众模拟会更加准确,而寻求娱乐的观众模拟表现则会有所下降。我们的实验进一步证明了 Simulate 组件能够适用于各种网络用户数据,并展示了通过更好地理解目标观众,我们能够进一步提升它的性能。

7 讨论

接下来,我们将探讨我们工作的优点、可扩展性、特定领域应用、潜在局限性以及其广泛影响。

7.1 易于理解的解释和随时可用的备选方案

EGS 的一个显著优势在于,它能够提供直观且易于理解的判断解释。由于它会对每一对候选项进行详细的推理比较,用户能够轻松地从各个模拟观众的角度理解为何某个选项胜过另一个,从而得到一个关于框架如何做出最终决策的全面解释,或者了解其他候选项的排名情况。

同样,如果用户对 EGS 推荐的选项或建议不满意,他们可以随时查看在对比中表现不错的其他候选项,或者根据自己的偏好调整相关方权重或汇总方法(详见附录 A.10 中提供的备选方案)。

7.2 用用户控制增强框架

我们主要让 LLM 来识别潜在的受众群体,但有些情况下用户可能需要直接控制受众的构成和权重。比如,如果一家航空公司要就一起飞机事故发布声明,并且他们明确知道受众主要包括“家属”和“监管机构”,他们就可以根据需要定制受众成员,或者修改现有的受众档案。类似的用户操作还可以用来调整 EGS 中的建议内容、候选方案的类型,甚至是模拟比较的结果。

进一步说,这样我们还可以创建一个人机协作的 EGS 版本,在这个版本中,人可以全面审查和修改任何步骤。我们预计,更多的人为干预虽然会提高建议的质量和准确性,但可能也会增加人力成本。

7.3 扩展到多轮对话

EGS 主要用来优化单条消息,但通过扩展其生成步骤,它同样可以用来模拟多轮对话(在这个过程中,缩写变成 EGGGS)。通过这样做,我们可以在对话结束时模拟受众对整个对话的反应,并找到每个发言环节甚至整个对话中的最佳建议。

我们也可以设计一个每轮都重新搜索的版本(缩写变成 EGEGEGS),这样可以根据对话的走向调整建议,可能会有更好的效果,但可能不适合实时通讯。

这两种方法的局限在于它们会随对话长度的增加而产生大量候选方案,可能导致性能问题。为解决这一问题,我们可以在每几轮生成步骤后加入一个模拟步骤,每次只从中选择部分最优候选方案继续,这相当于在对话中加入了束搜索。

7.4 可扩展的情节式未来思考

EGS 的一个重要贡献是提供了一种新的可扩展方法,作为情节式未来思考的替代品。人类对未来的模拟受到时间线性流动的限制,而 EGS 通过并行化模拟比较,能够以远超人类推理的速度进行。

在我们的实验中,每个场景中每个受众档案要进行 1305 次两两比较,这个过程用了一个 GPT-4 API 密钥,耗时 2 到 4 小时,费用大约是 15 美元。平均下来,每 6 到 11 秒就能完成一次模拟比较,这可能已经比人类在某些场景下对未来的模拟要快了。随着速率限制的提升和并行处理的优化,EGS 的速度将更快,这使其可以应用于如电子邮件或公共声明这样的延时通信场合。不过,在需要实时响应的对话场景中,其应用仍然有限。

7.5 模拟的精细度

在观众模拟这个领域,我们一直在探寻一个问题:模拟观众需要多详细呢?目前我们让 LLM 生成观众角色,但我们并没有具体说明这些角色的细节要达到什么程度。不过,我们发现,在很多模拟比较中(比如表格 1 里的模拟步骤),常常会有一段话说明观众的喜好实际上取决于他们个人的详细信息。这就暗示了,或许在生成观众角色时,如果我们能够提供更多的细节,那么整个框架的性能就能得到提升。但与此同时,我们也要注意,太过详细的个性化设定可能会导致模拟结果的不准确,因为这样的情况实际中可能并不常见。需要指出的是,即便是在现有的设定下,LLM 有时也不能完全进入第一人称的角度来进行模拟,增加细节可能会让这种情况变得更加频繁。

这个问题不仅仅出现在观众的设定上,场景本身的细节同样重要。比如,在模拟一架飞机失事的场景时,我们可能需要考虑这个公司最近是否发生过类似事故,当天的天气如何,甚至人们是否因为全球大流行病而感到焦虑。总的来说,这里有一个非常有趣的平衡点,我们需要在尽可能准确地复现场景和让 LLM 更容易理解描述的场景之间找到平衡。而如何做到这一点,我们期待在未来的工作中找到答案。

7.6 应用场景:回溯过去

EGS 不仅能够帮助我们优化现在的交流,规划未来的策略,还能让我们回溯并理解过去的沟通事件。特别是,我们可以运用反事实推理(CFR)来分析:假如当初的情况有所不同,结果会如何变化。这个问题早在 2000 年 Pearl 的工作中就已经被提出。虽然 Ma 等人在 2023 年的研究中也利用 LLM 来进行反事实推理,并主要关注在道德推理方面的提升,我们这里提出的是利用反事实推理来分析沟通中的因果关系。

具体来说,我们可以拿过去的某个沟通事件作为例子,运用 Explore 和 Generate 来构思不同的沟通策略,然后通过 Simulate 来预测这些策略可能带来的不同结果。在这个过程中,我们还可以将实际使用的沟通方式和最终的结果作为一个参考标准,加入到提供给 LLM 的上下文中,以此来优化模拟结果。通过比较不同沟通策略的模拟效果,我们就能在虚拟的环境中分析,找出哪种沟通方式可能会带来更好的结果,或者哪些潜在的建议可能是导致特定结果的原因。虽然由于模拟的局限性,这些分析可能并不能完全应用到现实世界中,但它们提供了可以在实际实验中验证的假设,具有重要的参考价值。

7.7 实践应用:对人类研究和强化学习的启示

EGS 不仅仅可以为我们提供建议或交流的建议,它还可以直接用于模拟人类的喜好或反馈。在这里,我们重点介绍了两个潜在的应用场景:人类参与的研究和强化学习中的人类反馈(RLHF)。

当我们把人类研究中的指导看作是一种“交流”,目标是获取高质量数据时,EGS 就能发挥作用,帮助我们设计和测试多种用户研究。简而言之,我们可以使用 EGS 来“探索”和“创造”不同的研究方案,再通过“模拟”参与者来收集研究数据。最重要的是,我们可以将参与者的模拟反应分为两部分:一是为研究收集的数据,二是对哪种研究设计更佳的个人喜好,这使我们能够在设计优化和数据收集方面同时取得进展。已有众多研究证明,大语言模型(LLMs)在模拟人类参与研究中非常有效(详见第 2 节)。但与这些研究不同的是,EGS 不仅能生成数据或反馈,还能测试并自主选择最合适的参与者指导方案。

与需要训练明确奖励模型的 RLHF 不同(参见 Ouyang 等人,2022),EGS 能够在某些情况下产生类似于奖励模型的观众成员,对生成内容进行评价。此外,EGS 还能模拟具有不同背景和经验的观众,这可能有助于提供更具多样性和代表性的人类反馈。未来的工作可能会展示这两种方法的比较和协作潜力。

7.8 大语言模型:共享文化体验的桥梁

通过建立这样一个协助交流的框架,我们还能够利用大语言模型的训练数据来共享超越个人、文化或地理界限的信息。比如,一位在地球另一端的咖啡店工作的咖啡师可能不会注意到一个顾客给予的五星级在线好评,及其愉悦的体验描述,但大语言模型却能够考虑到这些信息,并将不同的观点融入其生成的回应中。同样,一个试图解决婚姻问题的人可能不习惯阅读关系建议的论坛,但大语言模型能够从这些地方获取灵感,并提供有意义的建议。通过建立这样的框架,我们希望帮助人们接触到他们通常可能接触不到的沟通策略,不仅仅是提升他们的沟通能力,更希望帮助他们在沟通方面实现自我成长。

7.9 影响深远:好的一面与可能的风险

在本文中,我们通过各种情景展示了 EGS 如何助力于各种有明确目标的沟通,这些情景覆盖了人际交往的十大基本流程,还有五个截然不同领域的网民模拟。无论是跟不熟悉的人交流,还是减少因为误解引发的沟通障碍,EGS 都能发挥其独特优势。我们特别推荐使用 EGS,它能帮助我们以更贴心、更易于接受的方式表达自己的想法,特别是在那些意见分歧较大的群体之间。

然而,我们也清楚地认识到,EGS 这样的工具是一把双刃剑,它在帮助人们更有效沟通的同时,也可能被用来执行对社会有害的活动。比如说,EGS 虽然能提升电邮沟通的效率,但也可能被用来制作更具迷惑性的网络钓鱼邮件,提高诈骗的成功率。幸运的是,现在已经有研究者正在努力通过强化学习方法对这类模型进行调整,以识别和拒绝那些带有恶意意图的请求(参见 Touvron 等人 2023 年的研究和 Huang 等人 2023 年的研究),我们有理由相信,这些努力将有助于提升 EGS 在安全性方面的表现。

我们还注意到,我们所设计的情景中包含了一些符合常见刻板印象的角色,比如一个年轻男子试图恭维女性约会对象的情境。我们希望未来的研究能够关注更加多元和复杂的背景和关系,特别是那些在训练数据中较为稀缺的群体,因为这可能会影响模拟结果的准确性。作为一个基于 LLMs 的系统,EGS 也可能会继承其固有的一些问题,比如社会偏见的问题,这些问题可能会影响到最终的决策。因此,我们建议用户在将 EGS 的输出投入使用前,务必仔细验证。

最后,我们也意识到,由于信息获取的不平等或者高昂的使用成本(每个场景每个模拟观众需要 15 美元),并不是社会中的每个人都能平等地使用我们的方法,这可能会加剧社会不平等的问题。为了缓解这一问题,我们在 https://github.com/theryanl/EGS 上提供了我们的代码,欢迎大家使用和改进。

8 总结

在这篇文章中,我们尝试了利用大语言模型(LLMs)来模拟听众,目的是为了提升我们进行目标明确沟通时的效果。为了实现这一点,我们推出了一个叫做 EGS 的框架,这个框架可以帮助我们探索可能的解决方案,生成一系列可能的沟通方式,并通过模拟不同听众的反应来找出最合适的沟通方式和建议。我们发现,EGS 不仅能够成功地找出表现最好的沟通方法和建议,而且表现还超过了一些基础模型,比如 GPT-4 with Chain-of-Thought。另外,无论是在哪种情境下,EGS 给出的结果都与人类评审者的看法高度一致,并且这一框架也能够很好地应用到更广泛的在线领域中,为我们提供了一种全新且可行的方法,以模拟听众反应,从而改进我们的沟通方式。

我们的研究结果显示,借助认知科学领域的知识,我们有机会开发出新的程序和工具,它们能够替代人类在思考和沟通时内在进行的一些步骤,而这一切都可以通过大语言模型来实现。通过这种方式,我们不仅能够增强语言模型的能力,还能为那些想要更好地与他人沟通和理解他人的人提供创新的支持。

致谢

在这里,我们要感谢以下几位同事,他们给予了我们极富价值的建议和深刻的见解:Mengzhou Xia, Ilia Sucholutsky, Yuhan Liu, Jiafei Duan, Sebastin Santy, Jieyu Zhang, 以及 Joon Sung Park.

参考文献

- J. Andreas (2022) 探索语言模型作为代理模型的可能性。可以在 arXiv 预印本库找到,文献编号:2212.01681. 相关讨论见 第 2 节.

- L. P. Argyle 等六位作者 (2023) 利用语言模型模拟人类行为的多样性。发表在《政治分析》第 31 卷第 3 期,页码从 337 到 351. 更多细节见 第 2 节.

- C. M. Atance 和 D. K. O’Neill (2001) 未来情节思考研究概览。《认知科学趋势》第 5 卷第 12 期,页码从 533 到 539. 详细信息参见 第 1 节 和 第 2 节.

- Y. Bai 等人 (2022) 如何通过人类反馈进行强化学习,以培养出既有帮助又无害的助手。相关链接:2204.05862,详细内容见 第 2 节.

- C. R. Berger 和 M. E. Roloff (2019) 通信理论与研究综述(第三版). 更多信息请参阅 附录 A.1,第 1 节 和 第 2 节.

- R. Bommasani 等许多作者 (2021) 基础模型的前景与挑战。详情请见 arXiv 预印本,编号:2108.07258,以及 第 2 节 的相关讨论。

- W. Brown (1910) 探索心智能力相关性的实验研究(第一部分). 发表在《英国心理学杂志》第 3 卷第 3 期,页码从 296 到 322.

这篇文章受到了众多学术工作的引用,包括第 A.4 节和第 5 节。其中包括 E. Chu, J. Andreas, S. Ansolabehere 和 D. Roy 在 2023 年的工作,他们研究了如何通过基于媒体饮食训练的语言模型来预测公众的舆论,这篇论文发表在 arXiv 上。此外,F. de Saussure 在 1916 年的《通用语言学教程》中对语言学进行了深入探讨,并由哥伦比亚大学出版社出版。D. Easley 和 J. Kleinberg 在 2010 年的《网络、人群和市场:对高度连接世界的推理》一书中,探讨了网络、人群和市场之间的复杂关系。K. Ethayarajh, Y. Choi 和 S. Swayamdipta 在 2022 年的一篇论文中,通过 -可用信息深入分析了数据集的难度,这篇论文发表在第 39 届国际机器学习会议的论文集中。M. C. Frank 和 N. D. Goodman 在 2012 年的《科学》杂志上发表的论文中,探讨了如何预测语言游戏中的实用推理。最后,V. Gates, T. L. Griffiths 和 A. D. Dragan 在 2020 年发表在《认知科学》杂志上的论文中,探讨了如何在多人互动中提供有效帮助的问题。

Pelham 和 D. S. Krull 在 1988 年的研究中探讨了“认知忙碌”现象:当我们试图理解他人时,我们的大脑是如何忙碌工作的。这项研究发表在《个性与社会心理学杂志》,并在文献 §1 中被引用。_ D. T. Gilbert 和 T. D. Wilson 在 2007 年提出了“展望”理论,探讨了人类是如何体验和预测未来的。这项工作发表在著名的《科学》杂志上,同样也在 §1 章节中被提及。_ N. D. Goodman 和 M. C. Frank 在 2016 年的文章中探讨了我们是如何利用概率推断来理解语言的,该研究发表在《认知科学趋势》杂志,并在 §1 和 §2 中被引用。_ H. P. Grice 是语言哲学的重要学者,他在 1957 年的论文《意义》、1975 年的《逻辑与对话》以及 1989 年出版的书籍《言语的方式研究》中提出了许多重要观点,这些工作分别在 §2、§1 和 §2 中被引用。_ Y. Huang, S. Gupta, M. Xia, K. Li, 和 D. Chen 在 2023 年的研究中揭示了开源 LLMs(大语言模型)可能面临的严重安全风险,这篇论文在 §7.9 节中被提到。_ E. Jones 和 J. Steinhardt 在 2022 年的工作中通过研究人类的认知偏差,探讨了大语言模型可能出现的问题,这项研究发表在《神经信息处理系统进展》杂志,并在 §2 章节中被引用。_ S. B. Klein, T. E. Robertson, 和 A. W.

- Delton (2010) 面对未来:记忆作为一个演化出的规划未来行为的系统。Memory & cognition 38, pp. 13–22. 引用自:§2。

- J. Kleinberg 和 M. Raghavan (2021) 算法单一文化与社会福利。Proceedings of the National Academy of Sciences 118 (22), pp. e2018340118. 引用自:§2。

- P. Koralus 和 V. Wang-Maścianica (2023) 人为中心:在成功和失败中,GPT 都趋向于常识。arXiv preprint arXiv:2303.17276. 引用自:§2。

- D. K. Lewis (1969) 习惯:一个哲学研究。John Wiley

这些学术论文的引用情况如下:

- J. S. Park 和团队在 2023 年发表了一篇名为《生成代理:人类行为的交互式拟态》的文章,文章发表在 ArXiv 上,文章编号为 abs/2304.03442。这篇文章探讨了如何通过生成代理来模拟人类行为,并在交互过程中产生类似人类的反应。相关内容可以在文献 [§1]、[§2] 和 [§3.2] 中找到。

- 同样是 J. S. Park 和团队,在 2022 年他们发表了另一篇名为《社交拟态:为社交计算系统创建有人口的原型》的文章,并收录在《第 35 届年度 ACM 用户界面软件和技术研讨会论文集》中,文章页码为 1-18。这篇文章讨论了如何为社交计算系统创建一个有人口的原型,以更好地模拟社交环境。相关内容可以在文献 [§2] 中找到。

- J. Pearl 在 2000 年出版了一本名为《因果性:模型、推理与推断》的书籍,由剑桥大学出版社出版。这本书深入探讨了因果关系的模型、推理方法和推断过程。相关内容可以在文献 [§7.6] 中找到。

- Z. Qin 和团队在 2023 年发表了一篇名为《大语言模型是有效的文本排名器,具有成对排名提示》的文章,文章提到大语言模型在文本排名方面的有效性。相关内容可以在文献 [§3.3] 中找到。

- M. J. Salganik、P. S. Dodds 和 D. J. Watts 在 2006 年共同发表了一篇名为《人工文化市场中不平等和不可预测性的实验研究》的文章,发表在《科学》杂志上,文章页码为 854-856。这篇文章通过实验研究了人工文化市场中的不平等和不可预测性。相关内容可以在文献 [§2] 中找到。

- S. Santurkar 和团队在 2023 年发表了一篇名为《语言模型反映了谁的观点?》的预印本文章,文章编号为 arXiv:2303.17548。这篇文章探讨了语言模型在表达观点时所反映的问题。相关内容可以在文献 [§2] 中找到。

以上就是这些文章的引用情况和主要内容的简要介绍。

Addis 和 R. L. Buckner 在 2007 年的研究《回忆过去,构想未来:前瞻性大脑》发表于《自然评论·神经科学》第 8 卷第 9 期,篇幅覆盖第 657 到 661 页。这项研究在文章的第一部分、第二部分以及第三部分的第一个小节中被引用过§1,§2,§3.1。* T. C. Schelling 于 1971 年撰写的《动态隔离模型》发表在《数学社会学》第 1 卷第 2 期,篇幅从第 143 页延伸至第 186 页,该文献在文章的第二部分中被提及§2。* C. E. Shannon 于 1948 年撰写的《通信的数学理论》刊登在《贝尔系统技术期刊》第 27 卷第 3 期,篇幅从第 379 页至第 423 页,这篇文章在第二部分中有所引用§2。* D. Sperber 和 D. Wilson 于 1986 年合著的《相关性:沟通与认知》一书,由 Blackwell 出版,该书在文章的第一部分中被引用§1。* R. C. Stalnaker 于 1978 年发表的《断言》一文,发表在《语用学》上,篇幅覆盖第 315 至第 332 页,该文在文章的第二部分中有所引用§2。* K. K. Szpunar 在 2010 年发表的《情节性未来思考:新兴概念》一文刊登在《心理科学前沿》第 5 卷第 2 期,篇幅从第 142 页至第 162 页,这篇文章在第二部分中有所引用§2。* H. Touvron 等人在 2023 年发表的《Llama 2:开放基础与精调对话模型》一文,在文章的第二部分和第七部分的第九小节中被引用§2,§7.9。* P. Wang, L. Li, L. Chen, Z. Cai, D. Zhu, B. Lin, Y. Cao, Q. Liu, T. Liu 和 Z. Sui 在 2023 年联合发表的《大语言模型并非公正评估者》一文。

外部链接:2305.17926 引用本文的章节:附录 A.7, 第 5.2 节。_ J. Wei, X. Wang, D. Schuurmans, M. Bosma, F. Xia, E. Chi, Q. V. Le, D. Zhou 等人(2022 年)通过“思维链”提示促使大语言模型进行推理。发表在《神经信息处理系统进展》第 35 卷,第 24824-24837 页。引用本文的章节:第 5 节。_ I. Yaniv(2004 年)如何接受他人的建议:它的影响与益处。发表在《组织行为与人类决策过程》第 93 卷第 1 期,第 1-13 页。引用本文的章节:第 1 节, 第 3.1 节。* C. Ziems, W. Held, O. Shaikh, J. Chen, Z. Zhang, D. Yang(2023 年)大语言模型能否引领计算社会科学的创新?arXiv 预印本 arXiv:2305.03514。引用本文的章节:第 2 节。

附录 A

A.1 人际沟通的十大核心过程

在本节中,我们将深入探讨人际沟通中的十大核心过程(Berger 和 Roloff,2019)。这些过程构成了社交互动的基石,它们在各种社会交流环境中都有可能出现。

-

社会影响:指的是当人们的观点或行为发生分歧时,他们相互之间尝试施加影响的过程。

-

社会支持:在他人遭遇困难时,为其提供有效的帮助和支持。

-

关系发展:这涉及到关系的建立(包括最初的接触)、维护,以及关系的破裂(或称为关系的断裂)。

-

欺骗:这包括了施行欺骗行为可能会如何改变一个人的行为,以及人们识破欺骗的能力有多强。这里面也包括了那些出于善意的小谎言。

-

讨价还价与谈判:当交流中存在风险,尤其是当交流双方不确定是否能够信任对方时,人们发展出了一套确保公平交流的沟通机制。

-

冲突管理:这涉及到如何处理冲突带来的负面影响,以及人们是如何正面或负面地处理这些冲突的。

-

会话管理:这意味着在一次对话中,参与者都有一种默认的理解,认为每个人都会为对话作出贡献,推动话题的进展。

-

印象管理:个体会根据彼此之间的互动形成印象,并且这些印象会影响他们未来的互动和决策。

-

隐私管理:这涉及到个人信息透露的原因及其后果,即人们愿意将自己的个人信息分享给他人的倾向。

-

不确定性管理:由于人们无法完全确定对方当前的情绪状态、信念、态度和未来的行动,因此他们在进行社交互动时,必须在一定程度的不确定性中进行。

A.2 情景选择与细节描述

在本节中,我们将详细介绍八个不同的情景,以此来评估我们提出的框架。我们还将讨论这些情景所涵盖的核心沟通过程以及它们各自的特点。前四个情景主要集中在较为正式的人际关系上,而后四个情景则涉及更为个人化的关系。这些情景还涵盖了从口头到书面再到数字化等多种沟通方式。通过设计这些情景,我们希望能够涵盖框架可能帮助人们解决的各种潜在情境。

飞机失事

一位航空公司的发言人正努力降低公众对公司的负面看法。就在今天早些时候,该公司一架飞机因未知原因坠毁,造成 2 名乘客死亡。现在,发言人即将在一场现场直播的新闻发布会上向媒体发表首次公开声明。他们只有 30 秒的时间来阐述这一事件。

这个情景主要聚焦于社会支持这一核心过程,并涵盖了印象管理和社会影响。降低负面公众看法的关键在于为遭受打击的遇难者家属和朋友提供支持。这也是一个代理人及其公司冒险尝试不同信息内容过高的例子。在这一广阔的未知领域中,可能还存在着更优的沟通方式。通过我们的模拟框架,我们能在不承担风险的情况下找到一个合理的沟通策略。

新产品发布

一家公司的 CEO 正在隆重推出他们的新款智能手机——jPhone,并且他们想要将这款产品卖得如火如荼。jPhone 的特点包括:

- 速度飞快,媲美市面上最顶尖的智能手机

- 售价为 700 美元,比市场上其他品牌的手机要便宜 10% 到 30%

- 设计新颖独特,用户界面也非常友好

目前,他们正准备在各大主流电视频道上播放一段 30 秒的快速广告片,为 jPhone 增色添彩。

这个场景主要探讨的是社会影响和印象管理这两个基本的社会过程,同时也涉及到了销售过程中的议价和谈判策略。其中一个建议就是为购买 jPhone 的前几位客户提供限时优惠,这无疑是一个非常有吸引力的销售策略。

讨价还价

Jill 打算在当地一个手工艺市场购买一个圆形的花瓶,标价为 30 美元。虽然她心甘情愿按照原价购买,但如果能省点钱当然是最好不过了。此时此刻,她正准备和卖花瓶的工匠讨价还价。

这个场景着重于讨价还价和谈判的基本过程,同时也包含了社会影响和不确定性管理的元素。Jill 不清楚卖家到底能降价多少,这增加了谈判的复杂性。从卖家和买家的角度来看,这与产品发布的场景一起,展现了沟通优化的重要性。

咖啡师

作为一名咖啡师,他希望能从顾客那里获得尽可能多的小费。在他工作的时候,一位顾客走过来说:“你好,我能来一杯中杯全脂牛奶拿铁吗?”咖啡师需要在短时间内做出回应。

这个场景主要关注社会影响这一基本过程,同时也涉及到了不确定性管理和对话管理。虽然顾客有时会通过一些外在表现来暗示他们愿意支付的小费金额,但咖啡师仍然面临着不确定性。此外,这个场景还展示了一个事实,即有些高质量的生活知识可能还没有广泛传播到不同地区和文化中,但如果能够传播开来,无疑会提高顾客和咖啡师双方的生活质量。

分享秘密

Mary 通过工作认识了 Carla,她希望能够通过分享一些个人秘密来加深她们之间的友谊。她考虑分享的秘密从不太私人到非常私人分别是:

1. 她小时候不喜欢泡菜,但现在却越来越喜欢了。

2. 最近她在工作上感到缺乏自信。

3. 她以前花钱比较冲动,现在还背着一些债务。

此刻,她觉得氛围正好,可以尝试分享一个秘密来拉近彼此的距离。

这个场景主要关注隐私管理的过程,同时也涉及到了人际关系的建立、对话管理和印象管理。与其他场景不同,Mary 需要在几个选项中作出选择,这符合在建立亲密关系时保持真实性的重要性。此外,这种选择模式与原创内容生成的方式不同,因为可选的解决方案更为有限,这使得我们能够从不同角度评估这一框架的效果。

寻爱记

Eric,一个 20 出头的年轻小伙,渴望寻找到心仪的女朋友。他现在是一所大型公立大学的本科生,闲暇时喜欢打网球,与朋友们欢聚。他是个爱动物的人,家中有一只可爱的比格犬,名叫 Scott。谈到外貌和身高,Eric 觉得自己与众不同,水平中等。现在,他决定尝试通过交友软件来寻找另一半,并正在为自己的个人简介头疼,不知道该如何下笔。

这个情境主要探讨的是如何管理个人印象和面对不确定性,同时也略微涉及了恋爱关系起步阶段的话题。在交友软件中,你无法预知谁会浏览你的个人资料,而潜在的匹配对象个性和喜好的差异也可能非常大。因此,在优化沟通策略时,我们需要考虑这些不确定性因素。

约会小插曲

一位少年正在与一个他心仪的女孩在商场中约会,他希望让这次约会尽可能愉快。目前他们在一家服装店,他在等待女孩试衣服。当女孩穿着一件黑色牛仔夹克从更衣室走出来,满脸喜悦地摆了个造型,问他:“怎么样?”时,他心里明白这件夹克并不适合她,但他仍然决定给予她夸奖。此刻,他正在脑海中搜索合适的话语。

这个情景主要探讨了在关系发展和印象管理过程中,欺骗这一基本行为的运用。欺骗在我们的生活中占有重要地位,有时候我们不得不隐藏真实感受,以实现我们的目标。虽然现代先进的 LLM 可以通过制造幻觉来进行欺骗,但据我们所知,有意识的撒谎行为还尚未得到深入研究。

婚姻中的争执

一位妻子正对丈夫深夜不归,总是与朋友外出而感到不满。尽管丈夫固执己见,不愿意承认错误,但她相信他最终会认识到自己的问题。为了尽快解决这一矛盾,她决定与丈夫进行一次坦诚的交流。

这个场景主要讨论的是如何管理冲突,并涉及到维护恋爱关系和社交影响等话题。在这类敏感的情况下,运用模拟技术提供反馈和建议,将对解决问题大有裨益。

A.3 受众生成提示

我们通过询问 LLM 的方式,生成了一些可能的受众及其相对应的权重和个人资料。首先,我们询问 LLM 来确定哪些利益相关者以及他们对主人公目标的相对重要性:

提示:请你思考并列举出最多 位与主人公目标最相关的利益相关者,并给出他们各自的重要性打分,分数范围是 1 到 100。不必非要列满所有利益相关者,只需包括那些对主人公目标有影响的人。请按照下面的格式回答:

- 利益相关者姓名 (权重):理由

- ...

得到利益相关者名单后,我们进一步生成他们的系统提示和用户提示。

提示:请根据下面的情景,描述下面的角色。描述中需要包含主人公与该角色的交流情况。这里有一些不同情景和利益相关者的例子供你参考:

[几个例子]

你的任务:

情景:[提供的]

角色:[提供的]

描述:

提示:你需要向某个利益相关者提一个问题,让他们在两个不同情景中做出选择。问题的提出必须紧密联系主人公想要达到的目标。这里有一些不同情景和利益相关者的例子供你参考:

[几个例子]

你的任务:

故事:[提供的]

利益相关者:[提供的]

问题:

上述问题的回答将填充进下面的模板中:

情景 1:[情景 1 的选项]

情景 2:[情景 2 的选项]

[插入问题] 请你仔细思考,并解释你的推理过程。将你的回答格式化为:[推理文本]

答案:选择情景 [1 或 2]

最后,我们将这两个提示作为系统提示和用户提示,用于 LLM 生成受众之间的成对比较。

A.4 数据搜集步骤

在获得了参与者的知情同意后,我们给他们下了这样的指令:

“感谢您参与我们的研究!在本研究中,我们会展示一系列不同的情境,并在每个情境中提供一个人的陈述。您的任务就是对这些陈述根据其所处情境的相关性进行质量评价。您共有从 0 分(最差)到 10 分(最好)的 11 个选项可供选择,请选出您认为最合适的分数。请注意:完成此任务不需要任何专业知识,凭您的直觉做出选择即可。”

完成这些指令后,参与者进入了主实验阶段,他们需要对最多 20 个随机分配的回应进行 0 到 10 分的评价。以下是对各个情境的具体评价问题:

- 飞机失事:“你认为根据发言人的回应,公司在公众心目中的形象会有什么变化?”

- 产品发布:“如果你正打算换手机,听完 CEO 的介绍后,你会考虑购买 jPhone 吗?”

- 讨价还价:“根据 Jill 的回答,你觉得自己愿意和她商量这个花瓶的价格吗?”

- 咖啡师:“从咖啡师的回答来看,你会愿意给他小费吗?”

- 通过分享秘密建立亲密关系:“假如你是 Carla,听了 Mary 分享的秘密后,你觉得你们之间的关系会更亲密吗?”

- 约会应用:“根据 Eric 的选择,你觉得他的个人资料能吸引到潜在女友的可能性有多大?”

- 约会中说小谎:“作为那位女孩,你认为男孩的回答会对你享受约会的感觉产生什么影响?”

- 婚姻争吵:“作为丈夫,你是更愿意立即承认自己的错误,还是更倾向于先为自己辩护,或对妻子的评论感到不满?”

| 情境 | 候选回应数量 | 参与者数量 | 评分者间信度 |

|---|---|---|---|

| 飞机失事 | 72 | 76 | |

| 产品发布 | 72 | 78 | |

| 讨价还价 | 72 | 78 | |

| 咖啡师 | 102 | 103 | |

| 分享秘密 | 72 | 79 | |

| 约会应用 | 75 | 80 | |

| 约会时说小谎 | 72 | 80 | |

| 婚姻争吵 | 72 | 78 |

表 7:在所有的情境中,我们的人工评分显示出了很高的评分者间一致性(IRR)。对于每个情境,我们都列出了参与评估的回应数量,参与的众包工作者数量,以及评分者间一致性的值和 95% 的置信区间。

总体上来看,我们在表 7 中详细列出了不同情景下的参与者人数、候选者人数,以及通过 Spearman-Brown 相关系数(Brown,1910)计算得出的评分者间一致性(IRR)。从结果中我们可以看出,无论在哪个情景下,IRR 的值都相当高,这说明我们收集到的人类数据是非常可靠的。

A.5 不同评审员对非传统建议及其他数据子集的评价一致性

| 情景 | 基准数据 | 仅普通建议 | 非常规建议 |

|---|---|---|---|

| 飞机失事 | 0.96 0.01 | 0.71 0.10 | 0.70 0.13 |

| 产品发布 | 0.78 0.05 | 0.21 0.26 | -0.40 0.59 |

| 讨价还价 | 0.80 0.04 | 0.18 0.30 | -0.50 0.64 |

| 咖啡师 | 0.90 0.02 | 0.45 0.18 | -0.79 0.83 |

| 共享秘密 | 0.78 0.05 | 0.65 0.12 | 0.55 0.19 |

| 约会软件 | 0.71 0.06 | 0.59 0.15 | 0.37 0.27 |

| 约会中撒的善意谎言 | 0.87 0.03 | 0.49 0.18 | 0.44 0.25 |

| 婚姻争论 | 0.82 0.04 | 0.45 0.19 | 0.62 0.18 |

| 平均值 | 0.83 0.03 | 0.47 0.07 | 0.12 0.21 |

表 8:包含非常规建议的候选项在不同评审员间的一致性 (IRR) 低于任何其他子分类。基准数据是指对 GPT-4 零次学习、GPT-4 思维链条以及无关和概念性搜索空间候选项的 IRR。仅普通建议则是指建议集中不包含非常规建议的候选项。

通过计算基准生成、只基于普通建议的候选项、以及至少包含一个非常规建议的候选项(即非常规候选项)的 IRR,我们发现非常规候选项的 IRR 显著较低(详见表 8)。首先,这意味着即使是在人类评审员之间,模拟和一致判断非常规建议也更具挑战性。此外,这还意味着使用基于人类生成数据训练的任何大语言模型(LLM)进行模拟判断时,可能也会出现更多的不一致情况。

利用这一新颖的观点,我们深入探讨了几组候选配对之间的共识程度,包括两个常规配对、一个非常规配对和两个非常规配对。分析中运用了两种不同的评估方法:一是比较胜者与败者,二是计算百分比一致性(详见 表 9)。我们发现,在这两种评估标准下,常规建议之间的共识度普遍高于非常规建议之间的共识度,尽管二者之间的差距并不大。更为引人注目的是,常规候选者与非常规候选者之间的共识度在两种评估标准下都表现出意外的高度一致,这表明无论是在评分的绝对差值上,还是在评分的比例上,这两组候选者之间都达成了高度的一致。

| 胜者对败者 | 百分比一致性 | |||||

|---|---|---|---|---|---|---|

| 比较的建议 | 两个常规 | 一个非常规 | 两个非常规 | 两个常规 | 一个非常规 | 两个非常规 |

| 飞机失事 | 0.38**_ | 0.32_** | 0.28* | 0.63 | 0.63 | 0.62 |

| 产品发布 | 0.11 | 0.55**_ | 0.13 | 0.56 | 0.81 | 0.46 |

| 讨价还价 | 0.29_** | -0.36**_ | -0.06 | 0.70 | 0.41 | 0.53 |

| 咖啡师 | -0.01 | 2.33_** | -0.04 | 0.54 | 0.75 | 0.53 |

| 分享秘密 | 0.56**_ | 0.88_** | 0.61**_ | 0.73 | 0.82 | 0.79 |

| 约会应用 | -0.15 | -0.26_** | -0.15 | 0.46 | 0.37 | 0.44 |

| 约会中的善意谎言 | 0.01 | -0.15* | -0.27* | 0.47 | 0.41 | 0.37 |

| 婚姻争执 | 0.13 | 0.45*** | 0.41** | 0.53 | 0.73 | 0.65 |

| 平均值 | 0.16 | 0.47 | 0.11 | 0.58 | 0.62 | 0.55 |

表格 9:通过对胜者与败者以及百分比一致性的分析,我们发现常规和非常规候选者之间的一致性最高,其次是两个常规候选者之间,而两个非常规候选者之间的一致性最低。每种情境下分别进行了 153 次常规配对比较、216 次非常规与常规配对比较以及 66 次非常规配对比较。

A.6 对候选人建议数量的深入分析

| 场景 | 平均得分(单一建议) | 平均得分(多重建议) | 最高得分(单一建议) | 最高得分(多重建议) |

|---|---|---|---|---|

| 飞机失事 | 6.25 ± 0.20* | 5.88 ± 0.14 | 7.95 | 7.05 |

| 产品发布 | 5.71 ± 0.15 | 6.24 ± 0.12** | 6.55 | 7.05 |

| 讨价还价 | 5.77 ± 0.11 | 6.06 ± 0.14 | 6.30 | 7.20 |

| 咖啡师 | 4.83 ± 0.53*** | 3.57 ± 0.40 | 6.20 | 6.25 |

| 分享秘密 | 5.38 ± 0.31 | 5.34 ± 0.16 | 7.30 | 6.60 |

| 约会应用 | 5.55 ± 0.17* | 5.20 ± 0.17 | 6.40 | 6.50 |

| 约会时说小谎 | 6.80 ± 0.20 | 6.72 ± 0.13 | 7.95 | 8.00 |

| 夫妻争吵 | 6.32 ± 0.27 | 6.09 ± 0.16 | 7.80 | 7.45 |

表 10:为候选人提供多份建议并不总是能够提升其平均得分,但却经常能够提升最优候选人的表现。平均得分旁的误差代表标准误差,*、、* 分别代表在 p = 0.05、0.01 和 0.001 的水平上统计显著。

我们探究了为每个候选人提供多份建议是否能提升其表现,发现整合多份建议至候选人 1) 通常不会提升平均表现,但 2) 却能够提升表现最优的候选人。在表 10中,我们提供了使用一个和两个建议生成的候选人的平均得分和最高得分。我们发现,虽然单一建议在平均上表现更好(尽管通常差异不显著),但在五个场景中有多重建议帮助产生了人类评价最高的候选人。这展示了在生成步骤中,将候选人与多种建议组合起来进行匹配的重要性和益处。

A.7 模拟观众评判中未发现顺序偏好

在之前的研究(Wang 等人,2023)中,我们发现大语言模型(LLMs)有时会仅仅因为某些选项在列表中排在前面,就更倾向于选择它们。为了探究这种行为是否也存在于模拟观众的评判中,我们对他们进行了一系列成对比较的分析。在八种不同情境下,我们分别给“更倾向于情境 1”、“更倾向于情境 2”和“两者相当”三种情况赋予了 1、0 和 0.5 的数值,这和方程1中的做法相似。通过计算所有成对比较的平均值,我们得到了 0.5011 的均值和 0.0037 的标准误差。基于这个结果,我们认为在模拟观众的评判中,并不存在因选项顺序不同而产生的偏好。

A.8 在简单场景下,评价的一致性更为突出

| 场景 | 一致性 | 样本数 | 差异 ≥0.5 | 样本数 | 差异 ≥1 | 样本数 | 差异 ≥1.5 | 样本数 |

|---|---|---|---|---|---|---|---|---|

| 飞机坠毁 | 0.63 | 435 | 0.72 | 259 | 0.80 | 122 | 0.83 | 46 |

| 产品发布 | 0.67 | 435 | 0.74 | 237 | 0.83 | 92 | 0.96 | 28 |

| 议价 | 0.53 | 435 | 0.43 | 243 | 0.41 | 86 | 0.33 | 24 |

| 议价(去掉非常规建议) | 0.69 | 153 | 0.79 | 72 | 0.88 | 21 | 1.00 | 3 |

| 咖啡师 | 0.64 | 435 | 0.71 | 330 | 0.77 | 269 | 0.81 | 239 |

| 分享秘密 | 0.78 | 435 | 0.84 | 312 | 0.91 | 194 | 0.94 | 100 |

| 约会应用 | 0.41 | 435 | 0.37 | 282 | 0.31 | 144 | 0.37 | 52 |

| 约会时撒的善意谎言 | 0.43 | 435 | 0.41 | 265 | 0.40 | 124 | 0.58 | 33 |

| 婚姻中的争执 | 0.65 | 435 | 0.64 | 312 | 0.71 | 181 | 0.74 | 89 |

表 11:对比 GPT-4 的成对评分和人类的评分,我们发现在不同场景下它们之间的一致性是有差异的。在这里我们考虑了所有可能的成对比较,并且还对人类评分的差异进行了分类,以观察在不同差异程度下评价的一致性情况。其中 代表了各个子分类中的样本数量。

当我们探讨一些比较明显的对比案例,也就是两位候选人在平均评分上的差距超过了一定的标准时,我们发现无论在高度一致或者低度一致的情况下,人类评价者和由 LLM 模拟的观众之间的一致性都更加显著(详情请见表格 11)。我们采用了在第 5.2 节提出的百分比一致性方法来进行计算。对于那些一开始就展现出高度一致性(大于 0.6)的场景,如飞机坠毁、产品发布、讨价还价(非传统方式)、咖啡师、分享秘密、婚姻争论等,我们发现随着我们提升一致性的标准,人类和模拟观众之间的一致性也随之提高。其中五个场景的一致性甚至达到了 0.8,并且样本量适中。而对于那些一开始一致性较低(小于 0.6)的三个场景,我们却发现随着标准的提高,一致性却呈现出下降的趋势,这说明在这些情况下,人类评价者和模拟观众的判断存在着根本性的分歧。

A.9SHP 实验探索

按照 SHP 数据集的原创作者所采取的步骤 55,我们首先筛选数据集,确保所有成对的评论中,一方的赞同票数至少是另一方的 3 倍。这么做是为了剔除数据集中的杂音,确保其中一条评论明显更受欢迎。除此之外,我们还随机安排了评论的顺序,让任一评论成为第一条或第二条的可能性都是 50%,以此来消除潜在的位置偏见。在生成回答时,我们设置了超参数 top_p=0.9 和 temperature=0.1。

表 12:在链式思考(CoT)设定中使用的提示。

| 用户: |

| 评论 1: |

| <Comment 1> |

| 评论 2: |

| <Comment 2> |

| 帖子: |

| <Post> |

| 针对帖子内容,请选择你更倾向于点赞的评论。 |

| 请你仔细思考并逐步解释你的判断依据,给出最终答案后即可停止。 |

| 请你按照以下格式作答: |

| 理由:[你的判断依据] |

| 回答:评论 [1 或 2] |

| 结束 |

表 13:在 Reddit 用户 模拟 - 问烹饪领域默认设置中使用的提示。

| 系统: |

| 你对一切与烹饪有关的内容都很感兴趣。 |

| 你正在 reddit 的烹饪论坛上浏览,希望找到一些有趣的文章。 |

| 在阅读帖子评论时,你点击了一个帖子。 |

| 用户: |

| 评论 1: |

| <Comment 1> |

| 评论 2: |

| <Comment 2> |

| 帖子: |

| <Post> |

| 根据帖子的内容,选择你更可能会点赞的评论。 |

| 请你仔细思考,并逐步解释你的判断过程。在给出最终答案后你可以停止。 |

| 请你按照以下格式作答: |

| 理由:[你的判断依据] |

| 回答:评论 [1 或 2] |

| 结束 |

表 13:在 Reddit 用户 模拟 - 默认设置中,用于 askculinary 领域的提示。

| 系统: |

| 你对所有与烹饪相关的内容兴趣浓厚。 |

| 你正在 reddit 的烹饪论坛上寻找有趣且能带来娱乐的内容。 |

| 对于那些幽默风趣,能够让你开怀大笑的评论,你更愿意给予点赞。 |

| 在阅读帖子评论时,你点击了一个帖子。 |

| 用户: |

| 评论 1: |

| <Comment 1> |

| 评论 2: |

| <Comment 2> |

| 帖子: |

| <Post> |

| 根据帖子的内容,选择你更可能会点赞的评论。 |

| 请你仔细思考,并逐步解释你的判断过程。在给出最终答案后你可以停止。 |

| 请你按照以下格式作答: |

| 理由:[你的判断依据] |

| 回答:评论 [1 或 2] |

| 结束 |

表 14:Reddit 用户模拟 - askculinary 领域搞笑设定下的提示示例。

| 帖子: |

| 在搭建裹粉站的时候,到底是应该给面粉调味还是给面包糠调味呢?比如说在你准备裹鸡肉或者猪肉这些蛋白质食物的时候,你会选择给哪个调味呢?我自己一直都是只给面粉调味,但是我很想知道其他人的做法。 |

| 评论 1(42 个赞): |

| 我一开始百分之百把这个读成了“繁殖站”。看了一眼这个版块的名字,心想这帮人都怎么了。然后重新看了一下标题,发现问题其实是我们中有些人的阅读能力出了问题。说回你的问题,我两者都会调味,不过通常都是比较淡的味道。 |

| 评论 2(9 个赞): |

| 我所有的步骤都会加调味品。 |

| 思维链输出 |

| 原因:评论 2 更加贴切,直接回答了帖子里的问题,并且明确表达了对于如何在裹粉站加调味的看法。评论 1 虽然富有幽默感,但并没有清晰地表达观点,更多的是在谈论一个阅读上的错误。 |

| 答案:评论 2 |

| Reddit 用户模拟 - 默认输出 |

| 原因:评论 1 在回答问题之前分享了一个幽默的小故事,虽然很有趣,但直到最后才真正回到问题上来。而评论 2 则是直截了当地回答了问题,对于这个话题有着清晰的立场。作为一个对烹饪感兴趣的人,我更喜欢直接且相关的回答。 |

| 答案:评论 2 |

| Reddit 用户模拟 - 搞笑输出 |

| 原因:评论 1 更可能获得赞,因为其中包含了一个有关误解帖子标题的幽默小故事,这给讨论增添了趣味性。虽然两个评论都给出了问题的答案,但评论 1 用一种更引人入胜且更有可能让人发笑的方式做到了这一点。 |

| 答案:评论 1 |

表 15:askculinary 领域中三种不同设定下输出结果的示例。

| 文章: |

| 为什么美国的娱乐和文化产业这么发达呢?我来自挪威,一个并不算大的国家,我在想我的娱乐内容大多来自哪里。我说的是一门并不常见的语言,所以当我上网或是欣赏其他娱乐内容时,我通常会使用或听另一种语言。我想,大多数不说英语的人可能也会这样做。但我发现,我的大部分娱乐内容似乎都来自美国,这让我觉得有些奇怪,因为从国家的面积来看,美国并不算大。欧洲的人口是美国的两倍还多,那按这个逻辑,我的娱乐内容中,不是应该有 2/3 是来自欧洲吗?从全球范围来看,美国大约只占了 5% 的人口,但在大多数媒体领域里,它的影响力却远超这个比例…… |

| 评论 1 (5 个赞): |

| 我来自俄罗斯,对这个问题也感到困惑。以电视为例,比如 2014 年,我基本不在这里看电视,因为这里的节目几乎都不怎么样,但我会定期下载《绝命毒师》、《国土安全》等优秀的美剧……我真的不懂,他们是怎么做到比我们这里的节目好这么多的。 |

| 评论 2 (16 个赞): |

| 首先,劳动分工受到市场规模的限制。英语覆盖了比其他任何语言都要多的富裕人群,这就意味着英语市场内的专业化程度可以远超其他语言市场。其次,集聚效应和规模经济也起到了作用。某些类型的艺术创作在一个地方集中进行,会比分散在不同地方进行更有利。显然,如果我想制作一部电影,成本最低的地方肯定是好莱坞,因为那里有大量专门从事电影制作的人才和设备。规模经济则是指,在一定生产范围内,平均成本随着生产量的增加而减小。 |

| 链式思考输出 |

| 原因:评论 2 从多个角度详细回答了文章提出的问题,运用了经济学原理,对美国为何在娱乐和文化产业中占据主导地位做出了全面的解释,并通过具体例子进行了阐述。相比之下,评论 1 更多地表达了个人观点,并没有提供全面的答案。 |

| 回答:评论 2 |

| Reddit 用户 模拟 - 默认输出 |

| 原因:评论 2 对原帖问题提供了一个全面且深刻的解答,运用了劳动分工、集聚效应和规模经济等经济学概念,并通过实际例子进行了解释,使得内容更加易于理解。而评论 1 则更多地是一种个人经历分享,没有很好地解答原帖的问题。 |

| 回答:评论 2 |

| Reddit 用户 模拟 - 幽默输出 |

| 原因:虽然两个评论都从不同角度对这个问题进行了探讨,但评论 2 提供了更为详细和全面的解释。然而,基于我对幽默和娱乐的喜好,我更倾向于点赞评论 1。 这段评论以幽默风趣的方式,将评论者自己国家的电视节目与美国的节目进行了对比,让人感到更加亲切和有趣。 |

| 答案:评论 1 |

表 16:展示了在 asksocialscience 领域内,三种不同设置下输出结果的示例。

A.10 汇总各方意见

在这一部分,我们初步探讨了汇总各方意见的不同方法。在我们的场景中,可能会有多个由大语言模型(LLM)生成的相关方,以及 LLM 分配给每个相关方的权重。但是,简单地通过加权求和并不一定是将各方意见汇总在一起的最佳方法。比如说,如果所有相关方的意见都对最终的目标有重大影响,那么我们可能会采取一种策略,尽量提高所有相关方中得分最低者的满意度。相反,如果只需要获得其中一个相关方的认可就能达到目标,那么我们可能会选择另一种策略,尽量提高所有相关方中得分最高者的满意度。

在认知科学的文献中,Gates 等人在 2020 年的一项研究中指出,当人们试图同时帮助多个人时,他们的行为最能用 maximin 指标来描述,即尽量提高处境最差者的幸福度,同时在较小程度上也追求集体效用最大化(maxsum)和平等(减少不平等)。

在我们涉及多个相关方的三个场景中 —— 产品发布、飞机坠毁和约会应用 —— 我们发现这些评价标准在绝大多数情况下是一致的,只在两个关于最佳建议的情况和一个关于最佳候选人的情况下存在分歧。值得注意的是,在飞机坠毁的情景中,maximin 指标的表现较差,它选择的是第 17 位而不是第 1 位候选人,以及第 3 位而不是第 2 位的建议。未来,我们还需要进一步探究,在 LLM 比较的基础上,哪一种汇总方法最为合理。