FireAct:推进语言智能体的微调 [译]

Baian Chen,

Chang Shu,

Ehsan Shareghi,

Nigel Collier,

Karthik Narasimhan,

Shunyu Yao

剑桥大学、莫纳什大学和普林斯顿大学共同研究。代码、数据和模型可以在 https://fireact-agent.github.io 查看。

摘要

近期研究将语言模型与外部工具或环境结合起来,发展出能够进行推理和行动的“语言智能体”。尽管如此,大多数这类智能体仍依赖少量样本的提示技巧和现成的大语言模型。

在这篇文章中,我们研究并强调了一个被忽略的方向:通过微调大语言模型来创建更高效的语言智能体。通过结合谷歌搜索 API 的问答系统,我们测试了多种基础的大语言模型、提示方法、微调数据集和问答任务。结果表明,通过对这些模型进行微调,语言智能体的表现显著提升。例如,使用 GPT-4 生成的 500 个智能体操作轨迹来微调 Llama2-7B 模型,使其在 HotpotQA 任务上的表现提高了 77%。

此外,我们提出了一个名为 FireAct 的新方法,通过使用来自多种任务和提示方式的操作轨迹来微调语言模型,实验表明这种多样化的微调数据可以进一步提升智能体的性能。我们的研究不仅展示了微调大语言模型在构建智能体时的广泛优势,还提供了一系列实验设计、见解和有关如何微调语言智能体的开放性问题。

1 引言

近期的研究开始探索如何使语言模型(LMs,参见 Brown 等人,2020 年的研究;Chowdhery 等人,2022 年的研究;Touvron 等人,2023 年的研究)与外部工具或环境进行互动。

这一探索催生了一种新型的语言智能体(如 Nakano 等人在 2021 年、Yao 等人在 2022 年以及 Park 等人在 2023 年的研究所示),它们能够从环境反馈中学习新知识、通过语言推理做出序列决策,并利用自我反思来提升解决问题的能力(详见 Shinn 等人 2023 年的研究和 Wang 等人 2023 年的研究)。不仅在学术研究领域,在工业界也有显著进展,比如 OpenAI 在 2023 年开发的 ChatGPT 插件,展示了语言智能体在现实世界应用中的巨大潜力。

目前,大多数语言智能体为了便利和灵活性,通常会使用现成的语言模型(LMs)。但现有的 LMs 本身并不是为了作为智能体(例如执行动作或进行自我评估)而设计的。在这些特定场景下,仅仅依靠少样本(few-shot)的提示提供的学习支持是有限的。因此,当被用于智能体时,大多数 LMs 的表现并不理想,既缺乏性能上的优势,也缺乏稳健性。一些更高级的智能体(例如 Yao 等人 2023 年和 Wang 等人 2023 年的研究)甚至只能依赖于 GPT-4(由 OpenAI 在 2023 年开发)来支持,这不仅增加了成本和延迟,还引入了控制性和可重复性等问题。

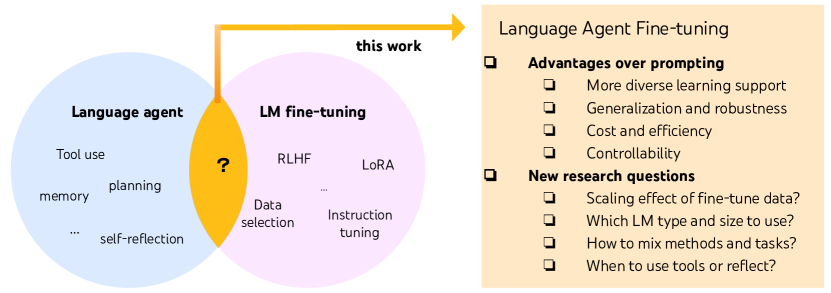

微调是解决这些挑战的理想方法:研究显示,相较于只依靠提示的大型大语言模型 (LLMs),经过微调的小型大语言模型在特定的推理 (Zelikman et al., 2022; Huang et al., 2022a) 和实践应用 (Yao et al., 2022b) 中表现更佳,同时还能节省推理时间和成本。然而,尽管有大量围绕语言智能体和大语言模型微调的研究(见图 1),但针对智能体的大语言模型微调研究相对较少。目前,仅有少数研究团队对大语言模型进行了针对网页导航(Nakano et al., 2021; Yao et al., 2022a)和 API 工具使用(Schick et al., 2023; Patil et al., 2023; Qin et al., 2023)的微调,并对特定类型的模型进行了初步的规模分析(Yao et al., 2022b; Schick et al., 2023; Nakano et al., 2021)。

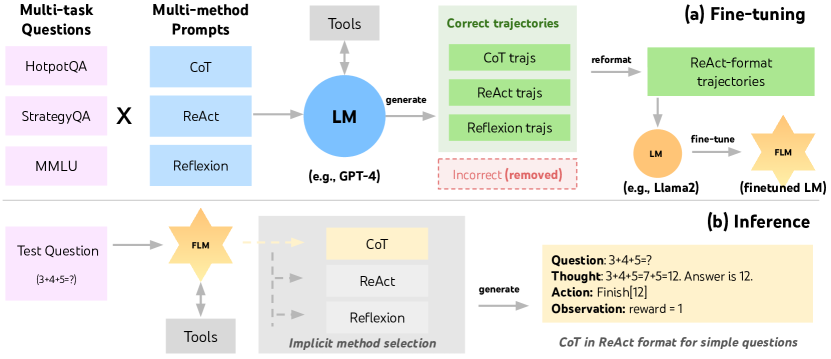

在本研究中,我们开始了对语言智能体微调更系统化研究的初步探索。我们提出了一种新的微调方法 FireAct,它通过结合多种任务和提示方法生成的智能体行为轨迹来微调大语言模型(LMs),并采用 ReAct 格式(Yao et al., 2022b)进行统一(见图 2)。我们利用开放领域问答任务、Google 搜索 API 和 GPT-4(OpenAI, 2023b)实施了 FireAct,用以生成微调数据。通过深入研究不同的基础大语言模型(OpenAI, 2023a; Touvron et al., 2023a; Rozière et al., 2023)、提示方法(Yao et al., 2022b; Wei et al., 2022b; Shinn et al., 2023)、微调数据和任务(Yang et al., 2018; Press et al., 2022; Hendrycks et al., 2021; Geva et al., 2021),我们的实验表明,微调不仅能显著提升模型性能,还突显了数据多样性在微调过程中的重要性。例如,使用少样本 ReAct 提示的 GPT-3.5 在 HotpotQA 任务中的精确匹配得分为 31.4,而用 500 条 ReAct 轨迹进行微调后,得分提升至 39.2(增长 25%),进一步混合使用 ReAct 和 CoT 轨迹的微调则将得分提高至 41.0(增长 31%)。此外,微调还大幅减少了模型的推理时间(减少了 4 倍),并且在处理分散注意力的工具输出时,性能提高了 64%。

对于小型的开源大语言模型 (LLMs),微调带来的好处尤为显著。例如,对 Llama2-7B 进行微调 (Touvron et al., 2023a),可以让它在 HotpotQA 测试中的精确度提升高达 77%。

我们的实验不仅揭示了微调的这些益处,还深入探讨了微调过程中多个因素的复杂互动,为从业者提供了实用的见解。在基础大语言模型方面,我们发现 GPT-3.5 使用不超过 500 个样本进行微调时,其效果显著优于其他开源大语言模型。但随着微调样本数量的增加,其他模型逐渐缩小了这一差距。在用于生成微调数据的提示方法方面,我们发现不同大语言模型适合不同的混合比例,并通过轨迹统计和效果预测分析加深了我们的理解。至于用于生成微调数据的任务,我们初步发现,增加一个任务可能不会显著提升在不同类型任务上的表现,但也不会影响性能。这意味着,通过大规模多任务微调,我们或许能够开发出适用于各种应用场景的单一大语言模型智能体。随着 FireAct 代码、数据和模型检查点的发布,以及其他一系列发现和讨论,我们期望本项工作能激发未来更多关于强大且实用的微调语言智能体的研究。

图 1: 尽管语言智能体和大语言模型微调都是当前的热门话题,但二者的交集尚未得到充分研究。本研究是一个初步尝试,向我们展示了对大语言模型进行微调在智能体应用方面的多种优势,并对语言智能体微调领域提出了多个新的研究问题。

2 相关工作

语言智能体。语言智能体(Weng, 2023; Wang et al., 2023b) 是一种使用语言模型(Language Models, LMs)与世界互动的先进 AI 系统。最初的语言智能体仅利用语言模型产生动作指令(Nakano et al., 2021; Huang et al., 2022b; Ahn et al., 2022; Schick et al., 2023),但在复杂领域或长期活动中,通过观察少量样例学习行动指令是一大挑战。ReAct 项目(Yao et al., 2022b)提出了一种创新方法,即利用语言模型同时生成推理过程和动作指令,这样的推理过程有助于灵活地指导和调整行动,这种方法比单纯依赖动作指令有了显著的提升。后续的研究工作也在智能体设计中引入了基于语言模型的推理,用于不同的目的,如自我反思(Shinn et al., 2023; Park et al., 2023)、规划(Yao et al., 2023; Dagan et al., 2023; Liu et al., 2023a)和程序编写(Liang et al., 2023; Wang et al., 2023a)等。

外部基础的形式已经变得多样化,包括数字游戏(Huang et al., 2022b; Wang et al., 2023a)、APIs(即“工具”;Schick et al., 2023; Patil et al., 2023; Qin et al., 2023)、网页(Yao et al., 2022a; Deng et al., 2023; Zhou et al., 2023b)、物理交互(Bharadhwaj et al., 2023; Vemprala et al., 2023; Driess et al., 2023)、人类互动(Zhang et al., 2020)和多代理互动(Park et al., 2023)。我们建议读者阅读 Xi et al. (2023) 关于实证调查的文章,以及 Sumers et al. (2023) 关于语言智能体的系统理论框架的研究。特别值得一提的是,大多数现有的语言智能体是基于现成的大语言模型(Large Language Models, LLMs)。

大语言模型 (LLM) 微调 (fine-tuning) 的研究。将预训练的大语言模型适用于下游任务是当前研究的热点之一 (Zhang et al., 2023b)。这包括多种基于指令的微调数据集 (Mishra et al., 2022; Sanh et al., 2022; Köpf et al., 2023; Wang et al., 2023d; Honovich et al., 2023; Longpre et al., 2023),多种模型 (Taori et al., 2023; Chiang et al., 2023; Xu et al., 2023; Muennighoff et al., 2023; Ouyang et al., 2022),参数高效的微调方法 (parameter-efficient fine-tuning methods) (Hu et al., 2022; Ding et al., 2023; Lv et al., 2023; Dettmers et al., 2023; Ivison et al., 2023),以及数据选择原则 (Zhou et al., 2023a; Gunasekar et al., 2023)。

除此之外,还有许多研究在探讨如何优化特定类型的大语言模型(LLM)的性能,例如编码用的大语言模型(Li et al., 2023; Luo et al., 2023; Rozière et al., 2023),能处理多种媒体形式的大语言模型(Zhang et al., 2023c; Gong et al., 2023; Dai et al., 2023; Zhang et al., 2023a; Brooks et al., 2023; Su et al., 2023),以及能结合网络信息搜索的大语言模型(Guu et al., 2020; Wang et al., 2023c)。但是,针对那些能够进行推理和实际操作的语言智能体(AI 智能体)进行大语言模型的性能优化,目前的研究还相对较少。

关于语言智能体的性能优化,虽然对此领域有很高的兴趣,但是在实际应用中的关注度却不高。目前的研究主要集中在几个方面:探讨特定类型的模型在扩大规模时性能如何变化(Nakano et al., 2021; Schick et al., 2023; Yao et al., 2022b),如何通过网络信息搜索来丰富模型功能(Patil et al., 2023; Qin et al., 2023),以及针对特定任务的详细研究(Yao et al., 2022a; Le et al., 2022)。本文则进行了更为系统的研究,提出并探讨了一系列关于提升语言智能体性能的新问题。

3FireAct: 通过多样化的 ReAct 轨迹来微调大语言模型(Large Language Model,LM)

图 2: FireAct 示意图。(a) 在微调(fine-tuning)阶段,大语言模型(例如 GPT-4)根据来自不同数据集的问题和多种方法的提示,生成解决任务的各种路径。然后,这些有效的路径被转化为 ReAct 格式,用以训练规模更小的语言模型。 (b) 在推理阶段,这些经过微调的模型能够不依赖少样本提示就进行操作,并能根据不同问题的复杂度,灵活选择合适的提示方法来完成 ReAct 轨迹。举个例子,对于一个简单的问题,可能只需一轮“思考 - 行动 - 观察”即可解决,无需借助任何工具。

我们的研究大量依赖于 ReAct(由 Yao 等人于 2022b 提出),这是一种广受欢迎的语言智能体技术。ReAct 的任务解决路径(如图 5 所示)包括多个“思考 - 行动 - 观察”循环。在这些循环中,语言模型会生成形式自由的“思考”,以实现各种目的(比如从观察中提取信息、制定和调整行动计划、追踪任务进展),并通过结构化的“行动”与环境(即工具)互动,从而获取“观察”反馈。ReAct 在单纯依赖推理或行动的基准测试中表现出色,因为推理可以指导行动,而行动又能通过新信息来促进推理。因此,ReAct 格式已成为众多后续语言智能体研究的基础,例如 Reflexion(由 Shinn 等人于 2023 提出)、SwiftSage(由 Lin 等人于 2023 提出)和 AutoGPT(由 Richards 于 2023 提出)。

Yao 团队在 2022b 中展示了一项初步的 PaLM(Chowdhery et al., 2022)在 HotpotQA(Yang et al., 2018)上的微调实验。在这个实验中,经过专门调整的 PaLM-62B 大语言模型的性能超过了直接使用预设提示的 PaLM-540B 大模型。但目前尚不清楚这一发现是否适用于其他类型的大语言模型、不同的提示方法或任务。对于语言智能体微调方面的后续研究还相当有限(详见第 2 节)。

鉴于此,我们提出了 FireAct,这是一种创新的针对语言智能体的微调方法。正如图 2(a) 所示,FireAct 利用少量样本提示(few-shot prompting)强大的大语言模型,生成多样化的 ReAct 行为轨迹,进而对较小的大语言模型进行精炼(即,知识蒸馏(Hinton et al., 2015))。但与 Yao 团队的工作 (2022b) 不同,FireAct 通过结合多种训练任务和提示方式,显著提高了数据的多样性。在此,我们考虑了两种与 ReAct 格式兼容的方法:

-

思考链 (Chain of Thought, CoT)(Wei et al., 2022b)通过生成中间推理步骤,帮助缩小问题与答案之间的差距。每条 CoT 推理路径都可转换为一个简单的单轮 ReAct 轨迹,其中包括作为中间推理的“思考”和提供答案的“行动”。CoT 特别适用于无需额外工具辅助的简单问题(参见图 2(b))。

-

反思 (Reflexion)(Shinn et al., 2023)则在大致遵循 ReAct 轨迹的基础上,加入了额外的反馈和自我思考环节。在本研究中,我们仅在 ReAct 的第 6 轮和第 10 轮引入反思环节,以便在长期的 ReAct 实验过程中调整解决问题的策略,例如:“目前为止,电影搜索还没有带来帮助,我应该转而搜索导演信息。”

在推理过程中 (图 2(b)),FireAct AI 智能体能够减少对少样本 (few-shot) 提示的依赖,从而使推理过程更加高效和便捷。此外,它能够根据任务的复杂程度隐性地选择最合适的方法,并由于其更广泛、更多元的学习支撑,相较于传统提示方法,表现出更强的泛化和鲁棒性。

4 实验设置

任务。根据 Wei et al. (2022b), Yao et al. (2022b), Shinn et al. (2023) 的先前工作,我们选取了几个公认且数据丰富、质量高的问答(QA)任务进行训练和测试,这些任务便于进行准确评估(答案完全匹配)。我们使用了以下四个数据集:

-

HotpotQA (Yang et al., 2018) 是一个挑战性强的 QA 数据集,需要进行多步推理和知识检索。答案通常是简短的实体或“是/否”。我们用 2,000 个随机选择的训练问题来进行微调数据的策划,并用 500 个随机选择的开发问题来进行评估。

-

Bamboogle (Press et al., 2022) 包含 125 个多步骤问答测试题,其格式类似于 HotpotQA,但设计得更巧妙,避免了直接通过 Google 搜索得到答案。

-

StrategyQA (Geva et al., 2021) 是一个需要隐式推理步骤的“是/否”类型的 QA 数据集。

-

MMLU (Hendrycks et al., 2021) 涵盖了 57 个不同领域的多项选择问答任务,如基础数学、历史和计算机科学。

工具。根据 Press et al. (2022) 的方法,我们使用了 SerpAPI1 来构建一个 Google 搜索工具。该工具能够返回“答案框”、“答案片段”、“突出词汇”或“首个结果片段”中的首个可用内容,确保答案简洁且相关。我们发现这样的工具能够有效满足各类 QA 任务的基本需求,并增强了我们微调后模型的易用性和适用性。

LMs。我们研究了三大类大语言模型(LLM):

-

OpenAI GPT。我们用 GPT-4 (OpenAI, 2023b) 来生成所有微调数据,并使用 GPT-3.5 (OpenAI, 2023a) 进行微调和提示生成。我们在 2023 年 7 月至 9 月期间通过 ChatCompletion 模式使用了这两个模型。

-

Llama-2 (Touvron et al., 2023b) 在“聊天”模式下具有 7B 和 13B 的参数规模。

-

CodeLlama(Rozière et al., 2023)拥有 7B、13B 和 34B 参数规模的“指令”模式,帮助我们更深入地理解模型规模扩大和代码微调在 AI 智能体任务中的重要性。

微调方法。我们在大部分微调实验中采用了低秩适应(LoRA,Hu et al., 2022)技术,但在某些对比实验中也采用了全模型微调。

考虑到语言 AI 智能体微调背后的各种因素,我们将实验分为三个逐步增加复杂性的部分:

-

在单一任务上应用单一提示方法进行微调(第 5 节);

-

在单一任务上应用多种方法进行微调(第 6 节);

-

在多个任务上应用多种方法进行微调(第 7 节)。

5 单任务,单方法微调

在本节中,我们专注于使用来自单一任务(HotpotQA)的数据和单一提示方法(ReAct)进行微调。通过这种简单而且受控的方式,我们证实了相对于传统提示方法,微调在性能、效率、鲁棒性和泛化能力方面的诸多优势,并探究了不同大语言模型、数据规模和微调方法的影响。默认情况下,我们利用 GPT-4 生成的 500 个成功的少样本(few-shot)提示轨迹进行训练,并选用 HotpotQA 开发集中的随机 500 个问题进行评估。其他实验细节见附录 B。

5.1 性能与效率

| 提示方法 | 精确匹配 (EM) | |

|---|---|---|

| GPT-4 | 输入输出 (IO) | 37.2 |

| 链式推理 (CoT) | 45.0 | |

| 反应式 (ReAct) | 42.0 | |

| GPT-3.5 | 输入输出 (IO) | 22.4 |

| 链式推理 (CoT) | 28.0 | |

| 反应式 (ReAct) | 31.4 |

表 1: 模型提示性能结果。

| 反应式 (ReAct) | 火焰反应 (FireAct) | 绝对/相对 差值 | |

|---|---|---|---|

| Llama-2-7B | 14.8 | 26.2 | +11.4 / 77% |

| Llama-2-13B | 21.2 | 34.4 | +13.1 / 62% |

| CodeLlama-7B | 17.4 | 27.8 | +10.4 / 60% |

| CodeLlama-13B | 20.8 | 29.0 | +8.2 / 39% |

| CodeLlama-34B | 22.2 | 27.8 | +5.6 / 25% |

| GPT-3.5 | 31.4 | 39.2 | +7.8 / 25% |

表 2: 模型使用提示方法与微调方法的性能比较,显示绝对值和相对值的增长。

微调显著提高了 AI 智能体的性能。如表 2 所示,微调不仅能显著提升 HotpotQA EM 的效果,还能使性能稳定提高。例如,相对性能较弱的 Llama-2-7B 通过微调可以提升高达 77%,而即便是性能更强的 GPT-3.5,微调也能使其性能提升 25%,这充分显示了从更多数据中学习的价值。在与表 2 中的强效引导方法(包括输入 - 输出引导 IO、思维链 CoT 和 ReAct)相比较时,我们发现,微调后的 Llama-2-13B 甚至能超越所有 GPT-3.5 的引导方法。这表明,通过微调小型开源大语言模型,可以取得超过商业大模型引导方法的成效。最终,微调后的 GPT-3.5 在所有微调大模型中表现最佳,甚至能超越 GPT-4 加 IO 引导,但在 GPT-4 加 CoT/ReAct 引导面前仍有提升空间。更多细节,如标准误差等,详见附录 A.1。

在 AI 智能体的推理过程中,微调的成本更低,速度更快。因为微调后的大模型不需要少样本的上下文示例,使得推理过程更加高效,尤其适用于需要不断累积上下文的智能体应用。例如,在表 3 的第一部分中,我们比较了微调和传统引导方式下 GPT-3.5 的推理成本,结果显示,微调可以将推理时间减少 70%,即每次试验从 9.0 秒减少到 2.7 秒,而且即使微调的费用更高(8 倍),推理成本总体上依然更低。尽管这些成本会因实现方式(如并行处理)的不同而有所变化,但微调减少上下文量的优势是显著的。

5.2 稳健性与泛化能力

面对嘈杂工具的稳健性。语言 AI 智能体所交互的工具或环境并非总是可靠,这引发了包括越狱(Liu et al., 2023b)和提示注入(Willison, 2023)在内的安全问题。在这里,我们考虑了一个简化且无害的情形:搜索 API 有 50% 的概率返回“无结果”或者一个随机的搜索回应(来自之前所有的实验和尝试),然后探究语言智能体在这种情况下是否仍能稳健地回答问题。正如表 3 的第二部分所示,返回“无结果”的设置较为具有挑战性,导致 ReAct 的精确匹配率下降了 33.8%,而 FireAct 只下降了 14.2%。有趣的是,随机的观察结果同样使 ReAct 的表现下降了 28.0%,但对 FireAct 的影响不大,仅下降了 5.1%。这可能是因为在微调过程(即优化模型以适应特定任务的过程)中,已经包含了许多嘈杂搜索查询的示例,以及 GPT-4 如何有效地应对这些噪音。这些初步的发现提示我们,为了提高稳健性,需要更加多样化的学习支持。关于稳健性的更多研究结果可以在附录 A.2 中找到。

探讨 GPT-3.5 在新任务上的泛化能力。表 3 3 展示了在 Bamboogle(Press 等人,2022)上,经过特定训练(微调)和使用预设提示(prompted)的 GPT-3.5 的 EM(精确匹配)结果。Bamboogle 是一个包含 125 个复杂的多步骤问题的测试集,这些问题被精心设计,使得仅通过 Google 搜索难以直接找到答案。在 HotpotQA 数据集上经过特定训练或使用预设提示的 GPT-3.5 均能在 Bamboogle 上表现出一定的泛化能力,但是特定训练的模型(44.0 EM)表现优于仅使用预设提示的模型(40.8 EM),这显示了特定训练在泛化方面的优势。同样,结合少量样本提示(few-shot prompts),在 HotpotQA 上进行特定训练能显著提高在 Bamboogle 上的表现,同时对 MMLU 略有提升,但相比于标准模型(vanilla models)在 StrategyQA 上有所下降(详见附录 A.9)。鉴于在 HotpotQA 上进行的特定训练难以适应 StrategyQA(是非题)或 MMLU(多项选择题)这两种风格和答案格式不同的其他 QA 数据集,我们因此在第 7 部分展开了多任务特定训练的实验。

表 3:针对特定训练与使用预设提示的 GPT-3.5,在成本、鲁棒性及泛化能力方面的对比。

| 每次尝试的成本 | 观测到的鲁棒性 (EM) | 泛化表现 | ||||

|---|---|---|---|---|---|---|

| 费用(美元) | 耗时(秒) | 常规 | 无干预 | 随机应变 | Bamboogle (EM) | |

| --- | --- | --- | --- | --- | --- | --- |

| FireAct | 0.0022 | 2.7 | 39.2 | 33.6 | 37.2 | 44.0 |

| ReAct | 0.0026 | 9.0 | 31.4 | 20.8 | 22.6 | 40.8 |

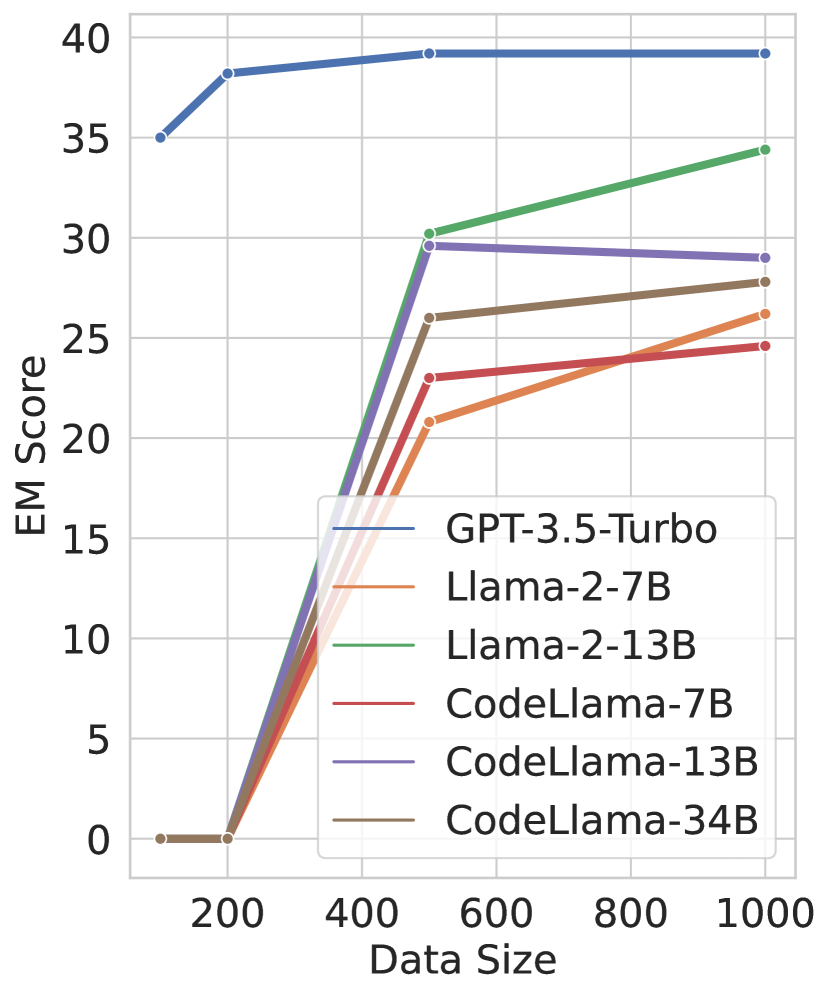

图 3:数据规模扩展示意图。

图 3:数据规模扩展示意图。

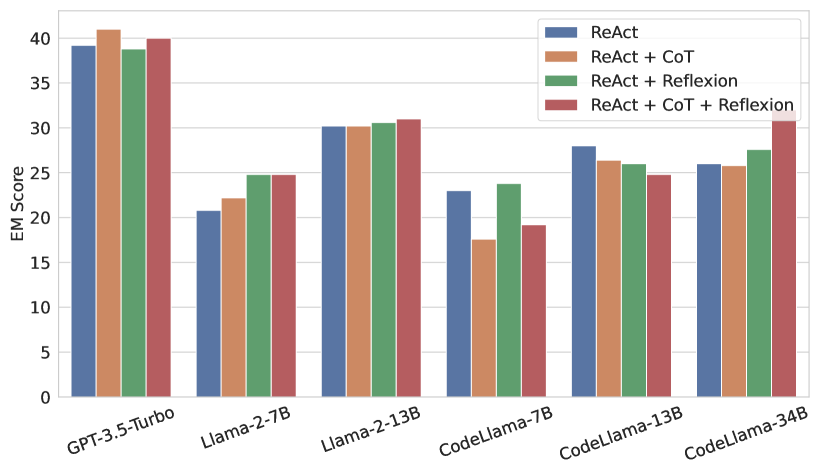

图 4:不同大语言模型和数据类型的结果对比。

5.3 各种微调因素分析

微调方法的影响(LoRA vs. 全模型)。在 Llama-2-7B 的案例中,我们发现全模型微调(准确率 30.2%)比 LoRA 微调(准确率 26.2%)提高了 15.3%(详见附录 A.5)。然而,LoRA 训练成本更低,它能在单个 RTX 4090(24GB GPU 内存)上每秒处理 5.4 个实例,相比之下,全模型微调要处理 19.7 个实例就需要四个 A100 GPU(每个 80GB 内存)。因此,在预算和时间有限的情况下,采用 LoRA 进行大多数实验,可以让我们探索更多的训练配置。

微调数据规模的影响。如图 4 所示,FireAct 的性能随着微调样本数量((n \in {100,200,500,1000}))的增加而提升。GPT-3.5 显示出极高的样本效率,只需 100 个样本就能达到约 35% 的准确率,而超过 200 个样本后性能提升较小。而对于 Llama 模型,使用 100 或 200 个样本时甚至无法学会 ReAct 格式,但当样本量增至 500 个时,就能获得显著的分数提升,大多数模型(除了 CodeLlama-13B)在 1000 个样本时还能进一步改善。这种数据规模趋势表明,小型开源语言模型在特定的代理任务上有潜力赶上更强大的模型,只要有足够的微调数据(例如,使用 1000 个样本微调的 Llama-2-13B 可以达到使用 100 个样本微调的 GPT-3.5 的水平)。

基础语言模型类型的影响。表 2 显示,在提示和微调方面,GPT-3.5 都优于所有基于 Llama 的模型。此外,CodeLlama-7B 表现优于 Llama-2-7B,但 CodeLlama-13B 的表现不如 Llama-2-13B,暗示编程相关的微调不一定总对代理用途有益。当使用默认的 CodeLlama 分词器而非 Llama 分词器时,CodeLlama 的表现略有提升(详见附录 A.6)。

大语言模型规模的影响显而易见。正如表 2 和图 4 中的蓝色条形所展示的,拥有 13B 参数的 (Code)Llama 模型总是比 7B 参数的表现更好。然而,当仅在 ReAct 轨迹上进行微调时,CodeLlama-34B 的表现似乎逊于 CodeLlama-13B。但是,正如第 6 节中将展示的(图 4 其余部分也有所暗示),其他因素,例如微调数据的类型,可能会改变这一结论,使得 CodeLlama-34B 超过 CodeLlama-13B。总的来说,多个因素,包括大语言模型的类型、规模、微调数据和方法,可能共同影响微调的结果。因此,在设计 AI 智能体时,应该综合考虑不同维度的扩展趋势和大语言模型/数据类型。

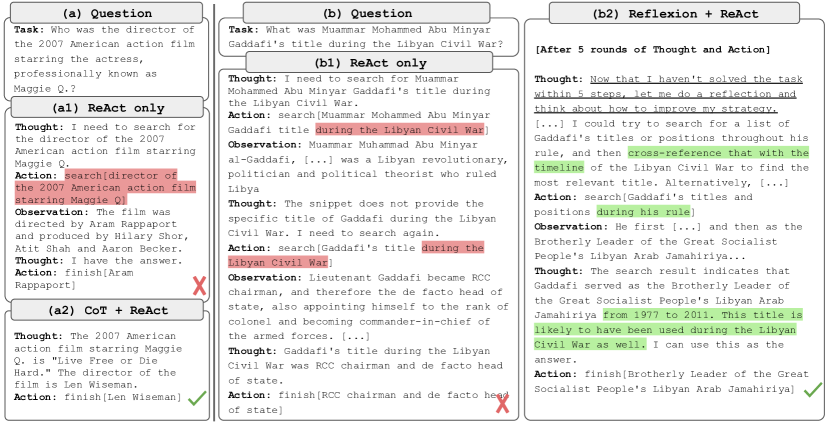

图 5: 对于问题 (a),(a1) 仅使用 ReAct 进行微调会导致干扰信息和错误答案,而 (a2) 结合 CoT 和 ReAct 微调则能找到一个简单的 CoT 解决方案。在问题 (b) 中,(b1) 仅使用 ReAct 微调导致多次失败的搜索,展现出相同的模式,而 (b2) 结合 Reflexion 和 ReAct 进行微调则成功改变了搜索策略。

6 综合多种方法的微调

我们将 CoT(Wei et al., 2022b)和 Reflexion(Shinn et al., 2023)与 ReAct 结合,针对 HotpotQA 实施了一种多种方法混合的微调策略。对于这两种方法,我们通过 GPT-4 生成了 500 条基于少量样本的引导轨迹,并使用了 47 条包含自我反思的长时间 Reflexion 轨迹,这些反思发生在经历了 6 或 10 轮 ReAct 之后。此外,还有 187 条成功的 CoT 轨迹,被重新格式化为单轮 ReAct 轨迹,加上已有的 500 条 ReAct 轨迹。更多细节见附录 B。

这种综合多种方法的微调提高了 AI 智能体的灵活性。在展示量化结果之前,我们在图 5 中呈现了两个示例问题和一些经过微调的 GPT-3.5 轨迹,以展示这种混合微调的优势。第一个问题 (a) 较简单,但仅经过 ReAct 微调的智能体 (a1) 进行了过于复杂的搜索,导致分心和错误答案。相比之下,同时经过 CoT 和 ReAct 微调的智能体选择在一轮内依赖于可靠的内部知识来解决问题。第二个问题 (b) 更具挑战性,仅经过 ReAct 微调的智能体 (b1) 不断搜索与“在利比亚内战期间”相关的查询,但未获得有用信息。而同时经过 Reflexion 和 ReAct 微调的智能体则对这一问题进行了反思,并调整搜索策略,将时间限制改为“在其统治期间”,成功找到了正确答案。这种针对不同问题灵活选择方法的能力是微调相比单纯提示的另一大优势。

表 4: HotpotQA 上的综合多方法微调结果。

表 5: 使用 GPT-3.5 进行的多任务微调结果。

| 提问方法 | 轮数 | ||

| EM | 均值 () | 标准差 () | |

| ReAct | 39.4 | 3.2 | 1.4 |

| ReAct + 对话树 (CoT) | 41.0 | 2.7 | 1.7 |

| ReAct + 反思 (Reflexion) | 38.8 | 3.8 | 2.8 |

| ReAct + 对话树 (CoT) + 反思 (Reflexion) | 40.0 | 3.0 | 4.8 |

| 随机方法选择 | 32.4 | - | - |

| 理想方法选择 | 52.0 | - | - |

| HotpotQA | StrategyQA | Bamboogle | MMLU | |

|---|---|---|---|---|

| 提问 | ||||

| IO | 22.4 | 48.0 | 7.2 | 68.6 |

| 对话树 (CoT) | 28.0 | 49.0 | 41.6 | 50.8 |

| ReAct | 31.4 | 61.0 | 40.8 | 58.6 |

| 微调 (Fine-tuning) | ||||

| HotpotQA | 39.2 | - | 44.0 | - |

| 多任务 (Multi-task) | 39.2 | 55.5 | 43.2 | 63.2 |

| + 对话树 (CoT) | 39.6 | 72.9 | 50.4 | 65.8 |

表 5: GPT-3.5 的多任务结果。

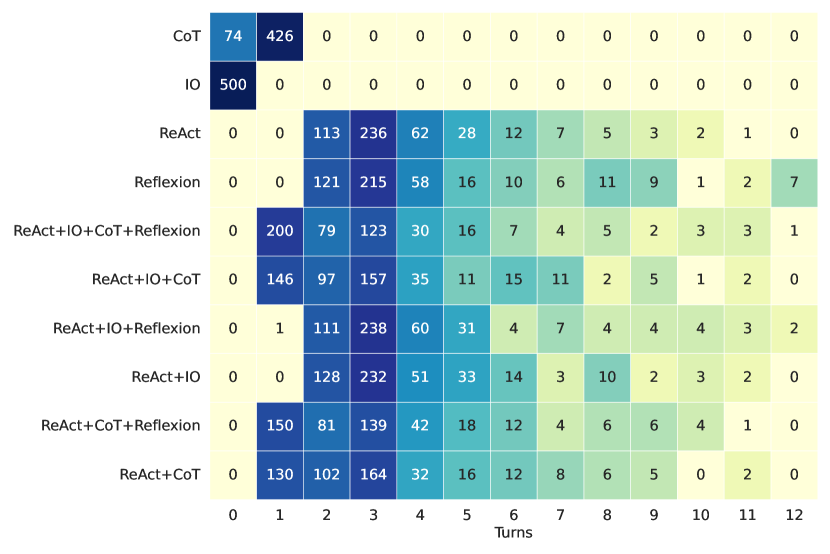

多种微调 (fine-tuning) 方法对不同的大语言模型 (LLMs) 有着不同的影响。图 4: 4 展示了一个直观结论:混合更多的微调方法并非总能提高性能,而且最优的方法组合还取决于所使用的基础大语言模型。例如,在 GPT-3.5 和 Llama-2 模型上,ReAct+CoT 的表现超过了单独使用 ReAct,但在 CodeLlama 模型上则适得其反。在 CodeLlama-7/13B 模型上,ReAct+CoT+Reflexion 组合的效果最差,而在 CodeLlama-34B 上却是最佳。这些复杂的结果指出了需要进一步研究基础大语言模型与微调数据相互作用的必要性。

那么,多方法的 AI 智能体 (AI Agents) 能否选择适宜的微调方法呢?表 5: 5 显示了基于 GPT-3.5 的不同 FireAct 智能体在 HotpotQA 测试中的表现,以及它们在不同轨迹中 ReAct 微调轮数的平均值(,即“均值”)和标准差()。与仅采用 ReAct 微调相比,ReAct+CoT 在提高准确率 (EM) 的同时缩短了解题轨迹,而 ReAct+Reflexion 则相反,降低了准确率并延长了轨迹。这表明两种方法组合使得方法选择朝着不同的方向发展,而 CoT 对于 HotpotQA 问题似乎更为有效。为了深入了解多方法智能体是否能选择合适的方法,我们还研究了在推理过程中随机选择方法的结果。其结果为 32.4,远低于所有多方法智能体,显示出方法选择的重要性。然而,如果每个案例都应用最佳方法,可以达到一个理想的“神谕”结果 52.0,这表明在提示方法选择上还有提升的空间。未来的研究可以探索更系统的网格搜索方法,或是研究轨迹统计数据与性能之间的关系,以确定更加合理的方法混合比例。

7. 多任务细化调整

迄今为止,我们只使用了 HotpotQA 数据来进行细化调整,但 Longpre et al. 2023 的实证研究显示,结合不同任务进行调整有其优势。我们使用了来自三个数据集的混合数据对 GPT-3.5 进行了这种调整:HotpotQA(500 个 ReAct 样本,277 个 CoT 样本)、StrategyQA(388 个 ReAct 样本,380 个 CoT 样本)以及 MMLU(456 个 ReAct 样本,469 个 CoT 样本)。这些样本是从利用 GPT-4 生成的成功的 ReAct/CoT 少样本提示轨迹中精心挑选的。

正如表 5 中所展示的,当我们将 StrategyQA 和 MMLU 数据并入多任务训练时(称之为“多任务”),HotpotQA 和 Bamboogle 的表现基本保持不变。一方面,StrategyQA 和 MMLU 的问题类型(例如 MMLU 的多选题)和工具使用策略(例如在 MMLU 中搜索答案选项的趋势)与原有任务截然不同,这使得技术迁移变得复杂。另一方面,尽管面临数据分布的变化,加入这两个数据集并未对 HotpotQA 和 Bamboogle 的效果产生负面影响,这表明了将一个多任务 AI 智能体细化调整以替换多个单任务智能体的潜力,而不必担心跨任务间的负面互动。

当我们从单方法的多任务细化调整转变为多方法的多任务细化调整时,所有任务的表现均有所提高,这再次证明了多方法细化调整的重要价值。有趣的是,所有经过细化调整的智能体(包括使用 CoT/ReAct 提示)在 MMLU 任务上的表现都不如简单的直接输入 - 输出提示。这可能是因为这些问题过于简单,不需要复杂的推理和操作,或者是因为答案选择的记忆效应。这促使我们需要开发更有效的提示方法和更优秀的智能体训练数据集。

8 讨论

何时应该对语言 AI 智能体进行微调 (fine-tune),何时使用提示 (prompt) 来指导它们?尽管目前大多数语言智能体都采用提示的方式,但我们的研究显示,由于微调可以利用更多样化的学习资源,因此在某些方面更有优势,这促使我们需要重新考虑这两种方法的最佳实践。简而言之,提示更适合于探索性的任务,而微调则更适合于具体的应用场景。在开发新的智能体或解决新问题时,直接使用现成的大语言模型进行提示操作,可以带来灵活性和便捷性。但是,如果下游任务已经明确(比如问答),并且可以通过诸如 GPT-4 这样的模型收集到足够的数据,那么微调不仅可以提升任务执行的效果,还能更好地适应新任务,更加稳健地应对嘈杂或对抗性环境,同时也能使推理过程更加经济高效。这些特点使得微调在大规模工业应用中显得尤为重要。

选择哪个大语言模型进行微调呢?在我们考虑的所有模型中,GPT-3.5 在不同场景下的表现始终优于其他基于 Llama 架构的模型。这一点并不意外,因为 GPT-3.5 拥有更大的模型规模,并且是在 GPT-3 的基础上继续训练得来的。它还具有更高的样本效率和合理的成本(在我们的实验中,每次微调大约需要 10 美元)。然而,我们的研究也表明,只要有足够的微调数据,以及恰当地结合不同的提示方法和任务,开源的 Llama 模型也能达到与 GPT-3.5 相似的效果。因此,从业者在选择使用 GPT-3.5 的便利性和高效性,还是选择开源大语言模型的可控性和可复制性时,需要做出权衡。

语言智能体何时该使用工具或反思自己的行为?以提示为基础的语言智能体仅能模仿一些固定且有限的成功解决问题的路径。这可能导致它们过度依赖工具(比如,查询大语言模型 (LLM) 中已经存在的信息),或者在解决问题的路径与预设的“成功模式”偏离时,难以找到新的解决方案(例如,反复搜索相似但无效的信息)。FireAct 通过多种方法的微调,增强了语言智能体的灵活性和鲁棒性。然而,如何准确判断何时寻求外部帮助(使用工具)和内部反思,这个问题仍然是个挑战。Ren et al. 2023 关于校准的研究和 Griffiths et al. 2019 关于元推理的工作,可能为设计更优秀的智能体提供了新的视角。

这项研究的局限性和未来方向。目前的工作是语言智能体微调方面的初步探索,只针对了单一类型的任务(问答 QA)和一个工具(谷歌搜索)。未来的研究可以将 FireAct 提出的问题应用到更多类型的任务和基础设施中(比如,更多的 API 工具、网络、物理世界的接口)。我们目前聚焦于三种方法(ReAct、CoT、Reflexion),这些方法都是基于单一的自回归轨迹上下文,这简化了微调过程。但如何对涉及多种提示、角色和上下文的更复杂的智能体进行微调(参见 Wang et al. 2023a;Park et al. 2023;Yao et al. 2023),或者如何在复杂的智能体系统中更好地结合提示和微调,还有待进一步研究。最后,本研究中的多任务设置限于三个 QA 任务,且最佳微调的大语言模型是 GPT-3.5。Wei et al. 2022a 提出的大规模多任务微调,使用最新的大语言模型,将对语言智能体微调的极限进行测试。但在此之前,我们需要先探索更合适、更多样化的基准来开发和评估智能体。

致谢

我们衷心感谢 Yuqian Sun 在图表制作上的帮助,感谢 SerpAPI 对部分 API 调用的资助,也要对 Tianyu Gao、Ofir Press、Noah Shinn、Alex Witegg、Eric Zelikman 和 Zexuan Zhong 在校对和宝贵反馈方面的贡献表示感激。SY 和 KN 感谢 Oracle Collaborative Research 奖项和国家科学基金会 (National Science Foundation) 在授予的编号为 2239363 的基金上的支持。SY 还获得了普林斯顿大学的 Harold W. Dodds 奖学金的支持。本文中表达的任何观点、发现、结论或建议均为作者个人观点,并不必然反映国家科学基金会的立场。我们还要特别感谢,联合第一作者 CS 的工作得到了 Toshiba Europe 的捐赠和英国皇家工程与物理科学研究委员会 (UKRI Engineering and Physical Sciences Research Council) (基金编号 2752931) 的共同支持。

References

- Ahn et al. (2022)Michael Ahn, Anthony Brohan, Noah Brown, Yevgen Chebotar, Omar Cortes, Byron David, Chelsea Finn, Chuyuan Fu, Keerthana Gopalakrishnan, Karol Hausman, et al.Do as I can, not as I say: Grounding language in robotic affordances.arXiv preprint arXiv:2204.01691, 2022.

- Bharadhwaj et al. (2023)Homanga Bharadhwaj, Jay Vakil, Mohit Sharma, Abhinav Gupta, Shubham Tulsiani, and Vikash Kumar.Roboagent: Generalization and efficiency in robot manipulation via semantic augmentations and action chunking.CoRR, abs/2309.01918, 2023.doi: 10.48550/arXiv.2309.01918.URL https://doi.org/10.48550/arXiv.2309.01918.

- Brooks et al. (2023)Tim Brooks, Aleksander Holynski, and Alexei A. Efros.Instructpix2pix: Learning to follow image editing instructions.In IEEE/CVF Conference on Computer Vision and Pattern Recognition, CVPR 2023, Vancouver, BC, Canada, June 17-24, 2023, pp. 18392–18402. IEEE, 2023.doi: 10.1109/CVPR52729.2023.01764.URL https://doi.org/10.1109/CVPR52729.2023.01764.

- Brown et al. (2020)Tom Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared D Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, et al.Language models are few-shot learners.Advances in Neural Information Processing Systems, 33:1877–1901, 2020.

- Chiang et al. (2023)Wei-Lin Chiang, Zhuohan Li, Zi Lin, Ying Sheng, Zhanghao Wu, Hao Zhang, Lianmin Zheng, Siyuan Zhuang, Yonghao Zhuang, Joseph E. Gonzalez, Ion Stoica, and Eric P. Xing.Vicuna: An open-source chatbot impressing gpt-4 with 90%* chatgpt quality, March 2023.URL https://lmsys.org/blog/2023-03-30-vicuna/.

- Chowdhery et al. (2022)Aakanksha Chowdhery, Sharan Narang, Jacob Devlin, Maarten Bosma, Gaurav Mishra, Adam Roberts, Paul Barham, Hyung Won Chung, Charles Sutton, Sebastian Gehrmann, et al.Palm: Scaling language modeling with pathways.arXiv preprint arXiv:2204.02311, 2022.

- Dagan et al. (2023)Gautier Dagan, Frank Keller, and Alex Lascarides.Dynamic planning with a llm.arXiv preprint arXiv:2308.06391, 2023.

- Dai et al. (2023)Wenliang Dai, Junnan Li, Dongxu Li, Anthony Meng Huat Tiong, Junqi Zhao, Weisheng Wang, Boyang Li, Pascale Fung, and Steven C. H. Hoi.Instructblip: Towards general-purpose vision-language models with instruction tuning.CoRR, abs/2305.06500, 2023.doi: 10.48550/arXiv.2305.06500.URL https://doi.org/10.48550/arXiv.2305.06500.

- Deng et al. (2023)Xiang Deng, Yu Gu, Boyuan Zheng, Shijie Chen, Samuel Stevens, Boshi Wang, Huan Sun, and Yu Su.Mind2Web: Towards a generalist agent for the web.arXiv preprint arXiv:2306.06070, 2023.

- Dettmers et al. (2023)Tim Dettmers, Artidoro Pagnoni, Ari Holtzman, and Luke Zettlemoyer.Qlora: Efficient finetuning of quantized llms.CoRR, abs/2305.14314, 2023.doi: 10.48550/arXiv.2305.14314.URL https://doi.org/10.48550/arXiv.2305.14314.

- Ding et al. (2023)Ning Ding, Yujia Qin, Guang Yang, Fuchao Wei, Zonghan Yang, Yusheng Su, Shengding Hu, Yulin Chen, Chi-Min Chan, Weize Chen, Jing Yi, Weilin Zhao, Xiaozhi Wang, Zhiyuan Liu, Hai-Tao Zheng, Jianfei Chen, Yang Liu, Jie Tang, Juanzi Li, and Maosong Sun.Parameter-efficient fine-tuning of large-scale pre-trained language models.Nat. Mac. Intell., 5(3):220–235, 2023.doi: 10.1038/s42256-023-00626-4.URL https://doi.org/10.1038/s42256-023-00626-4.

- Driess et al. (2023)Danny Driess, Fei Xia, Mehdi S. M. Sajjadi, Corey Lynch, Aakanksha Chowdhery, Brian Ichter, Ayzaan Wahid, Jonathan Tompson, Quan Vuong, Tianhe Yu, Wenlong Huang, Yevgen Chebotar, Pierre Sermanet, Daniel Duckworth, Sergey Levine, Vincent Vanhoucke, Karol Hausman, Marc Toussaint, Klaus Greff, Andy Zeng, Igor Mordatch, and Pete Florence.Palm-e: An embodied multimodal language model.In Andreas Krause, Emma Brunskill, Kyunghyun Cho, Barbara Engelhardt, Sivan Sabato, and Jonathan Scarlett (eds.), International Conference on Machine Learning, ICML 2023, 23-29 July 2023, Honolulu, Hawaii, USA, volume 202 of Proceedings of Machine Learning Research, pp. 8469–8488. PMLR, 2023.URL https://proceedings.mlr.press/v202/driess23a.html.

- Geva et al. (2021)Mor Geva, Daniel Khashabi, Elad Segal, Tushar Khot, Dan Roth, and Jonathan Berant.Did aristotle use a laptop? A question answering benchmark with implicit reasoning strategies.Trans. Assoc. Comput. Linguistics, 9:346–361, 2021.doi: 10.1162/tacl_a_00370.URL https://doi.org/10.1162/tacl_a_00370.

- Gong et al. (2023)Tao Gong, Chengqi Lyu, Shilong Zhang, Yudong Wang, Miao Zheng, Qian Zhao, Kuikun Liu, Wenwei Zhang, Ping Luo, and Kai Chen.Multimodal-gpt: A vision and language model for dialogue with humans.CoRR, abs/2305.04790, 2023.doi: 10.48550/arXiv.2305.04790.URL https://doi.org/10.48550/arXiv.2305.04790.

- Griffiths et al. (2019)Thomas L Griffiths, Frederick Callaway, Michael B Chang, Erin Grant, Paul M Krueger, and Falk Lieder.Doing more with less: meta-reasoning and meta-learning in humans and machines.Current Opinion in Behavioral Sciences, 29:24–30, 2019.

- Gunasekar et al. (2023)Suriya Gunasekar, Yi Zhang, Jyoti Aneja, Caio César Teodoro Mendes, Allie Del Giorno, Sivakanth Gopi, Mojan Javaheripi, Piero Kauffmann, Gustavo de Rosa, Olli Saarikivi, Adil Salim, Shital Shah, Harkirat Singh Behl, Xin Wang, Sébastien Bubeck, Ronen Eldan, Adam Tauman Kalai, Yin Tat Lee, and Yuanzhi Li.Textbooks are all you need, 2023.

- Guu et al. (2020)Kelvin Guu, Kenton Lee, Zora Tung, Panupong Pasupat, and Ming-Wei Chang.Retrieval augmented language model pre-training.In Proceedings of the 37th International Conference on Machine Learning, ICML 2020, 13-18 July 2020, Virtual Event, volume 119 of Proceedings of Machine Learning Research, pp. 3929–3938. PMLR, 2020.URL http://proceedings.mlr.press/v119/guu20a.html.

- Hendrycks et al. (2021)Dan Hendrycks, Collin Burns, Steven Basart, Andy Zou, Mantas Mazeika, Dawn Song, and Jacob Steinhardt.Measuring massive multitask language understanding.In 9th International Conference on Learning Representations, ICLR 2021, Virtual Event, Austria, May 3-7, 2021. OpenReview.net, 2021.URL https://openreview.net/forum?id=d7KBjmI3GmQ.

- Hinton et al. (2015)Geoffrey Hinton, Oriol Vinyals, and Jeff Dean.Distilling the knowledge in a neural network.arXiv preprint arXiv:1503.02531, 2015.

- Honovich et al. (2023)Or Honovich, Thomas Scialom, Omer Levy, and Timo Schick.Unnatural instructions: Tuning language models with (almost) no human labor.In Anna Rogers, Jordan L. Boyd-Graber, and Naoaki Okazaki (eds.), Proceedings of the 61st Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), ACL 2023, Toronto, Canada, July 9-14, 2023, pp. 14409–14428. Association for Computational Linguistics, 2023.doi: 10.18653/v1/2023.acl-long.806.URL https://doi.org/10.18653/v1/2023.acl-long.806.

- Hu et al. (2022)Edward J. Hu, Yelong Shen, Phillip Wallis, Zeyuan Allen-Zhu, Yuanzhi Li, Shean Wang, Lu Wang, and Weizhu Chen.Lora: Low-rank adaptation of large language models.In The Tenth International Conference on Learning Representations, ICLR 2022, Virtual Event, April 25-29, 2022. OpenReview.net, 2022.URL https://openreview.net/forum?id=nZeVKeeFYf9.

- Huang et al. (2022a)Jiaxin Huang, Shixiang Shane Gu, Le Hou, Yuexin Wu, Xuezhi Wang, Hongkun Yu, and Jiawei Han.Large language models can self-improve.arXiv preprint arXiv:2210.11610, 2022a.

- Huang et al. (2022b)Wenlong Huang, Pieter Abbeel, Deepak Pathak, and Igor Mordatch.Language models as zero-shot planners: Extracting actionable knowledge for embodied agents.In International Conference on Machine Learning, pp. 9118–9147, 2022b.

- Ivison et al. (2023)Hamish Ivison, Akshita Bhagia, Yizhong Wang, Hannaneh Hajishirzi, and Matthew E. Peters.HINT: hypernetwork instruction tuning for efficient zero- and few-shot generalisation.In Anna Rogers, Jordan L. Boyd-Graber, and Naoaki Okazaki (eds.), Proceedings of the 61st Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), ACL 2023, Toronto, Canada, July 9-14, 2023, pp. 11272–11288. Association for Computational Linguistics, 2023.doi: 10.18653/v1/2023.acl-long.631.URL https://doi.org/10.18653/v1/2023.acl-long.631.

- Kojima et al. (2022)Takeshi Kojima, Shixiang Shane Gu, Machel Reid, Yutaka Matsuo, and Yusuke Iwasawa.Large language models are zero-shot reasoners.In NeurIPS, 2022.URL http://papers.nips.cc/paper_files/paper/2022/hash/8bb0d291acd4acf06ef112099c16f326-Abstract-Conference.html.

- Köpf et al. (2023)Andreas Köpf, Yannic Kilcher, Dimitri von Rütte, Sotiris Anagnostidis, Zhi-Rui Tam, Keith Stevens, Abdullah Barhoum, Nguyen Minh Duc, Oliver Stanley, Richárd Nagyfi, Shahul ES, Sameer Suri, David Glushkov, Arnav Dantuluri, Andrew Maguire, Christoph Schuhmann, Huu Nguyen, and Alexander Mattick.Openassistant conversations - democratizing large language model alignment.CoRR, abs/2304.07327, 2023.doi: 10.48550/arXiv.2304.07327.URL https://doi.org/10.48550/arXiv.2304.07327.

- Le et al. (2022)Hung Le, Yue Wang, Akhilesh Deepak Gotmare, Silvio Savarese, and Steven Chu Hong Hoi.Coderl: Mastering code generation through pretrained models and deep reinforcement learning.Advances in Neural Information Processing Systems, 35:21314–21328, 2022.

- Li et al. (2023)Raymond Li, Loubna Ben Allal, Yangtian Zi, Niklas Muennighoff, Denis Kocetkov, Chenghao Mou, Marc Marone, Christopher Akiki, Jia Li, Jenny Chim, Qian Liu, Evgenii Zheltonozhskii, Terry Yue Zhuo, Thomas Wang, Olivier Dehaene, Mishig Davaadorj, Joel Lamy-Poirier, João Monteiro, Oleh Shliazhko, Nicolas Gontier, Nicholas Meade, Armel Zebaze, Ming-Ho Yee, Logesh Kumar Umapathi, Jian Zhu, Benjamin Lipkin, Muhtasham Oblokulov, Zhiruo Wang, Rudra Murthy, Jason Stillerman, Siva Sankalp Patel, Dmitry Abulkhanov, Marco Zocca, Manan Dey, Zhihan Zhang, Nourhan Fahmy, Urvashi Bhattacharyya, W. Yu, Swayam Singh, Sasha Luccioni, Paulo Villegas, Maxim Kunakov, Fedor Zhdanov, Manuel Romero, Tony Lee, Nadav Timor, Jennifer Ding, Claire Schlesinger, Hailey Schoelkopf, Jana Ebert, Tri Dao, Mayank Mishra, Alexander Gu, Jennifer Robinson, Carolyn Jane Anderson, Brendan Dolan-Gavitt, Danish Contractor, Siva Reddy, Daniel Fried, Dzmitry Bahdanau, Yacine Jernite, Carlos Muñoz Ferrandis, Sean M. Hughes, Thomas Wolf, Arjun Guha, Leandro von Werra, and Harm de Vries.Starcoder: may the source be with you!ArXiv, abs/2305.06161, 2023.

- Liang et al. (2023)Jacky Liang, Wenlong Huang, Fei Xia, Peng Xu, Karol Hausman, Brian Ichter, Pete Florence, and Andy Zeng.Code as policies: Language model programs for embodied control.In 2023 IEEE International Conference on Robotics and Automation (ICRA), pp. 9493–9500, 2023.

- Lin et al. (2023)Bill Yuchen Lin, Yicheng Fu, Karina Yang, Prithviraj Ammanabrolu, Faeze Brahman, Shiyu Huang, Chandra Bhagavatula, Yejin Choi, and Xiang Ren.Swiftsage: A generative agent with fast and slow thinking for complex interactive tasks.arXiv preprint arXiv:2305.17390, 2023.

- Liu et al. (2023a)Bo Liu, Yuqian Jiang, Xiaohan Zhang, Qiang Liu, Shiqi Zhang, Joydeep Biswas, and Peter Stone.Llm+ p: Empowering large language models with optimal planning proficiency.arXiv preprint arXiv:2304.11477, 2023a.

- Liu et al. (2023b)Yi Liu, Gelei Deng, Zhengzi Xu, Yuekang Li, Yaowen Zheng, Ying Zhang, Lida Zhao, Tianwei Zhang, and Yang Liu.Jailbreaking chatgpt via prompt engineering: An empirical study, 2023b.

- Longpre et al. (2023)Shayne Longpre, Le Hou, Tu Vu, Albert Webson, Hyung Won Chung, Yi Tay, Denny Zhou, Quoc V Le, Barret Zoph, Jason Wei, et al.The flan collection: Designing data and methods for effective instruction tuning.arXiv preprint arXiv:2301.13688, 2023.

- Luo et al. (2023)Ziyang Luo, Can Xu, Pu Zhao, Qingfeng Sun, Xiubo Geng, Wenxiang Hu, Chongyang Tao, Jing Ma, Qingwei Lin, and Daxin Jiang.Wizardcoder: Empowering code large language models with evol-instruct.CoRR, abs/2306.08568, 2023.doi: 10.48550/arXiv.2306.08568.URL https://doi.org/10.48550/arXiv.2306.08568.

- Lv et al. (2023)Kai Lv, Yuqing Yang, Tengxiao Liu, Qinghui Gao, Qipeng Guo, and Xipeng Qiu.Full parameter fine-tuning for large language models with limited resources.CoRR, abs/2306.09782, 2023.doi: 10.48550/arXiv.2306.09782.URL https://doi.org/10.48550/arXiv.2306.09782.

- Mishra et al. (2022)Swaroop Mishra, Daniel Khashabi, Chitta Baral, and Hannaneh Hajishirzi.Cross-task generalization via natural language crowdsourcing instructions.In Smaranda Muresan, Preslav Nakov, and Aline Villavicencio (eds.), Proceedings of the 60th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), ACL 2022, Dublin, Ireland, May 22-27, 2022, pp. 3470–3487. Association for Computational Linguistics, 2022.doi: 10.18653/v1/2022.acl-long.244.URL https://doi.org/10.18653/v1/2022.acl-long.244.

- Muennighoff et al. (2023)Niklas Muennighoff, Thomas Wang, Lintang Sutawika, Adam Roberts, Stella Biderman, Teven Le Scao, M. Saiful Bari, Sheng Shen, Zheng Xin Yong, Hailey Schoelkopf, Xiangru Tang, Dragomir Radev, Alham Fikri Aji, Khalid Almubarak, Samuel Albanie, Zaid Alyafeai, Albert Webson, Edward Raff, and Colin Raffel.Crosslingual generalization through multitask finetuning.In Anna Rogers, Jordan L. Boyd-Graber, and Naoaki Okazaki (eds.), Proceedings of the 61st Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), ACL 2023, Toronto, Canada, July 9-14, 2023, pp. 15991–16111. Association for Computational Linguistics, 2023.doi: 10.18653/v1/2023.acl-long.891.URL https://doi.org/10.18653/v1/2023.acl-long.891.

- Nakano et al. (2021)Reiichiro Nakano, Jacob Hilton, Suchir Balaji, Jeff Wu, Long Ouyang, Christina Kim, Christopher Hesse, Shantanu Jain, Vineet Kosaraju, William Saunders, et al.WebGPT: Browser-Assisted Question-Answering with Human Feedback.arXiv preprint arXiv:2112.09332, 2021.

- Nye et al. (2021)Maxwell Nye, Anders Johan Andreassen, Guy Gur-Ari, Henryk Michalewski, Jacob Austin, David Bieber, David Dohan, Aitor Lewkowycz, Maarten Bosma, David Luan, Charles Sutton, and Augustus Odena.Show your work: Scratchpads for intermediate computation with language models, 2021.

- OpenAI (2023a)OpenAI.Gpt-3.5 turbo fine-tuning and api updates, 2023a.URL https://openai.com/blog/gpt-3-5-turbo-fine-tuning-and-api-updates.

- OpenAI (2023b)OpenAI.Gpt-4 technical report, 2023b.

- OpenAI (2023c)OpenAI.Chatgpt plugins, 2023c.URL https://openai.com/blog/chatgpt-plugins.

- Ouyang et al. (2022)Long Ouyang, Jeffrey Wu, Xu Jiang, Diogo Almeida, Carroll L. Wainwright, Pamela Mishkin, Chong Zhang, Sandhini Agarwal, Katarina Slama, Alex Ray, John Schulman, Jacob Hilton, Fraser Kelton, Luke Miller, Maddie Simens, Amanda Askell, Peter Welinder, Paul F. Christiano, Jan Leike, and Ryan Lowe.Training language models to follow instructions with human feedback.In NeurIPS, 2022.URL http://papers.nips.cc/paper_files/paper/2022/hash/b1efde53be364a73914f58805a001731-Abstract-Conference.html.

- Park et al. (2023)Joon Sung Park, Joseph C O’Brien, Carrie J Cai, Meredith Ringel Morris, Percy Liang, and Michael S Bernstein.Generative agents: Interactive simulacra of human behavior.arXiv preprint arXiv:2304.03442, 2023.

- Patil et al. (2023)Shishir G. Patil, Tianjun Zhang, Xin Wang, and Joseph E. Gonzalez.Gorilla: Large language model connected with massive apis.arXiv preprint arXiv:2305.15334, 2023.

- Press et al. (2022)Ofir Press, Muru Zhang, Sewon Min, Ludwig Schmidt, Noah A Smith, and Mike Lewis.Measuring and narrowing the compositionality gap in language models.arXiv preprint arXiv:2210.03350, 2022.

- Qin et al. (2023)Yujia Qin, Shihao Liang, Yining Ye, Kunlun Zhu, Lan Yan, Yaxi Lu, Yankai Lin, Xin Cong, Xiangru Tang, Bill Qian, et al.Toolllm: Facilitating large language models to master 16000+ real-world apis.arXiv preprint arXiv:2307.16789, 2023.

- Ren et al. (2023)Allen Z Ren, Anushri Dixit, Alexandra Bodrova, Sumeet Singh, Stephen Tu, Noah Brown, Peng Xu, Leila Takayama, Fei Xia, Jake Varley, et al.Robots that ask for help: Uncertainty alignment for large language model planners.arXiv preprint arXiv:2307.01928, 2023.

- Richards (2023)Toran Bruce Richards.AutoGPT, 2023.URL https://github.com/Significant-Gravitas/AutoGPT.

- Rozière et al. (2023)Baptiste Rozière, Jonas Gehring, Fabian Gloeckle, Sten Sootla, Itai Gat, Xiaoqing Tan, Yossi Adi, Jingyu Liu, Tal Remez, Jérémy Rapin, Artyom Kozhevnikov, I. Evtimov, Joanna Bitton, Manish P Bhatt, Cristian Cantón Ferrer, Aaron Grattafiori, Wenhan Xiong, Alexandre D’efossez, Jade Copet, Faisal Azhar, Hugo Touvron, Louis Martin, Nicolas Usunier, Thomas Scialom, and Gabriel Synnaeve.Code llama: Open foundation models for code.ArXiv, abs/2308.12950, 2023.

- Rozière et al. (2023)Baptiste Rozière, Jonas Gehring, Fabian Gloeckle, Sten Sootla, Itai Gat, Xiaoqing Ellen Tan, Yossi Adi, Jingyu Liu, Tal Remez, Jérémy Rapin, Artyom Kozhevnikov, Ivan Evtimov, Joanna Bitton, Manish Bhatt, Cristian Canton-Ferrer, Aaron Grattafiori, Wenhan Xiong, Alexandre Défossez, Jade Copet, Faisal Azhar, Hugo Touvron, Louis Martin, Nicolas Usunier, Thomas Scialom, and Gabriel Synnaeve.Code llama: Open foundation models for code.CoRR, abs/2308.12950, 2023.doi: 10.48550/arXiv.2308.12950.URL https://doi.org/10.48550/arXiv.2308.12950.

- Sanh et al. (2022)Victor Sanh, Albert Webson, Colin Raffel, Stephen H. Bach, Lintang Sutawika, Zaid Alyafeai, Antoine Chaffin, Arnaud Stiegler, Arun Raja, Manan Dey, M Saiful Bari, Canwen Xu, Urmish Thakker, Shanya Sharma Sharma, Eliza Szczechla, Taewoon Kim, Gunjan Chhablani, Nihal V. Nayak, Debajyoti Datta, Jonathan Chang, Mike Tian-Jian Jiang, Han Wang, Matteo Manica, Sheng Shen, Zheng Xin Yong, Harshit Pandey, Rachel Bawden, Thomas Wang, Trishala Neeraj, Jos Rozen, Abheesht Sharma, Andrea Santilli, Thibault Févry, Jason Alan Fries, Ryan Teehan, Teven Le Scao, Stella Biderman, Leo Gao, Thomas Wolf, and Alexander M. Rush.Multitask prompted training enables zero-shot task generalization.In The Tenth International Conference on Learning Representations, ICLR 2022, Virtual Event, April 25-29, 2022. OpenReview.net, 2022.URL https://openreview.net/forum?id=9Vrb9D0WI4.

- Schick et al. (2023)Timo Schick, Jane Dwivedi-Yu, Roberto Dessì, Roberta Raileanu, Maria Lomeli, Luke Zettlemoyer, Nicola Cancedda, and Thomas Scialom.Toolformer: Language models can teach themselves to use tools.arXiv preprint arXiv:2302.04761, 2023.

- Shinn et al. (2023)Noah Shinn, Federico Cassano, Beck Labash, Ashwin Gopinath, Karthik Narasimhan, and Shunyu Yao.Reflexion: Language agents with verbal reinforcement learning.arXiv preprint arXiv:2303.11366, 2023.

- Su et al. (2023)Yixuan Su, Tian Lan, Huayang Li, Jialu Xu, Yan Wang, and Deng Cai.Pandagpt: One model to instruction-follow them all.CoRR, abs/2305.16355, 2023.doi: 10.48550/arXiv.2305.16355.URL https://doi.org/10.48550/arXiv.2305.16355.

- Sumers et al. (2023)Theodore Sumers, Shunyu Yao, Karthik Narasimhan, and Thomas L. Griffiths.Cognitive architectures for language agents, 2023.

- Taori et al. (2023)Rohan Taori, Ishaan Gulrajani, Tianyi Zhang, Yann Dubois, Xuechen Li, Carlos Guestrin, Percy Liang, and Tatsunori B. Hashimoto.Stanford alpaca: An instruction-following llama model.https://github.com/tatsu-lab/stanford_alpaca, 2023.

- Touvron et al. (2023a)Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timothée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, et al.Llama: Open and efficient foundation language models.arXiv preprint arXiv:2302.13971, 2023a.

- Touvron et al. (2023b)Hugo Touvron, Louis Martin, Kevin Stone, Peter Albert, Amjad Almahairi, Yasmine Babaei, Nikolay Bashlykov, Soumya Batra, Prajjwal Bhargava, Shruti Bhosale, Dan Bikel, Lukas Blecher, Cristian Canton-Ferrer, Moya Chen, Guillem Cucurull, David Esiobu, Jude Fernandes, Jeremy Fu, Wenyin Fu, Brian Fuller, Cynthia Gao, Vedanuj Goswami, Naman Goyal, Anthony Hartshorn, Saghar Hosseini, Rui Hou, Hakan Inan, Marcin Kardas, Viktor Kerkez, Madian Khabsa, Isabel Kloumann, Artem Korenev, Punit Singh Koura, Marie-Anne Lachaux, Thibaut Lavril, Jenya Lee, Diana Liskovich, Yinghai Lu, Yuning Mao, Xavier Martinet, Todor Mihaylov, Pushkar Mishra, Igor Molybog, Yixin Nie, Andrew Poulton, Jeremy Reizenstein, Rashi Rungta, Kalyan Saladi, Alan Schelten, Ruan Silva, Eric Michael Smith, Ranjan Subramanian, Xiaoqing Ellen Tan, Binh Tang, Ross Taylor, Adina Williams, Jian Xiang Kuan, Puxin Xu, Zheng Yan, Iliyan Zarov, Yuchen Zhang, Angela Fan, Melanie Kambadur, Sharan Narang, Aurélien Rodriguez, Robert Stojnic, Sergey Edunov, and Thomas Scialom.Llama 2: Open foundation and fine-tuned chat models.CoRR, abs/2307.09288, 2023b.doi: 10.48550/arXiv.2307.09288.URL https://doi.org/10.48550/arXiv.2307.09288.

- Vemprala et al. (2023)Sai Vemprala, Rogerio Bonatti, Arthur Bucker, and Ashish Kapoor.Chatgpt for robotics: Design principles and model abilities.CoRR, abs/2306.17582, 2023.doi: 10.48550/arXiv.2306.17582.URL https://doi.org/10.48550/arXiv.2306.17582.

- Wang et al. (2023a)Guanzhi Wang, Yuqi Xie, Yunfan Jiang, Ajay Mandlekar, Chaowei Xiao, Yuke Zhu, Linxi Fan, and Anima Anandkumar.Voyager: An open-ended embodied agent with large language models.arXiv preprint arXiv:2305.16291, 2023a.

- Wang et al. (2023b)Lei Wang, Chen Ma, Xueyang Feng, Zeyu Zhang, Hao Yang, Jingsen Zhang, Zhiyuan Chen, Jiakai Tang, Xu Chen, Yankai Lin, Wayne Xin Zhao, Zhewei Wei, and Ji-Rong Wen.A survey on large language model based autonomous agents, 2023b.

- Wang et al. (2023c)Xiao Wang, Weikang Zhou, Can Zu, Han Xia, Tianze Chen, Yuansen Zhang, Rui Zheng, Junjie Ye, Qi Zhang, Tao Gui, Jihua Kang, Jingsheng Yang, Siyuan Li, and Chunsai Du.Instructuie: Multi-task instruction tuning for unified information extraction.CoRR, abs/2304.08085, 2023c.doi: 10.48550/arXiv.2304.08085.URL https://doi.org/10.48550/arXiv.2304.08085.

- Wang et al. (2023d)Yizhong Wang, Yeganeh Kordi, Swaroop Mishra, Alisa Liu, Noah A. Smith, Daniel Khashabi, and Hannaneh Hajishirzi.Self-instruct: Aligning language models with self-generated instructions.In Anna Rogers, Jordan L. Boyd-Graber, and Naoaki Okazaki (eds.), Proceedings of the 61st Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), ACL 2023, Toronto, Canada, July 9-14, 2023, pp. 13484–13508. Association for Computational Linguistics, 2023d.doi: 10.18653/v1/2023.acl-long.754.URL https://doi.org/10.18653/v1/2023.acl-long.754.

- Wei et al. (2022a)Jason Wei, Maarten Bosma, Vincent Y. Zhao, Kelvin Guu, Adams Wei Yu, Brian Lester, Nan Du, Andrew M. Dai, and Quoc V. Le.Finetuned language models are zero-shot learners, 2022a.

- Wei et al. (2022b)Jason Wei, Xuezhi Wang, Dale Schuurmans, Maarten Bosma, Ed Chi, Quoc Le, and Denny Zhou.Chain of thought prompting elicits reasoning in large language models.arXiv preprint arXiv:2201.11903, 2022b.

- Weng (2023)Lilian Weng.Llm-powered autonomous agents.lilianweng.github.io, Jun 2023.URL https://lilianweng.github.io/posts/2023-06-23-agent/.

- Willison (2023)Simon Willison.Prompt injection: What’s the worst that can happen?https://simonwillison.net, 2023.URL https://simonwillison.net/2023/Apr/14/worst-that-can-happen/.

- Xi et al. (2023)Zhiheng Xi, Wenxiang Chen, Xin Guo, Wei He, Yiwen Ding, Boyang Hong, Ming Zhang, Junzhe Wang, Senjie Jin, Enyu Zhou, et al.The rise and potential of large language model based agents: A survey.arXiv preprint arXiv:2309.07864, 2023.

- Xu et al. (2023)Can Xu, Qingfeng Sun, Kai Zheng, Xiubo Geng, Pu Zhao, Jiazhan Feng, Chongyang Tao, and Daxin Jiang.Wizardlm: Empowering large language models to follow complex instructions.CoRR, abs/2304.12244, 2023.doi: 10.48550/arXiv.2304.12244.URL https://doi.org/10.48550/arXiv.2304.12244.

- Yang et al. (2018)Zhilin Yang, Peng Qi, Saizheng Zhang, Yoshua Bengio, William Cohen, Ruslan Salakhutdinov, and Christopher D. Manning.HotpotQA: A dataset for diverse, explainable multi-hop question answering.In Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing, pp. 2369–2380, Brussels, Belgium, October-November 2018. Association for Computational Linguistics.doi: 10.18653/v1/D18-1259.URL https://aclanthology.org/D18-1259.

- Yao et al. (2022a)Shunyu Yao, Howard Chen, John Yang, and Karthik Narasimhan.Webshop: Towards scalable real-world web interaction with grounded language agents.Advances in Neural Information Processing Systems, 35:20744–20757, 2022a.

- Yao et al. (2022b)Shunyu Yao, Jeffrey Zhao, Dian Yu, Nan Du, Izhak Shafran, Karthik Narasimhan, and Yuan Cao.React: Synergizing reasoning and acting in language models.arXiv preprint arXiv:2210.03629, 2022b.

- Yao et al. (2023)Shunyu Yao, Dian Yu, Jeffrey Zhao, Izhak Shafran, Thomas L Griffiths, Yuan Cao, and Karthik Narasimhan.Tree of thoughts: Deliberate problem solving with large language models.arXiv preprint arXiv:2305.10601, 2023.

- Zelikman et al. (2022)Eric Zelikman, Yuhuai Wu, Jesse Mu, and Noah Goodman.STaR: Bootstrapping reasoning with reasoning.Advances in Neural Information Processing Systems, 35:15476–15488, 2022.

- Zhang et al. (2023a)Hang Zhang, Xin Li, and Lidong Bing.Video-llama: An instruction-tuned audio-visual language model for video understanding.CoRR, abs/2306.02858, 2023a.doi: 10.48550/arXiv.2306.02858.URL https://doi.org/10.48550/arXiv.2306.02858.

- Zhang et al. (2023b)Shengyu Zhang, Linfeng Dong, Xiaoya Li, Sen Zhang, Xiaofei Sun, Shuhe Wang, Jiwei Li, Runyi Hu, Tianwei Zhang, Fei Wu, and Guoyin Wang.Instruction tuning for large language models: A survey.CoRR, abs/2308.10792, 2023b.doi: 10.48550/arXiv.2308.10792.URL https://doi.org/10.48550/arXiv.2308.10792.

- Zhang et al. (2023c)Yanzhe Zhang, Ruiyi Zhang, Jiuxiang Gu, Yufan Zhou, Nedim Lipka, Diyi Yang, and Tong Sun.Llavar: Enhanced visual instruction tuning for text-rich image understanding.CoRR, abs/2306.17107, 2023c.doi: 10.48550/arXiv.2306.17107.URL https://doi.org/10.48550/arXiv.2306.17107.

- Zhang et al. (2020)Yizhe Zhang, Siqi Sun, Michel Galley, Yen-Chun Chen, Chris Brockett, Xiang Gao, Jianfeng Gao, Jingjing Liu, and William B Dolan.Dialogpt: Large-scale generative pre-training for conversational response generation.In Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics: System Demonstrations, pp. 270–278, 2020.

- Zhou et al. (2023a)Chunting Zhou, Pengfei Liu, Puxin Xu, Srini Iyer, Jiao Sun, Yuning Mao, Xuezhe Ma, Avia Efrat, Ping Yu, Lili Yu, Susan Zhang, Gargi Ghosh, Mike Lewis, Luke Zettlemoyer, and Omer Levy.LIMA: less is more for alignment.CoRR, abs/2305.11206, 2023a.doi: 10.48550/arXiv.2305.11206.URL https://doi.org/10.48550/arXiv.2305.11206.

- Zhou et al. (2023b)Shuyan Zhou, Frank F Xu, Hao Zhu, Xuhui Zhou, Robert Lo, Abishek Sridhar, Xianyi Cheng, Yonatan Bisk, Daniel Fried, Uri Alon, et al.WebArena: A Realistic Web Environment for Building Autonomous Agents.arXiv preprint arXiv:2307.13854, 2023b.

附录 A 额外结果

A.1 EM 分数的标准误差

表 6:使用标准误差 () 的提示方式结果。

| 提示方式 | EM 分数 | 标准误差 | |

|---|---|---|---|

| GPT-4 | IO | 37.2 | 2.16 |

| CoT | 45.0 | 2.22 | |

| ReAct | 42.0 | 2.21 | |

| GPT-3.5 | IO | 22.4 | 1.86 |

| CoT | 28.0 | 2.01 | |

| ReAct | 31.4 | 2.08 |

表 7:提示方式与微调的对比,包括绝对/相对增长和标准误差 ()。

| ReAct 方式 | FireAct 方式 | 绝对/相对增长 | 标准误差 | 标准误差 | |

|---|---|---|---|---|---|

| Llama-2-7B | 14.8 | 26.2 | +11.4 / 77% 的增长 | 1.59 | 1.97 |

| Llama-2-13B | 21.2 | 34.4 | +13.1 / 62% 的增长 | 1.83 | 2.12 |

| CodeLlama-7B | 17.4 | 27.8 | +10.4 / 60% 的增长 | 1.69 | 2.00 |

| CodeLlama-13B | 20.8 | 29.0 | +8.2 / 39% 的增长 | 1.82 | 2.03 |

| CodeLlama-34B | 22.2 | 27.8 | +5.6 / 25% 的增长 | 1.86 | 2.00 |

| GPT-3.5 | 31.4 | 39.2 | +7.8 / 25% 的增长 | 2.08 | 2.18 |

表 8:使用 GPT-3.5 的多任务结果和标准误差 ()。

| | HotpotQA | | | | StrategyQA | | | | | :--- | :---: | | | | :---: | | | | :---: | :---: | :---: | :---: | :---: | :---: | | | EM(精确匹配) | (标准差) | EM(精确匹配) | (标准差) | EM(精确匹配) | (标准差) | EM(精确匹配) | (标准差) | | 提示方法 (Prompting) | | | | | | | | | | IO(输入输出) | 22.4 | 1.86 | 48.0 | 2.23 | 7.2 | 1.16 | 68.6 | 2.08 | | CoT(链式思考) | 28.0 | 2.01 | 49.0 | 2.24 | 41.6 | 2.20 | 50.8 | 2.24 | | ReAct | 31.4 | 2.08 | 61.0 | 2.18 | 40.8 | 2.20 | 58.6 | 2.20 | | 微调 (Fine-tuning) | | | | | | | | | | HotpotQA | 39.2 | 2.18 | - | - | 44.0 | 2.22 | - | - | | 多任务 (Multi-task) | 39.2 | 2.18 | 55.5 | 2.19 | 43.2 | 2.20 | 63.2 | 2.16 | | + CoT | 39.6 | 2.19 | 72.9 | 1.99 | 50.4 | 2.24 | 65.8 | 2.12 |

A.2 稳定性测试分析

| | | 标准情况 | 无干扰 | 随机干扰 | | :----------------------------- | :----------------: | :------: | :----: | :------: | ----- | | ReAct | | 31.4 | 20.8 | 22.6 | | :--- | | :---: | :---: | :---: | :---: | | FireAct | 单一任务、单一方法 | 39.2 | 33.6 | 37.2 | | 同时处理多任务,但使用单一方法 | 39.2 | 34.8 | 36.2 | | 单一任务,采用多种方法 | 41.0 | 36.4 | 38.4 | | 同时处理多任务,且采用多种方法 | 39.6 | 35.2 | 37.0 |

表 9:不同任务与方法对比结果分析。

A.3 数据融合分析

| 使用多种方法微调的语言智能体 | 对话轮次数 | ||||||

| 效能模型 (EM) | 均值 () | 标准差 () | |||||

| 单一智能体方法 | 输入输出 (IO, 提示) | 22.4 | 0 | 0 | |||

| 问题链 (CoT, 提示) | 28.0 | 0.8 | 0.4 | ||||

| 反应调整 (ReAct, 微调) | 39.4 | 3.2 | 1.4 | ||||

| 反思调整 (Reflexion, 微调) | 39.8 | 3.5 | 2.6 | ||||

| 选择的智能体方法 | 对话轮次数 | ||||||

| 效能模型 (EM) | 均值 () | 标准差 () | |||||

| 实际应用 | 随机选择一种方法 | 32.4 | - | - | |||

| 最佳单一方法选择 | 39.8 | 3.5 | 2.6 | ||||

| 理论上最佳选择 | 始终选择最优方法 | 52.0 | 1.3 | 1.1 | |||

| 混合多种智能体方法 (FireAct) | 对话轮次数 | ||||||

| 反应调整 (ReAct) | 输入输出 (IO) | 问题链 (CoT) | 反思调整 (Reflexion) | 效能模型 (EM) | 均值 () | 标准差 () | |

| 39.4 | 2.4 | 1.8 | |||||

| 41.0 | 2.6 | 1.6 | |||||

| 41.2 | 3.3 | 1.6 |

| | √ | √ | × | × | 40.2 | 3.3 | 1.5 | | | √ | × | √ | √ | 40.0 | 3.0 | 4.8 | | | √ | × | √ | × | 41.0 | 2.7 | 1.7 | | | √ | × | × | √ | 38.8 | 3.8 | 2.8 |

表 10: 混合智能体方法在 HotpotQA 上的研究

表 10 展示了模型在不同情况下的最低和最高性能。模型的最低性能是通过随机选择一个智能体方法得到的,而最高性能则是通过总是选择最好的智能体方法来回答问题得到的。这两种方法得到的结果分别是 32.4 和 52.0 的准确率(EM)。我们的目标是让语言智能体通过使用多种智能体方法来微调,以期达到理论上的最佳性能,虽然这在实际中难以实现。实验结果显示,结合不同数据的方法使模型的性能都达到或超过了平均水平和最好基线,显示出性能的一致提升。特别是加入了 CoT 方法后,模型的性能得到了显著提升。尽管 CoT 方法单独使用时表现不佳(根据表 2,准确率仅为 28.0),但其与其他数据结合后对整体微调过程有正面影响。表 10 同时总结了我们对不同混合智能体方法在微调语言智能体时的效果研究。研究结果表明,使用不同混合方法时,智能体的准确率(EM)范围从 38.8 到 41.0。

A.4 转换分布分析

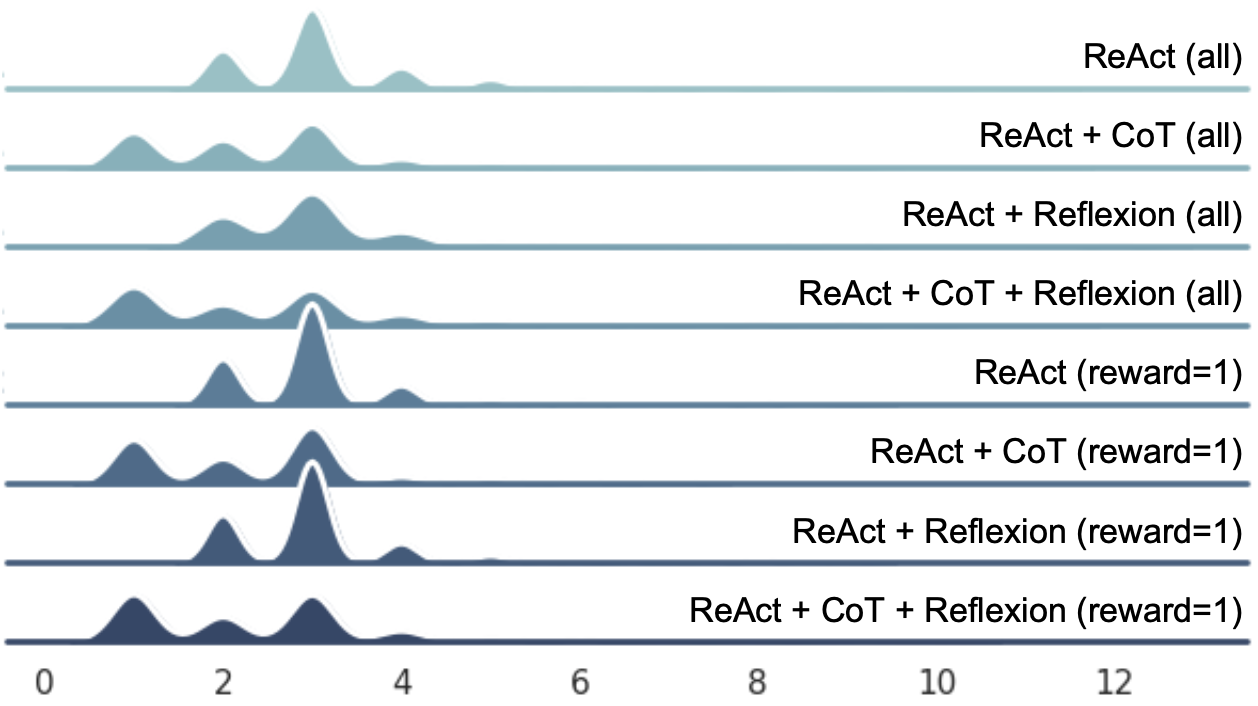

图 6 展示了通过数据组合可以改变其分布,使之更接近训练数据。特别是在比较 ReAct+CoT(平均 2.7 转,41.0 精确匹配得分(Exact Match, EM))和 ReAct+CoT(平均 3.8 转,38.8 EM)时,这一点变得尤为突出。

图 6:转换分布图

A.5 LoRA 与完全微调比较

| LoRA | Full | |

|---|---|---|

| 26.2 | 30.2 | |

| 27.0 | 30.0 | |

| 38MB | 14GB |

表 11:LoRA 与完全微调在单任务和多任务环境下的性能比较。

表 11 展示了在单任务环境(基于 500 个 HotpotQA 轨迹的微调)和多任务环境(混合所有轨迹)下,LLama-2-7B 分别采用 LoRA(局部重新赋权)和完全微调的精确匹配得分(EM)。

A.6CodeLLama 与 Llama Tokenizer 的性能对比

| Llama Tokenizer | CodeLLama Tokenizer | 绝对/相对差异 | |

|---|---|---|---|

| CodeLlama-7B | 26.6 | 27.8 | +1.2 / 4.5% |

| CodeLlama-13B | 27.4 | 29.0 | +1.6 / 5.8% |

表 12: Llama Tokenizer 和 CodeLLama Tokenizer 在 CodeLlama 性能上的差异。

表 12 对比了在 CodeLlama 模型上使用 Llama Tokenizer 和 CodeLLama Tokenizer 的效果。这里为 CodeLlama 模型的两个版本,CodeLlama-7B 和 CodeLlama-13B,在 HotpotQA 上的 EM 分数提供了数据。

A.7 世界建模:遮蔽观察技术

表 13 指出,在 CodeLlama-7B 模型中引入遮蔽观察技术(即在模型处理数据时部分隐藏信息)通常能略微提高性能。这种改进在 ReAct + CoT(一种结合反应和连续推理的配置)设置中最为显著。然而,对于 CodeLlama-13B 模型而言,遮蔽观察的影响因配置不同而有所差异:在某些配置中表现出性能提升,而在其他配置中则无显著变化。这个表格详细展示了在 HotpotQA(一种复杂的问题回答任务)中,遮蔽观察如何影响 CodeLlama 模型的性能,每种配置下的性能指标也为进一步研究提供了数据。目前的实验设置表明,学习世界建模技术对性能的影响并不总是一致的。

| 带观察遮蔽技术 | 无观察遮蔽技术 | |

| CodeLlama-7B | ||

| ReAct | 26.0 | 26.2 |

| ReAct + CoT | 24.0 | 22.2 |

| ReAct + 反射思考 | 25.2 | 24.8 |

| ReAct + 反射思考 + CoT | 26.0 | 24.8 |

| CodeLlama-13B | ||

| ReAct | 34.6 | 34.4 |

| ReAct + CoT | 24.8 | 30.2 |

| ReAct + 反射思考 | 30.6 | 30.6 |

| ReAct + 反射思考 + CoT | 27.2 | 31.0 |

表 13: 在 HotpotQA 问题解答任务中,使用或不使用遮蔽观察技术微调 Llama-2-7B 和 Llama-2-13B 的性能差异。

A.8 训练周期

图 7: GPT-3.5-Turbo 在 HotpotQA 数据集上的性能随着微调训练周期 (fine-tuning epochs) 增加而变化

表 7 展示了 GPT-3.5 模型在 HotpotQA 数据集上的性能随着微调训练周期的变化情况。随着微调周期从 1 增加到 4,精确匹配 (EM) 和 F1 分数通常都会提高,这表明在提供精确答案和整体答案质量上的准确度有所增加。然而,当训练周期超过 4 后,虽然精确匹配分数继续略有提升,F1 分数却趋于稳定,甚至有时下降,这表明额外的微调训练收益逐渐减少。

A.9 FireAct 在少样本任务泛化方面的表现

| StrategyQA | Bamboogle | MMLU | |

| 微调过的 Llama-2-7B + 少样本提示 (Fine-tuned Llama-2-7B + Few-shot Prompt) | |||

| IO | 44.1 | 0 | 5.4 |

| CoT | 27.0 | 0 | 4.2 |

| ReAct | 52.0 | 35.2 | 34.0 |

| 原始模型 + 少样本 ReAct (Vanilla Models + Few-shot ReAct) | |||

| Llama-2-7B | 59.0 | 11.2 | 33.2 |

| GPT-3.5 | 61.0 | 40.8 | 58.6 |

表 14: Llama-2-7B 在 HotpotQA 轨迹数据上经过微调后的多任务结果。

附录 B 实验详情

B.1 基础模型

在我们的研究中,我们着重于三个主要的大语言模型 (LLM) 家族的基础模型。首先是生成式预训练 Transformer (GPT) 系列,它包括了 GPT-4 (由 OpenAI 在 2023b 年发布) 和 GPT-3.5,还有 LLama-2 (由 Touvron et al. 在 2023b 年发表) 和 CodeLlama (由 Rozière et al. 在 2023 年发表)。GPT-3.5 是基于 GPT-3 (Brown et al., 2020) 进行优化的版本,拥有 1750 亿参数,能够以类似人类的方式理解和生成文本,适用于多种任务和领域。GPT-4 被认为是当今最先进的大语言模型之一,GPT-3.5 和 GPT-4 均能在无需事先准备数据的情况下(即零样本情境)使用多种工具,并具备插件 2 这一特性。其次,LLama-2 系列包括多种大语言模型,参数范围从 70 亿到 700 亿,这些模型已经显示出使用工具的初步迹象,但其性能还需进一步验证。最后,CodeLlama 系列是专为代码生成设计的模型,它基于 LLama-2 开发,参数范围从 70 亿到 340 亿,通过一系列的训练和微调步骤,使 LLama-2 在编程领域的性能得到了专业化和增强。

B.2 单方法单任务设置

我们首先从 HotpotQA 训练集中选取了一些样本,并让 GPT-4 模型(OpenAI, 2023b)基于这些样本生成了 500 条 ReAct 轨迹,这些轨迹是在少样本的示例基础上,借助人类参与验证过程的方式来对 AI 智能体进行微调的结果。此外,我们还从原有的 7,405 个开发集样本中挑选了 500 个样本用于评估,评估标准包括精确匹配(EM)和 F1 分数。对于 GPT-3.5,我们使用了名为 GPT-3.5-Turbo-0613 的特定微调版本,这个版本是通过 OpenAI 微调 API 3 进行调整的。Llama-2 和 CodeLlama 则采用了名为 Llama-2-Chat-HF 和 CodeLlama-Instruct-HF 的微调版本,这些版本是在 A100-80GB、RTX 6000 Ada、RTX 4090 和 RTX 3090 GPU 上,应用了一种名为低秩适应(Low-Rank Adaptation, LoRA)(Hu et al., 2022)的技术,并结合了 int8 量化技术进行微调的。对 GPT-3.5-Turbo-0613 的微调是在 3 个训练周期内完成的,而 Llama-2 和 CodeLlama 系列的微调则进行了 30 个训练周期。我们对于 ReAct 格式算法设定了一个硬性限制,即如果在 11 步内未完成,则停止。学习率设置为 3e-4,训练批次大小为 16。在进行模型评估时,Llama 和 Codellama 模型的温度设置为 0.6,而 GPT-3.5 的温度则为 0。我们还对这些模型使用了 int8 量化技术进行了额外的评估。

B.3 计算 Llama 和 CodeLlama

表 15 展示了用于微调 (fine-tuning) 和推理 (inference) Llama-2 和 CodeLlama 模型的计算资源。

| 训练 GPU | 每秒处理的示例数 | 推理 GPU | |

| LoRA 微调 (Fine-tuning) | |||

| Llama-2-7B | 1 个 RTX 4090 - 24GB | 5.4 | 1 个 RTX 4090 - 24GB |

| Llama-2-13B | 1 个 RTX 4090 - 24GB | 2.5 | 1 个 RTX 4090 - 24GB |

| CodeLlama-7B | 1 个 RTX 4090 - 24GB | 5.5 | 1 个 RTX 4090 - 24GB |

| CodeLlama-13B | 1 个 RTX 4090 - 24GB | 2.2 | 1 个 RTX 4090 - 24GB |

| CodeLlama-34B | 1 个 RTX 6000 Ada - 48GB | 0.9 | 1 个 RTX 6000 Ada - 48GB |

| 完全微调 (Full Fine-tuning) | |||

| Llama-2-7B | 4 个 A100 - 80GB | 19.7 | 1 个 RTX 4090 - 24GB |

表 15: 训练和推理 Llama-2 和 CodeLlama 模型时使用的计算资源。

附录 C 提示 (CPrompts)

Hotpot QA 提问与答案 问题:科罗拉多造山带东部的海拔范围是多少? 答案:1,800 到 7,000 英尺 问题:Allie Goertz 创作了一首关于《辛普森一家》中 Milhouse 角色的歌曲,这个角色是由 Matt Groening 命名的,他是以谁的名字来命名的? 答案:Richard Nixon 问题:是哪部纪录片介绍了芬兰摇滚乐队,是 Adam Clayton Powell 还是 The Saimaa Gesture? 答案:The Saimaa Gesture 问题:Nicholas Ray 和 Elia Kazan 有哪些共同职业? 答案:导演、编剧、演员 问题:哪本杂志更早创立,是 Arthur’s Magazine 还是 First for Women? 答案:Arthur’s Magazine 问题:Pavel Urysohn 和 Leonid Levin 是否从事相同类型的工作? 答案:是

连锁思考提问与答案 问题:科罗拉多造山带东部的海拔范围是多少? 思考:科罗拉多造山带东部延伸至高原地带,这里的海拔从 1,800 英尺升至 7,000 英尺。 答案:1,800 到 7,000 英尺 问题:Allie Goertz 创作了一首关于《辛普森一家》中 Milhouse 角色的歌曲,这个角色是由 Matt Groening 命名的,他是以谁的名字来命名的? 思考:Milhouse 这个角色是以美国前总统 Richard Nixon 的名字来命名的。 答案:Richard Nixon 问题:是哪部纪录片介绍了芬兰摇滚乐队,是 Adam Clayton Powell 还是 The Saimaa Gesture? 思考:《Adam Clayton Powell》这部电影是关于一位非裔美国政治家的纪录片,并非关于芬兰摇滚乐队,所以介绍芬兰摇滚乐队的应该是《The Saimaa Gesture》。 答案:The Saimaa Gesture 问题:Nicholas Ray 和 Elia Kazan 有哪些共同职业? 思考:Nicholas Ray 是导演、编剧和演员,而 Elia Kazan 则是导演、制片人、编剧和演员,他们共同的职业包括导演、编剧和演员。 答案:导演、编剧、演员 问题:哪本杂志更早创立,是 Arthur’s Magazine 还是 First for Women? 思考:Arthur’s Magazine 创立于 1844 年,而 First for Women 则在 1989 年创立。 答案:Arthur’s Magazine

《Arthur’s Magazine》成立于 1844 年,早于 1989 年创刊的《First for Women》,因此《Arthur’s Magazine》是更早的杂志。问:Pavel Urysohn 和 Leonid Levin 是否以相同领域的工作闻名?思考:Pavel Urysohn 是数学家,而 Leonid Levin 同时是数学家和计算机科学家。因此,Pavel Urysohn 和 Leonid Levin 的工作领域是相同的。答:是。ReAct 旨在通过交错的思考(Thought)、行动(Action)和观察(Observation)步骤来解决问题回答任务。在此过程中,“思考”步骤用于对当前情况进行推理分析,“行动”步骤有两种形式:(1) search[question],即在谷歌上搜索问题,并返回包含答案的简短摘要。需要注意的是,有时候摘要中可能不包含答案,这时可能需要进行其他的搜索。(2) finish[answer],即给出答案并完成任务。例如,问题:科罗拉多造山运动东部区域的海拔范围是多少?(待续)

Hotpot QA 提示 – 接上一页内容 思考:我首先需要确定科罗拉多造山带东部扩展到何处,然后查找其海拔范围。 操作:搜索[科罗拉多造山带东部扩展到哪里?] 观察 1:高原 思考:我接下来要找出高原的海拔范围。 操作:搜索[高原的海拔范围?] 观察:大约在 1,800 至 7,000 英尺 思考:我找到答案了。 操作:结束[1,800 至 7,000 英尺] 观察:事件完成,奖励 = 1 问题:音乐家及讽刺艺术家 Allie Goertz 创作了一首歌,歌曲讲述了《辛普森一家》中的角色 Milhouse,这个角色是 Matt Groening 根据谁的名字命名的? 思考:我需要查找 Milhouse 这个名字的由来。 观察:美国前总统 Richard Nixon 思考:我找到答案了。 操作:结束[Richard Nixon] 观察:事件完成,奖励 = 1 问题:关于芬兰摇滚乐队的纪录片是《Adam Clayton Powell》还是《赛马亚手势》(The Saimaa Gesture)? 思考:我要搜索关于《Adam Clayton Powell》和《赛马亚手势》的纪录片,以确认哪部是关于芬兰摇滚乐队的。 操作:搜索[《Adam Clayton Powell》纪录片] 观察:《Adam Clayton Powell》(1989)。纪录片。这部被提名奥斯卡奖的纪录片深入探讨了这位极具影响力人物的生活和职业历程。 思考:我不确定它是否与芬兰摇滚乐队相关。我需要进一步搜索确认《Adam Clayton Powell》的内容。 操作:搜索[《Adam Clayton Powell》] 观察:Powell 连续近三十年当选,成为民主党的重要国家政治家,同时也是民权问题的国家级发言人... 思考:《Adam Clayton Powell》是关于一位政治家的,而不是芬兰摇滚乐队。我接下来需要查找《赛马亚手势》的内容。 操作:搜索[《赛马亚手势》纪录片] 观察:这是一部关于三支芬兰摇滚乐队在 SS Heinävesi 蒸汽船上环绕赛马亚湖巡演的纪录片。《赛马亚手势》。

本片由 Aki 导演...【思考】《Saimaa Gesture》讲述了三个芬兰摇滚乐队的故事,因此答案应是《Saimaa Gesture》。【操作完成】[《Saimaa Gesture》]【观察】任务完成,奖励为 1 分【问题】Nicholas Ray 和 Elia Kazan 共同从事的职业是什么?【思考】我需要查询 Nicholas Ray 和 Elia Kazan 的职业背景,找出他们的共同点。【操作】查询[Nicholas Ray 职业]【观察】纽约市,美国。职业包括电影导演、编剧、演员。活跃年份为 1946 至 1979 年。婚姻状况记录。【思考】Nicholas Ray 的职业是电影导演、编剧、演员。接下来我要查询 Elia Kazan。【操作】查询[Elia Kazan 职业]【观察】职业涵盖演员、导演、制片人、编剧。活跃年份为 1934 至 1976 年。配偶为 Molly Day Thacher Kazan,婚姻维持至 1963 年她去世。【思考】Elia Kazan 的职业涉及演员、导演、制片人、编剧。因此,他们的共同职业是演员、导演、编剧。【操作完成】[演员、导演、编剧]【观察】任务完成,奖励为 1 分

MMLU 问题输入输出 (IO) 单选题:当一个人从家中取水桶往院子的池塘中加水时,随着水量的增加,池塘最终会 A. 膨胀 B. 破裂 C. 下沉 D. 淹没。答案:A。单选题:煤炭原本是沼泽中的有机物,经过时间演变成固态岩石。这说明煤炭的形成过程是 A. 主要由动物骨骼组成 B. 由时间凝固的岩浆转化而来 C. 在去水后迅速变成石化物 D. 经过数百万年的地质变化。答案:D。单选题:学生用以下特征来描述太空中的某种物体:* 约 200 亿颗恒星* 距地球 3000 万光年* 直径约 500 光年。这描述最可能指的是 A. 星系 B. 宇宙 C. 星座 D. 太阳系。答案:A。链式思考 (CoT) 单选题:当一个人从家里拿水桶向池塘里加水时,池塘最终会 A. 膨胀 B. 破裂 C. 下沉 D. 淹没。思考:每加一桶水,池塘水位就会升高。在所有选项中,只有“膨胀”与水位升高相符,因此答案是 A。答案:A。单选题:煤炭是从沼泽中的有机物质转化成的固态岩石。这表明煤炭的形成过程是 A. 主要由动物骨骼组成 B. 由时间凝固的岩浆转化而来 C. 在去水后迅速变成石化物 D. 经过数百万年的地质变化。思考:评估各选项,A 项错误,因为煤炭主要由植物组成,而非动物骨骼;B 项也错误,因为岩浆凝固形成的是火成岩,非煤炭;C 项不正确,石化过程与煤炭形成无直接关联。

煤炭的形成是一个漫长的过程,包括了沉积和变质等缓慢的地质活动,这表明这些过程持续了数百万年。因此,这一选项是正确的。答案是 D.

问题 单选:一位学生用以下特征来描述宇宙中的一组物体:

- 200 亿颗恒星

- 距离地球 3000 万光年

- 直径 500 光年 他最有可能描述的是什么? A. 星系 B. 宇宙 C. 星座 D. 太阳系 思考: 让我们评估每个选项。A. 星系:可能,因为星系通常包含数以亿计的恒星,且可能位于离地球数百万光年远的地方。B. 宇宙:不太可能,因为宇宙的规模远超 3000 万光年,且包含的恒星数量远超 200 亿。C. 星座:不太可能,星座是从地球上看到的恒星图案,并没有具体的大小或距离。D. 太阳系:绝对不是,我们的太阳系只有一颗恒星——太阳。因此,答案最可能是 A. 星系。 答案 A 继续下一页

MMLU 提示续篇: ReAct 解决一个问题回答任务,该任务涉及交替进行的思考、行动和观察步骤。思考环节用于分析当前情况,行动环节则分为两种类型:(1) search[question] (搜索[问题]),指在 Google 上搜索某个问题并返回包含答案的简短信息。但有时这些信息可能不包含答案,这时就需要进行其他搜索。(2) finish[answer] (完成[答案]),则是给出答案并结束任务。 下面是一些示例: 问题 单项选择:一个人从家中取水桶加水至院子的池塘。水加到一定量后,池塘会 A. 膨胀 B. 破裂 C. 下沉 D. 淹没 思考 不断向池塘加水,最终水量会超过其承载能力,导致膨胀。因此,答案是 A。 行动 完成[A] 观察 任务完成,奖励 = 1 问题 单项选择:煤炭是从沼泽中沉积的有机物质转化而成的固体岩石。关于煤炭的形成,以下说法正确的是, A. 煤炭主要由动物骨骼构成。 B. 煤炭由经年累月凝固的岩浆形成。 C. 去除水分后,煤炭很快变成石化。 D. 煤炭的形成是一个持续数百万年的地质过程。 思考 这个问题涉及煤炭的形成过程。首先,我需要弄清楚煤炭是怎样形成的。 行动 搜索[煤炭是如何形成的?] 观察 煤炭的形成需要数百万年。它包含了数百万年前生长在沼泽森林中植物所储存的能量。这些植物被泥土和岩石覆盖了数百万年,压力和热量将它们转化为煤炭。 思考 根据这些信息,我可以逐一排查每个选项。A 项错误,因为煤炭是由植物而非动物形成的。B 项和 C 项我还没有足够信息判断,可以分别搜索“煤炭是否由岩浆形成”和“煤炭在去水后是否迅速石化”以确认。D 项表述煤炭需要数百万年形成,这与所了解的信息一致,因此可能正确。

我可以搜索“煤的形成是否属于地质过程”来进行验证。操作:搜索[煤的形成是否属于地质过程]。观察:煤是由植物残留物形成的,这些残留物在地质年代中经历了压缩、硬化、化学变化,以及在热量和压力作用下的变质。思考:看来煤的形成确实发生在地质年代内,因此属于地质过程。因此,答案是 D。操作结束:[D]。观察:任务完成,奖励 = 1。问题(单选):一个学生用以下特征描述太空中的一组对象:* 200 亿颗恒星* 距离地球 30 万光年* 直径 500 光年。以下哪项最可能是该学生所描述的?A. 星系 B. 宇宙 C. 星座 D. 太阳系。思考:这些选项分别对应不同大小的太空系统。为了找出答案,我可以搜索每个选项的直径。操作:搜索[星系的直径是多少]。观察:大多数星系的直径在 1,000 到 100,000 角秒(约 3,000 到 300,000 光年),它们之间的距离大约是数百万角秒(或数百万光年)。(待续)

MMLU Prompts - 续前页 思考:一般来说,星系的直径在 3,000 到 300,000 光年之间,稍微超过 500 光年。我接下来要搜索的是宇宙的直径。 动作:search[宇宙的直径是多少] 观察:930 亿光年 思考:宇宙的直径有 930 亿光年,远超 500 光年。下一步,我要搜索星座的直径。 动作:search[星座的直径是多少] 观察:星座的直径竟然超过了 10 天文单位(AU)(15 亿公里!),几乎可以填满整个内太阳系,直到接近木星的位置。 思考:通常,一个星座的直径约为 10 天文单位。我需要把这个数值转换成光年。 动作:search[10 AU 转换为光年] 观察:0.000158125 光年 思考:一般而言,星座的直径大约是 0.000158125 光年,远小于 500 光年。接下来,我要搜索太阳系的直径。 动作:Sedna 比地球远离冥王星的距离还要远三倍,因此是太阳系中已知最远的可观测物体。它离太阳约 1437.3 亿公里,这样一来,太阳系的直径大约是 2874.6 亿公里。 思考:太阳系的直径约为 2874.6 亿公里。我需要将这个数字转换成光年。 动作:search[2874.6 亿公里转换成光年] 观察:0.0303845459748716 光年 思考:通常情况下,星座的直径大约是 0.0303845459748716 光年,远小于 500 光年。综合考虑所有直径的信息,星系的直径与 500 光年最为接近。因此,答案是 A。 动作:finish[A] 观察:剧情结束,奖励 = 1

在这个策略 QA (问答) 系列中,我们通过简单的是或否问题和答案来探索不同的话题。

问题: Rede Globo 的主播会讲中文吗? 答案: 否。 原因: Rede Globo 是巴西的电视网络,其主播通常说葡萄牙语,这是巴西的官方语言。虽然他们可能会说其他语言,但中文不太可能是他们常用的语言。

问题: 2017 年的学生是否会忘记 9/11 事件? 答案: 是。 原因: 这个问题探讨的是人们对历史事件的记忆,尤其是对那些在他们成长过程中发生的重大事件。

问题: 豌豆荚里的豌豆数量是否足够表示一个十亿的数字中的逗号数量? 答案: 是。 原因: 一般来说,一个豌豆荚里有 6 到 9 粒豌豆。而十亿(1,000,000,000)是一个需要三个逗号来表示的大数字,这个数字的逗号数量比一个豌豆荚中豌豆的平均数量少。

问题: 圣文森特和格林纳丁斯使用的语言是否源自英语? 答案: 是。 原因: 这些岛屿曾是英国的殖民地,英语在那个时期成为了主要语言。

1979 年获得独立后,英语依然作为官方语言在教育、政府、媒体及日常交流中发挥着重要作用。英语已深入社会各个层面,并被广泛使用,尽管当地方言和口音可能对该地区的英语口语产生影响。因此,答案是肯定的。回答这个问题,我们可以采用思考 (Thought)、行动 (Action) 和观察 (Observation) 交织的步骤。在思考阶段,我们分析当前情境;在行动阶段,我们可以采取两种方式:(1) 使用 search[question] 在 Google 上查询问题,并得到包含答案的简短片段。但有时这个片段可能并不包含答案,这时可能需要进行其他搜索。(2) 使用 finish[answer] 来得出答案并完成这个任务。例如,问题是:“乔治亚州的 Albany 人口会在纽约州的 Albany 之前达到十万吗?”首先,我需要查找乔治亚州 Albany 的人口,然后是纽约州 Albany 的人口,并进行比较。行动是搜索[乔治亚州 Albany 当前人口是多少?]。观察结果显示,基于我们对最新美国人口普查估计的投影,乔治亚州 Albany 目前的人口为 68,181。2020 年的最后一次官方美国人口普查记录了... 接下来,我会搜索[纽约州 Albany 当前人口是多少?]。敬请翻到下一页以获取更多信息。

战略问答提示 - 接续前一页内容 观察 根据我们对最新美国人口普查数据的预测,纽约州奥尔巴尼目前的人口为 97,593 人。 2020 年的最后一次官方美国人口普查记录了... 思考 2020 年,纽约奥尔巴尼的人口为 97,593 人,这比乔治亚州的奥尔巴尼多。因此,乔治亚州的奥尔巴尼不会在纽约州的奥尔巴尼之前达到十万人口,答案是否。 行动 结束处理[否] 观察 情节结束,获得奖励 1 分 问题 是或否:Rede Globo 的主播会说中文吗? 思考 我需要先了解什么是 Rede Globo。 行动 搜索[Rede Globo 是什么?] 观察 电视 Globo,原名 Rede Globo,是一家巴西的免费地面电视网络,由媒体业主 Roberto Marinho 于 1965 年 4 月 26 日创立。 思考 Rede Globo 是一家巴西电视网络,而巴西不是一个讲中文的国家,因此 Rede Globo 的主播不会说中文。 行动 结束处理[否] 观察 情节结束,获得奖励 1 分 问题 是或否:2017 年级的学生会对 9/11 事件有失忆吗? 思考 学生对 9/11 事件的认知取决于他们在事件发生时的年龄,如果当时年龄太小,他们就不会有直接的记忆。因此,我需要先了解 2017 年级的学生当时多大年龄。 行动 搜索[2017 年级的学生是何时出生的?] 观察 2017 年级的毕业生多数出生于 1999 年。他们成长的世界中,有《星球大战:魅影危机》。Midichlorians、Jar-Jar 和豆荚赛车一直是他们所知的《星球大战》世界。 思考 如果一个学生约在 1999 年出生,那么他们在 2001 年的 9/11 袭击时大约只有 2 岁。我需要了解哪个年龄段的孩子会出现失忆现象。 行动 搜索[哪个年龄段的孩子会有失忆?] 观察 尽管婴儿会利用记忆来学习新信息,但很少有成年人能够记住他们在三岁以前生活中的事件。

艾默里大学的心理学家最近发现,孩子们通常在七岁时会开始遗忘最早的记忆,这种现象被称为“童年失忆症”。这种失忆现象发生在三岁以前的事件上,因此 2017 年班级的学生对 9/11 事件通常会有记忆缺失。完成此观察后,获得奖励为 1。问:豌豆荚中平均豌豆数量的逗号是否足以表示十亿个数?我需要了解豌豆荚中平均豌豆的数量,以及用于表示十亿的逗号数量,然后进行比较。搜索问题:“豌豆荚中平均豌豆数量是多少?”观察结果显示,每个豌豆种子都会长成一个豌豆植株,平均每个植株有 6 个荚,每个荚包含 8 个豌豆,总共 48 个豌豆。因此,豌豆荚中平均的豌豆数量是 8 个。接下来,我需要知道在表示十亿时会用到多少个逗号。搜索问题:“十亿中有多少个逗号?”观察结果表明,十亿表示为“1,000,000,000”,共有三个逗号。因此,豌豆荚中的平均豌豆数量(8 个)确实大于表示十亿时使用的逗号数量(3 个),所以答案是肯定的。完成此观察后,获得奖励为 1。