NVIDIA 公布了到 2027 年的 GPU 和互连路线图 [译]

Timothy Prickett Morgan

![NVIDIA 公布了到 2027 年的 GPU 和互连路线图 [译]](https://www.nextplatform.com/wp-content/uploads/2024/06/nvidia-computex-2024-jensen-logo-1030x438.jpg)

在计算、网络和图形的发展历史上,Nvidia 有许多独特之处。此刻,它拥有大量资金,并且凭借其架构、工程和供应链在生成式 AI (generative AI) 市场中占据了领先地位,使其能够随心所欲地制定任何可能带来进展的路线图。

早在 2000 年代,Nvidia 已经是一家非常成功的创新企业,实际上并不需要进入数据中心计算领域。然而,高性能计算 (HPC) 研究人员将 Nvidia 引入了加速计算的世界,随后 AI 研究人员利用 GPU 计算开创了一个全新的市场,这个市场等待了四十年,终于迎来了计算能力与海量数据的结合,真正实现了令人感觉像思考机器的存在。

向 Danny Hillis、Marvin Minsky 和 Sheryl Handler 致敬,他们在 20 世纪 80 年代成立 Thinking Machines 时,试图构建这样的机器,以推动 AI 处理,而不是传统的 HPC 模拟和建模应用。还有 Yann LeCun,他在同一时间在 AT&T Bell Labs 创建了卷积神经网络。当时他们既没有足够的数据也没有足够的计算能力来实现我们现在所知的 AI。那时,黄仁勋是 LSI Logic 的主管,该公司制造存储芯片,之后他成为 AMD 的 CPU 设计师。正如 Thinking Machines 在 1990 年代初期遇到困难并最终破产时,黄仁勋在圣何塞东部的 Denny’s 餐厅与 Chris Malachowsky 和 Curtis Priem 见面,并共同创立了 Nvidia。Nvidia 预见到了研究和超大规模计算社区中的 AI 机会,开始开发系统软件和基础的并行硬件,实现了自计算机诞生以来一直存在的 AI 革命梦想。

这始终是计算发展的最终状态,也是我们一直在追求的奇点——或者说双极性。如果其他星球上有生命,那么这些生命总会进化到拥有大规模杀伤性武器和创造人工智能的阶段,而且很可能是在同一时期。这个世界在那个时刻之后对这些技术的处理方式,将决定它是否能在大规模灭绝事件中幸存下来。

这听起来可能不像是一个关于芯片制造商路线图的常规介绍。确实不是,因为我们生活在有趣的时代。

在台北举行的年度 Computex 贸易展上的主题演讲中,Nvidia 的联合创始人兼首席执行官再次尝试将生成式 AI 革命——他称之为第二次工业革命——置于其背景之中,并让我们瞥见了 AI 的未来,特别是 Nvidia 硬件的未来。他还展示了 GPU 和互连的路线图——据我们所知,这并不是计划中的一部分,直到最后一刻才决定的,这常常发生在黄仁勋的主题演讲中。

革命是不可避免的

生成式 AI 的关键在于规模,黄仁勋提醒我们,2022 年底的 ChatGPT 时刻之所以能实现,离不开技术和经济的共同推动。

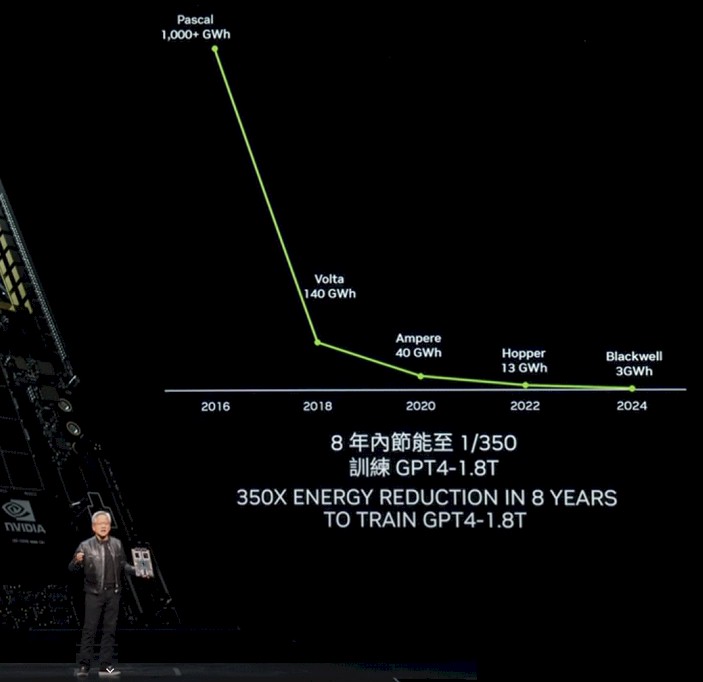

要迎来 ChatGPT 的突破,首先需要 GPU 性能的大幅提升,以及大量 GPU 的部署。Nvidia 在性能方面做出了重要贡献,这对于 AI 的训练和推理都至关重要。更重要的是,它显著减少了生成大语言模型响应中的 token(标记)所需的能量。请看图 1:

在“Pascal”P100 GPU 代和即将在今年晚些时候出货并将在 2025 年量产的“Blackwell”B100 GPU 代之间的八年里,GPU 性能提高了 1053 倍(图表中标示为 1000 倍,但并不精确)。

这种性能提升部分归功于浮点精度的降低——从 Pascal P100、Volta V100 和 Ampere A100 GPU 使用的 FP16 格式转变为 Blackwell B100 使用的 FP4 格式,浮点精度降低了 4 倍。借助数据格式、软件处理和硬件执行的数学优化,性能在不显著影响大语言模型表现的前提下提高了 263 倍。要知道,在 CPU 市场中,这已经是相当显著的提升了。通常,CPU 每时钟周期的核心性能仅能提高 10% 到 15%,核心数量增加 25% 到 30%。这意味着,在相同的八年里,如果升级周期为两年,CPU 吞吐量仅能增加 4 到 5 倍。

每单位工作的功率减少是一个关键指标,因为系统如果没有足够的供电,就无法使用。大语言模型 (LLM) 每个 token 的能耗必须下降,这意味着每个 token 生成的能耗下降速度要快于性能提升速度。

在他的主题演讲中,他提到,使用 Pascal P100 GPU 生成一个 token 需要大约 17,000 焦耳的能量,相当于两天内点亮两个灯泡。平均每个词需要大约三个 token。因此,如果生成大量单词,能耗将非常巨大!这也解释了为什么八年前无法运行一个大规模的 LLM 来完成任务。训练 GPT-4 专家混合模型 (Mixture of Experts LLM) 需要消耗巨大能量:该模型有 1.8 万亿参数,处理的数据量为 8 万亿个 token。

对于一个 P100 集群来说,超过 1,000 吉瓦时的能量消耗非常巨大,确实令人惊叹。

黄仁勋解释说,使用 Blackwell GPU,公司将在大约 10 天内使用约 10,000 个 GPU 训练这个 1.8 万亿参数的 GPT-4 专家混合模型。

如果 AI 研究人员和 Nvidia 不转向低精度,那么在这八年时间里,性能提升将只有 250 倍。

降低能源成本是一方面,降低系统成本是另一方面。随着传统摩尔定律的结束,这两方面都变得非常困难。以前每 18 到 24 个月缩小一次晶体管,芯片变得更便宜和更小。现在,计算复合体达到了光罩极限,每个晶体管变得越来越贵,因此,由晶体管制造的设备也变得越来越贵。HBM 内存和先进封装是主要成本。

在 GPU 插槽的 SXM 系列(不包括 PCI-Express 版本的 GPU)中,P100 的起始价格约为 $5,000;V100 的起始价格约为 $10,000;A100 的起始价格约为 $15,000;而 H100 的起始价格约为 $25,000 到 $30,000。预计 B100 的价格将在 $35,000 到 $40,000 之间——黄仁勋在今年早些时候接受 CNBC 采访时提到过 Blackwell 的价格。

黄仁勋没有展示每一代需要多少 GPU 来训练 GPT-4 1.8T MoE 模型,以及这些 GPU 或电力在运行中会花费多少。所以我们根据黄仁勋提到的需要大约 10,000 个 B100 来在大约十天内训练 GPT-4 1.8T MoE 的情况,制作了一个小表格。请看下表:

在这八年间,GPU 的价格上涨了 7.5 倍,但性能却提高了超过 1,000 倍。所以现在用 Blackwell 系统实际上可以在大约十天内训练一个像 GPT-4 这样拥有 1.8 万亿参数的大模型,而在两年前 Hopper 世代开始时,即使是几百亿参数的模型也很难在几个月内完成训练。而现在,系统成本将与两年的电力成本相当。(GPU 约占 AI 训练系统成本的一半,所以购买一个 10,000 GPU 的 Blackwell 系统大约需要 $800 百万,训练十天的电力成本大约为 $540,000。如果购买更少的 GPU,可以减少每天、每周或每月的电费,但训练时间也会相应增加,最终成本还是会上升。)

你无法获胜,也无法退出。

你知道吗?Nvidia 也遇到了类似的问题。所以情况就是这样。即使黄仁勋在 Computex 的主题演讲中表示,Hopper H100 GPU 平台是“可能是历史上最成功的数据中心处理器”,Nvidia 仍然需要继续努力。

顺便说一下,我们很想把 Hopper/Blackwell 的投资周期与六十年前 IBM 推出的 System/360 相比较。当时,IBM 进行了企业历史上最大的一次赌注,正如我们去年所提到的。1961 年,IBM 开始了“下一代产品线”研发项目,那时它的年收入是 22 亿美元,并在 1960 年代投入了超过 50 亿美元。Big Blue 是华尔街首家蓝筹公司,正因为它投入了两年的收入和二十年的利润来开发 System/360。虽然其中有些部分推迟了,表现也不尽如人意,但它彻底改变了企业数据处理的方式。IBM 原本预计到 1960 年代末将创造 600 亿美元的销售额(已按 2019 年美元价值调整),但实际达到了 1390 亿美元,其中利润约为 520 亿美元。

可以说,Nvidia 为数据中心计算的第二阶段掀起了更大的浪潮。所以现在或许真正的赢家可以称为绿色芯片公司?

抵抗是徒劳的

无论是 Nvidia 还是它的竞争对手或客户,都无法抗拒未来的吸引力和生成式 AI 带来的利润和生产力。这种前景不仅在我们的耳边低语,更是在屋顶上高声呐喊。

因此,Nvidia 决定加快步伐,迎接挑战。凭借 250 亿美元的银行存款和预计今年超过 1000 亿美元的收入,可能再增加 500 亿美元的存款,Nvidia 有能力推动创新,并带领我们走向未来。

“在这个令人难以置信的增长时期,我们要确保继续提升性能,降低训练和推理成本,并扩展 AI 能力,使每家公司都能受益。性能提升越多,成本下降越大。”

正如上表所示,这一切都是真实的。

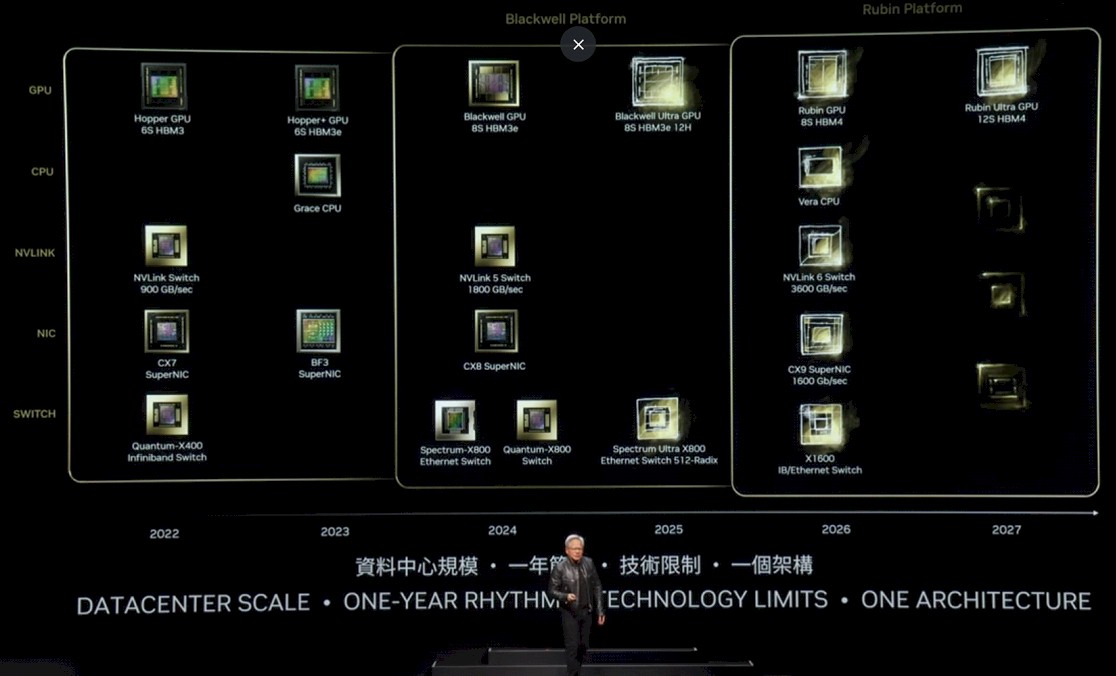

接下来是更新后的 Nvidia 平台路线图:

这个表可能有点难以阅读,我们来详细解释一下。

在 Hopper 代,原始的 H100 于 2022 年推出,配有六组 HBM3 内存,NVSwitch 通过 900 GB/秒的端口将它们连接在一起,并配有 400 Gb/秒端口的 Quantum X400(以前称为 Quantum-2)InfiniBand 交换机和 ConnectX-7 网络接口卡。2023 年,H200 升级为六组 HBM3E 内存,具有更高的容量和带宽,提升了 H200 包中的基础 H100 GPU 的有效性能。BlueField 3 网络接口卡也问世了,它在网络接口卡中添加了 Arm 核心,以便进行辅助工作。

到 2024 年,Blackwell GPU 已经推出,配有八组 HBM3e 内存,搭配 NVSwitch 5,具有 1.8 TB/秒的端口,800 Gb/秒的 ConnectX-8 网络接口卡,以及具有 800 GB/秒端口的 Spectrum-X800 和 Quantum-X800 交换机。

我们可以预测,到 2025 年,图表中称为 Blackwell Ultra 的 B200 将配备八个 12 层高的 HBM3e 内存堆栈。推测 B100 的堆栈为 8 层高,所以这应该意味着 Blackwell Ultra 的 HBM 内存容量至少增加 50%,具体增加多少取决于所使用的 DRAM 容量。HBM3E 内存的时钟速度也可能提高。Nvidia 对 Blackwell 系列的内存容量并未明确说明,但我们在 3 月的 Blackwell 发布会上推测,B100 将拥有 192 GB 的内存,带有 8 TB/sec的带宽。对于未来的Blackwell Ultra,我们预计会有更快的内存,不会惊讶地看到 288 GB 的内存和 9.6 TB/sec的带宽。

我们认为 Ultra 变体在 SM 上的产量有可能会有所改进,从而使其性能略高于非 Ultra 前辈。这将取决于产量。

Nvidia 还将在 2025 年推出更高基数的 Spectrum-X800 以太网交换机,可能通过在机箱中放置六个 ASIC 来创建无阻塞架构【如其他交换机常见做法】以加倍总带宽,因此要么加倍每端口的带宽,要么增加交换机中的端口数量。

在 2026 年,我们将看到“Rubin”R100 GPU【在去年发布的 Nvidia 路线图中,曾被称为 X100】。正如我们当时所说的,我们认为 X 是一个变量,不是任何东西的缩写。事实证明是正确的。Rubin GPU 将使用 HBM4 内存,并拥有八个可能高达 12 层的堆栈。而 2027 年的 Rubin Ultra GPU 将拥有 12 个 HBM4 内存堆栈,并且可能堆栈更高【尽管路线图没有说明】。

2026 年,Nvidia 将推出 Arm 服务器 CPU“Vera”,这是当前“Grace”CPU 的后续产品。NVSwitch 6 芯片将与这些产品配对,提供 3.6 TB/秒的端口,而ConnectX-9提供1.6 Tb/秒的端口。有趣的是,还有一种名为X1600 IB/Ethernet Switch 的设备,这可能意味着 Nvidia 正在融合其 InfiniBand 和以太网 ASIC,就像 Mellanox 十年前所做的那样。也可能只是 Nvidia 想让我们感到好奇。2027 年还有其他提示,这可能意味着 NIC 和交换机将得到全面的 Ultra Ethernet Consortium 支持,甚至可能推出用于在节点内部和机架之间连接 GPU 的 UALink 交换机。

这只是我们的玩笑。不过,更奇怪的事情也曾发生过。